NVIDIA Nemotron-Nano-9B-v2の革新性とビジネス戦略:Qwen3やGemma3を凌ぐSLMの実力

AI業界において、小型言語モデル(SLM:Small Language Model)の競争が激化する中、NVIDIAが2025年8月に発表した「Nemotron-Nano-9B-v2」が注目を集めています。このモデルは、中国製のQwen3-8Bをはじめ、Meta社のLlama、Google社のGemma3といった競合モデルを上回る性能を示しており、AI市場における新たな転換点となる可能性があります。

特に興味深いのは、NVIDIAがこのモデルを通じて単なるGPUベンダーから総合的なAIプラットフォーマーへと戦略転換を図っている点です。本記事では、Nemotron-Nano-9B-v2の技術的革新性と、その背景にあるNVIDIAの野心的なビジネス戦略について詳しく解説します。

目次

Nemotron-Nano-9B-v2とは:革新的なハイブリッドアーキテクチャ

NVIDIA Nemotron-Nano-9B-v2は、90億パラメータを持つ推論特化型の言語モデルです。このモデルの最大の特徴は、TransformerアーキテクチャとMambaアーキテクチャを組み合わせたハイブリッド構造を採用している点にあります。

従来のTransformerアーキテクチャの大部分の自己注意層をMamba-2層で置き換えることで、推論に必要な長い思考トレースを生成する際のスループットが大幅に改善されています。この技術的革新により、同等サイズの競合モデルと比較して最大6倍の処理速度を実現しているのです。

開発プロセスでは、まず120億パラメータのベースモデルを20兆トークンでプリトレーニングし、その後Minitron戦略を採用してモデルを圧縮・蒸留しています。この手法により、効率性と性能の両立を実現しています。

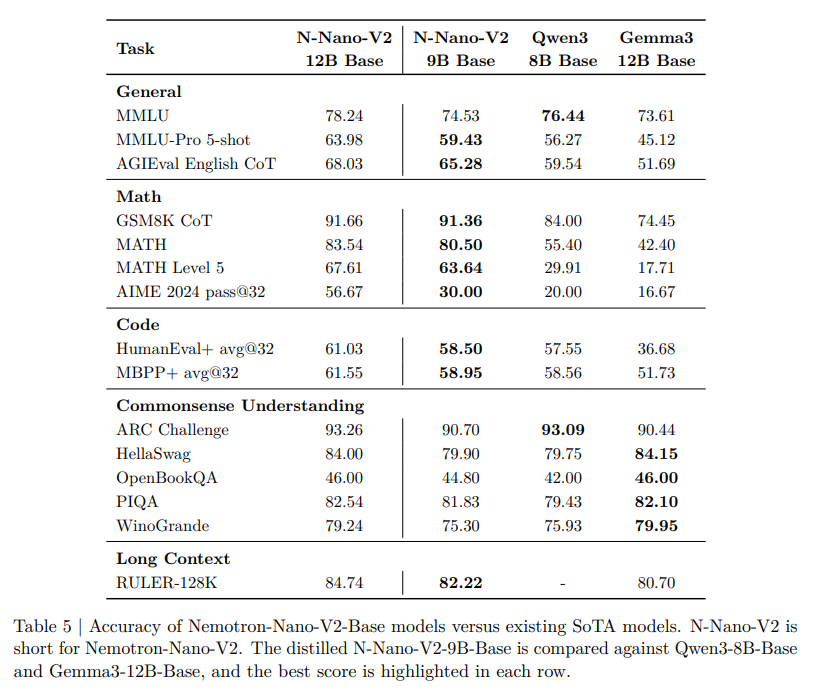

競合モデルとの性能比較:Qwen3、Gemma3を上回る実力

Nemotron-Nano-9B-v2の性能を理解するために、主要な競合モデルとの比較結果を詳しく見てみましょう。

Qwen3-8Bとの直接対決

中国製の高性能SLMとして知られるQwen3-8Bとの比較において、Nemotron-Nano-9B-v2は複数の重要な指標で優位性を示しています。

| 比較項目 | Nemotron-Nano-9B-v2 | Qwen3-8B |

| 推論精度 | 同等以上 | ベースライン |

| 処理速度 | 最大6倍高速 | 標準 |

| 長文処理 | 優位(差が拡大) | 標準 |

特に複雑な推論タスクにおいて、Nemotron-Nano-9B-v2は数学、科学、コーディングなどの分野でQwen3-8Bと同等かそれ以上の精度を達成しています。さらに、入力シーケンス長が長くなるほど処理速度の差は拡大する傾向を示しており、長文処理や複雑な推論タスクにおいて大きなアドバンテージとなっています。

Gemma3やLlamaとの比較結果

Google社のGemma3やMeta社のLlamaといった他の主要SLMとの比較においても、Nemotron-Nano-9B-v2は優秀な成績を収めています。

- LiveCodeBench:71.1という高スコアを記録

- GPQA:64のスコアを達成(一部でMeta社モデルが上回る場合もあり)

- Common Sense Understanding:Gemma3が優位なケースもあるものの、総合的にはNemotronが上回る

これらの結果から、Nemotron-Nano-9B-v2は現在利用可能なSLMの中でもトップクラスの性能を持つモデルであることが確認できます。

豊富なトレーニングデータセットの公開

NVIDIAは、Nemotron-Nano-9B-v2のトレーニングに使用したデータセットの大部分を公開しており、これは研究コミュニティにとって非常に価値の高い貢献です。

公開されたデータセットは6.6兆トークンで構成されており、以下の4つのカテゴリーに分類されています:

- プレミアムウェブクロールデータ:高品質なウェブコンテンツから抽出

- 数学に焦点を当てたデータ:数学的推論能力の向上を目的

- コードデータ:プログラミング関連のタスク対応

- 科学・学術・推論・多言語データ:幅広い知識領域をカバー

さらに、合成的に作成されたデータや小規模なサンプル群も含まれており、モデルの汎用性と専門性の両立を図っています。このような詳細なデータセット情報の公開は、研究者や開発者がモデルの特性を理解し、適切な用途に活用するための重要な指針となります。

ファインチューニングとローカル展開の容易さ

Nemotron-Nano-9B-v2の大きな魅力の一つは、ファインチューニングやローカル展開が前提として設計されている点です。

このモデルはHugging Face経由でダウンロードが可能で、自分の環境でローカルにダウンロード、トレーニング、ファインチューニングを行うことができます。これにより、企業や研究機関は以下のようなメリットを享受できます:

- データプライバシーの確保:機密データを外部に送信することなく、社内でモデルを活用可能

- カスタマイズの自由度:特定の業務や用途に合わせてモデルを調整

- コスト効率:クラウドAPIの利用料金を削減し、長期的なコスト最適化を実現

- レスポンス速度:ローカル環境での実行により、ネットワーク遅延を排除

特に、単一のNVIDIA A10G GPU(22GiB、bfloat16精度)で最大128kトークンの推論が可能という仕様は、多くの企業にとって現実的な導入コストでの運用を可能にしています。

NVIDIAの戦略的意図:ハードウェアからエコシステムへ

Nemotron-Nano-9B-v2の発表は、単なる新しいAIモデルのリリース以上の意味を持っています。これは、NVIDIAが推進する垂直統合戦略の重要な一環なのです。

GPUプラスソフトウェアの統合戦略

NVIDIAは、GPUで最適に動作する高性能モデルを提供することで、ハードウェアとソフトウェアの垂直統合を実現しようとしています。この戦略により、以下のような相乗効果を狙っています:

- ハードウェア販売の促進:Nemotronモデルの最適な性能を引き出すためにNVIDIA GPUの需要を創出

- 開発環境の囲い込み:NVIDIA提供のプラットフォームを使用することで、開発者をエコシステム内に取り込み

- 継続的な収益源:ハードウェア販売だけでなく、ソフトウェアライセンスやサポートサービスからの収益を確保

エンタープライズ向けSLM市場の獲得

Nemotron-Nano-9B-v2は、商用ライセンスフレンドリーな設計となっており、エンタープライズ向けSLM市場の獲得を明確に狙っています。企業がAI技術を導入する際の主要な懸念事項である以下の点に対応しています:

- ライセンスの明確性:商用利用における法的リスクの最小化

- 性能の保証:ベンチマークによる客観的な性能評価の提供

- サポート体制:企業導入に必要な技術サポートとドキュメンテーション

- セキュリティ:オンプレミス展開によるデータセキュリティの確保

NVIDIA NIMSとの連携:包括的なAI管理プラットフォーム

NVIDIAは、NemotronモデルファミリーをNVIDIA NIMS(NVIDIA Inference Microservices)という生成AIモデルの管理プラットフォームと連携させることで、より包括的なソリューションを提供しています。

NVIDIA NIMSは、様々なAIモデルを統一的に管理・運用するためのプラットフォームで、以下の機能を提供します:

- モデル管理:複数のAIモデルのバージョン管理と展開

- スケーリング:需要に応じた自動的なリソース調整

- 監視・分析:モデルの性能とリソース使用状況の可視化

- セキュリティ:企業レベルのセキュリティ機能とアクセス制御

この統合アプローチにより、NVIDIAはハードウェアの上位レイヤーも掌握し、AI開発から運用まで一貫したソリューションを提供することが可能になります。

AI市場における戦略的ポジショニング

NVIDIAのNemotron戦略は、AI市場における同社のポジションを大きく変える可能性があります。2025年3月のGTCにおいて、ジェンスン・フアンCEOが発表したエージェンティックAIとロボット分野を軸とする新戦略の一環として、Nemotronファミリーは重要な役割を果たしています。

エージェンティックAI市場への参入

NVIDIAは、AIエージェントが2028年までに最大4,500億ドルの収益増加とコスト削減をもたらすと予測しており、Nemotronモデルファミリーはこの戦略の中核を担っています。CrowdStrike、Uber、Zoomなどの業界リーダーが初期採用企業として参加しており、以下の分野での活用が期待されています:

- サイバーセキュリティ:脅威検知と対応の自動化

- モビリティ:自動運転技術の高度化

- コミュニケーション:リアルタイム翻訳と会議支援

- ロボティクス:産業用ロボットの知能化

競合他社との差別化戦略

OpenAI、Anthropic、Googleといった競合他社が大型モデル(LLM)に注力する中、NVIDIAは効率性と実用性を重視したSLM戦略で差別化を図っています。この戦略の特徴は以下の通りです:

- 実用性重視:企業が実際に導入・運用可能なサイズと性能のバランス

- オープンソース戦略:研究コミュニティとの協力による技術革新の加速

- ハードウェア最適化:自社GPUとの組み合わせによる最高性能の実現

- エコシステム構築:開発から運用まで一貫したソリューションの提供

まとめ

NVIDIA Nemotron-Nano-9B-v2は、技術的革新とビジネス戦略の両面で注目すべきモデルです。主要なポイントを以下にまとめます:

- 技術的優位性:TransformerとMambaのハイブリッドアーキテクチャにより、競合モデルを上回る性能と効率性を実現

- 実用性の高さ:ファインチューニングとローカル展開が容易で、企業導入に適した設計

- 戦略的意図:ハードウェアからソフトウェアまでの垂直統合により、AIエコシステム全体の掌握を目指す

- エンタープライズ対応:商用ライセンスフレンドリーな設計で、企業市場の獲得を狙う

- プラットフォーム戦略:NVIDIA NIMSとの連携により、包括的なAI管理ソリューションを提供

Nemotron-Nano-9B-v2の登場は、AI業界における新たな競争軸の形成を示唆しています。大型モデルの性能競争から、効率性と実用性を重視した実装可能なAIソリューションへと市場の関心がシフトする中、NVIDIAの戦略は多くの企業にとって魅力的な選択肢となる可能性があります。今後の技術革新と市場展開に注目が集まります。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1

NVIDIA Nemotron-Nano-9B-v2とは何ですか?

NVIDIA Nemotron-Nano-9B-v2は、NVIDIAが開発した90億パラメータを持つ推論特化型の小型言語モデル(SLM)です。TransformerアーキテクチャとMambaアーキテクチャを組み合わせたハイブリッド構造を持ち、高い処理速度と精度を実現しています。

Q2

Nemotron-Nano-9B-v2は、他のSLMと比較して何が優れていますか?

Nemotron-Nano-9B-v2は、特に処理速度において優位性があります。Qwen3-8Bと比較して最大6倍高速であり、長文処理や複雑な推論タスクにおいて高い性能を発揮します。また、LiveCodeBenchなどのベンチマークでも高いスコアを記録しています。

Q3

Nemotron-Nano-9B-v2はどのように利用できますか?

Nemotron-Nano-9B-v2はHugging Faceからダウンロードでき、ローカル環境でトレーニングやファインチューニングが可能です。これにより、データプライバシーを確保しつつ、特定の業務や用途に合わせてモデルをカスタマイズできます。単一のNVIDIA A10G GPUでも運用可能です。

Q4

NVIDIAがNemotron-Nano-9B-v2を開発した背景にある戦略は何ですか?

NVIDIAはNemotron-Nano-9B-v2を通じて、単なるGPUベンダーから総合的なAIプラットフォーマーへと戦略転換を図っています。ハードウェアとソフトウェアの垂直統合を進め、エンタープライズ向けSLM市場の獲得を目指しています。NVIDIA NIMSとの連携もその一環です。

Q5

Nemotron-Nano-9B-v2のトレーニングに使用されたデータセットは公開されていますか?

はい、NVIDIAはNemotron-Nano-9B-v2のトレーニングに使用した6.6兆トークンのデータセットの大部分を公開しています。これには、プレミアムウェブクロールデータ、数学に焦点を当てたデータ、コードデータ、科学・学術・推論・多言語データが含まれています。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、

AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、

チャンネル登録数は18万人超(2025年7月時点)。