MiniMax-M2がついにリリース|2025年最も重要なAIモデルかもしれない理由

AI業界では、GPT-5、Claude Sonnet 4.5、Gemini 2.5 Proなどの主要モデルが、ベンチマークを通じて常に話題の中心にありました。

そこに登場したのが、MiniMax-M2という新しいオープンウェイトモデルです。

シリコンバレーの最先端システムに迫る性能を主張しつつ、modified-MITライセンスでモデルウェイトが無料公開されており、ローカルホスティングやファインチューニング、エージェント型ワークフローへの組み込みが自由に行えます。時期によっては、公式APIが期間限定で無料提供されることもあります。

こうした条件が重なったMiniMax-M2の登場は、AI業界の勢力図が再び動き始めたシグナルと言えるでしょう。

この記事では、MiniMax-M2の性能、アーキテクチャ、ベンチマーク、強み・弱点、そしてなぜこのモデルが2025年後半で特に注目を集めるオープンウェイトモデルの一つになっているのかを解説します。

目次

MiniMax-M2とは?|基本情報と特徴

MiniMax-M2は、以下の用途に最適化された新しいオープンウェイトの大規模言語モデル(LLM)です。

Hugging Face:https://huggingface.co/MiniMaxAI/MiniMax-M2

GitHub:https://github.com/MiniMax-AI/MiniMax-M2

- コーディング

- 論理的推論

- 長文コンテキストを必要とするエージェント型ワークフロー

- 複数ファイルにまたがる分析

- 自己修正ループ

独特なアーキテクチャ

MiniMax-M2は、総パラメータ数2300億という巨大なモデルでありながら、推論時にはわずか100億パラメータのみを活性化させる仕組みを採用しています。これは、Sparse Mixture-of-Experts(MoE)アーキテクチャと、ルーターによるスパースなエキスパート選択によって実現されています。

つまり、中規模LLMのフットプリント(メモリ使用量)でありながら、最上位モデルに近い知能を持つという、いいとこ取りの設計なのです。

✅ モデルウェイトは無料でダウンロード可能

✅ 公式APIは期間限定で無料提供されている場合があります

✅ modified-MITライセンスでオープンウェイトとして公開

Llama 3がもたらした衝撃と同じような転換点を、MiniMax-M2が再び作り出そうとしています。しかも初期のテスト結果を見る限り、M2は推論タスクにおいてさらに競争力が高い可能性があります。

巨大なパラメータ数なのに軽量って、どういうことですか?

MiniMax-M2は「Mixture-of-Experts(MoE)」という仕組みを使っています。総パラメータ数は2300億ですが、実際に推論時に動くのはわずか100億パラメータだけです。例えるなら、230人の専門家チームがいるけれど、毎回の質問には最適な10人だけが答える、というイメージです。だから巨大なモデルの賢さを持ちながら、メモリ使用量は中規模モデル並みに抑えられるのです。

主な機能|それぞれの能力を深掘り

多くの記事では箇条書きで済まされがちですが、MiniMax-M2は通常のオープンウェイトLLMとは一線を画すため、各機能には詳しい説明が必要です。

1. 学術・論理領域における高度な知能

MiniMax-M2は、リリース時点でArtificial AnalysisのIntelligence Indexにおいて、オープンウェイトモデル中で第1位と報告されています。特に強みを発揮するのは以下の分野です。

- 数学的問題解決

- 構造化された推論

- 指示への正確な追従

- ステップバイステップの論理的な分解

- 科学および定量的タスク

多くのパラメータクラスのモデルが、深い推論の連鎖で苦戦する中、M2は長いシーケンスにわたって一貫性を保ち、複数ステップのタスクでもハルシネーション(誤った情報の生成)を最小限に抑えます。

これにより、推論のゴールドスタンダードとされてきたGPT-5やSonnet 4.5と同じ土俵で語られるレベルに到達しています。

2. 次世代レベルのコーディング能力

これがMiniMax-M2の最大の目玉機能です。

MiniMax-M2ができること

- 複数ファイルで構成されたリポジトリ全体を読み取り、理解する

- 複数ステップの修正ループを実行する

- ファイル全体を推測するのではなく、コードの一部分を書き換える

- 自分が行った変更を検証する

- 大規模プロジェクト全体で長期的なコンテキストを保持する

実際の使用感としては、単なるテキスト生成ツールというよりも、ジュニアエンジニアのような協力者として振る舞うと表現されています。

初期ビルドをテストした開発者たちからは、以下のような声が上がっています

✅ 他のオープンウェイトLLMに比べてハルシネーションが少ない

✅ バグの診断においてよりエージェント的に動作する

✅ コードの背後にある意図をより深く分析できる

オープンウェイトモデルにとって、これは大きな前進です。

3. エージェントモードと長文コンテキスト自動化

このモデルは、拡張されたコンテキストウィンドウとエージェント的なルーチンをサポートしています。

これにより可能になること

- ドキュメント検索ワークフロー

- 複数ステップの意思決定

- 計画タスク

- 長期的な自動化(例:12ステップのビジネスプロセスを通して実行)

- 大規模データセット全体にわたるリサーチスタイルの要約

MiniMax-M2は、持続的な推論ループの中で動作し、論理を適用しながら自分の出力を調整できます。オープンモデルとしてはまだ初期段階ですが、この能力は確実に存在しています。

4. 巨大なパラメータ数にもかかわらず高い効率性

M2は、Mixture-of-Experts(専門家の混合)スタイルのアーキテクチャを採用しています。

仕組み

- 総パラメータ数は2300億

- 推論時に活性化されるのはわずか100億

- 各トークンごとにルーターが一部のエキスパートだけをスパースに選択する設計

これには2つの大きなメリットがあります

✅ 高い知能の上限

✅ ハードウェアに優しい動作

量子化を行えば、ハイエンドコンシューマー向けGPUでも限定的に動作可能です。ただし、フル性能を引き出すには、データセンターグレードのGPU構成が推奨されています。

「複数ファイルの修正ループ」って、通常のAIとどう違うんですか?

従来のAIは「コードを書いて終わり」ですが、MiniMax-M2は「コードを書く→実行する→エラーを見つける→修正する」という一連の流れを自動で繰り返します。しかも複数ファイルをまたいで分析できるので、例えば「index.jsとconfig.jsの両方を見ながらバグを直す」といった実践的な作業が可能です。まるでジュニアエンジニアと一緒に作業しているような感覚ですね。

GPT-5、Claude Sonnet 4.5、Gemini 2.5との比較|本当に匹敵するのか?

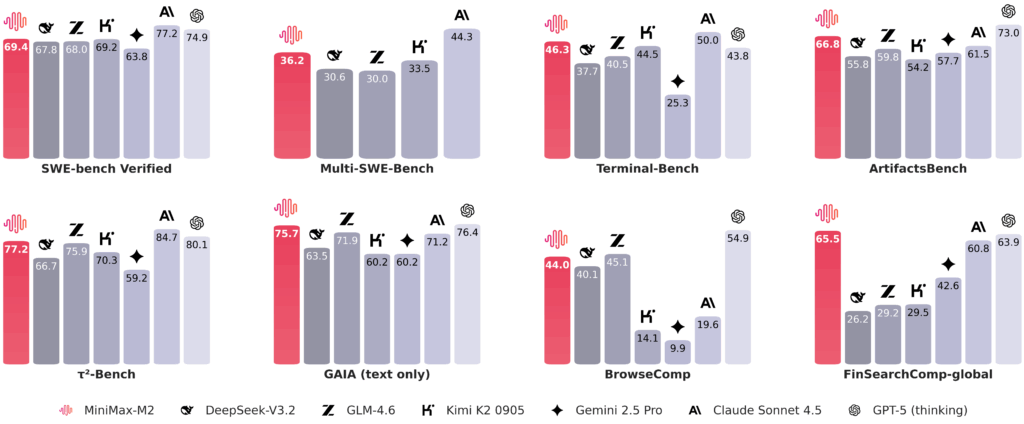

出典:MiniMaxAI/MiniMax-M2 · Hugging Face

MiniMax-M2は、オープンウェイトモデルとして最高水準を達成し、一部のベンチマークではプロプライエタリモデルに迫る性能を示しています

以下、主要な比較をご紹介します。

1. 推論タスク

- GPT-5に近い水準(M2: 61、GPT-5: 68 on Artificial Analysis)

- 一部のベンチマークでGemini 2.5 Proを上回る結果を示しています

- Sonnet 4.5と近い水準

推論は通常、クローズドソースモデルが最も得意とする領域です。それだけに、この結果は驚きです。

2. コーディングタスク

MiniMax-M2は、複数ファイルの分析と修正ループによって際立っています。

ベンチマーク結果:

- SWE-bench Verified: 69.4 (GPT-5: 74.9、Claude Sonnet 4.5: 77.2)

- Terminal-Bench: 46.3 (GPT-5: 43.8、Claude Sonnet 4.5: 50.0)

その動作は以下に似ています

- Claude 3.5 Sonnetのコードインタプリタ

- GPT-5のCode Pilotモード

ただし、M2はローカルで実行でき、自由に改変できるという点が決定的に異なります。

3. 長文コンテキストワークフロー

M2が総合的に最高というわけではありませんが、非常に競争力があります。

- 拡張マルチモーダル推論では、Gemini 2.5 ProやGemini 3 ProといったGoogle Geminiシリーズが依然としてトップクラス

- GPT-5がそれに続く

- ただし、活性化パラメータが100億のモデルとしては、M2の性能は衝撃的に高いレベルです

4. コストとアクセス性

ここでMiniMax-M2は圧倒的に優位です。

- GPT-5 → 有料APIアクセスが必要($1.25/$10 per million tokens)

- Claude Sonnet 4.5 → サブスクリプション契約が必要

- Gemini 2.5 Pro → クラウドクレジットの割り当てが必要

- MiniMax-M2 → モデルウェイト無料、API $0.30/$1.20 per million tokens(期間限定で無料)

エージェントシステムを運用する場合や、大量のワークロードが必要な場合、コストは決定的な要因になります。M2を使えば、その障壁が大幅に下がります。

「オープンウェイト」って何ですか?普通のAIと何が違うんでしょうか?

オープンウェイトとは、AIモデルの中身(パラメータ)が公開されていて、誰でもダウンロードして使えるモデルのことです。GPT-5やClaude Sonnet 4.5のような「クローズドモデル」は、企業のサーバーでしか動かせず、API経由でしか使えません。一方、MiniMax-M2のようなオープンウェイトモデルは、自社サーバーで動かしたり、カスタマイズしたり、ファインチューニングしたりが自由にできます。セキュリティやコスト管理の面で大きなメリットがあります。

これがアメリカのモデルプロバイダーにとって警告である理由

GPT-5やClaude Sonnet 4.5は、クローズドでプロプライエタリなシステムで動作しています。彼らの堀(競争優位性)は常に以下でした

- 性能

- 安全性

- エコシステムの成熟度

- インフラ

しかし、オープンウェイトの代替品が、コア推論とコーディングのユースケースにおいて彼らに近づき始めると、価値の方程式が変化します。

1. オープンウェイトはロックインを減らす

- 開発者は自前でホスティングできるモデルを好む

- 企業は監査可能なモデルを好む

- スタートアップはファインチューニングできるモデルを好む

性能が近づくと、オープンウェイトが選ばれることが多いのです。

2. 価格モデルにプレッシャーがかかる

無料のモデルが多くのタスクでGPT-5に近い品質を提供すると、企業は有料利用を減らします。

これは以下に直接影響します

- 収益

- 再投資

- R&D予算

これは、Llama 3が中堅APIの利用に与えた影響と似ています。

3. インフラの優位性だけではもう十分ではない

OpenAIは依然として以下の恩恵を受けています

- Azure統合

- Nvidiaへの優先アクセス

- エンタープライズ契約

しかし、有能な無料モデルが急速に改善すれば、この優位性は縮小します。

MiniMax-M2が今日すぐにGPT-5やホスト型Claudeをエンタープライズ向けに置き換えることはないかもしれませんが、重要なトレンドラインを設定していることは間違いありません。

歴史的背景|オープンウェイト知能モデルの台頭

MiniMax-M2は真空の中に現れたわけではありません。

過去2年間で、強力なオープンモデルが次々と登場しました。

- Qwenシリーズ

- DeepSeek-R1

- Llama 3(2024年4月)

- InternLM

- Phi 4 Mini(Microsoftの効率的なライン)

これらはすべて、クローズドソースモデルだけが世界クラスの性能を達成できるという概念を少しずつ崩してきました。

M2は、その次のエスカレーションです。

MiniMax-M2の実際の活用シーン

1. ソフトウェア開発チーム

MiniMax-M2の複数ファイルコード分析と修正ループは、以下に最適です。

- デバッグ

- リファクタリング

- CI駆動のコードレビュー

- リポジトリの近代化

- コード移行ワークフロー

オープンウェイトであるため、プライベートな開発環境に直接組み込むことが可能です。

2. 自動化とエージェントワークフロー

以下を運用しているチームに最適

- AIビジネスエージェント

- タスク自動化システム

- リサーチボット

- カスタマーサポート自動化

M2の推論と長文コンテキスト処理能力により、持続的な自律的パフォーマンスを実現できます。

3. 学術・研究タスク

このモデルは以下に優れています

- 数学的問題の解決

- 科学的コンテンツの処理

- 構造化されたステップバイステップの推論の生成

大規模な計算予算を持たない学生、研究者、教育機関にとって、ローカル展開は極めて有益です。

4. 内部ツールを構築するAIスタートアップ

その効率性のおかげで、M2は以下の基盤として強力です

- ファインチューンされたアシスタント

- AI駆動のSaaSツール

- ワークフロー駆動のアプリケーション

- ドメイン固有のコパイロット

API契約を交渉することなく、モデルを完全に改変できます。

MiniMax-M2の強み|詳細分析

1. サイズに対して例外的なコーディング能力

複数ステップの修正ループを実行し、変更を検証する能力は、ほとんどのオープンモデルと一線を画します。

2. 高レベルの推論性能

オープンウェイトモデルとして最高水準の推論性能を達成していることは、驚くべき成果です。

3. オープンウェイトでローカル展開が可能

これは、アクセス性、コスト、長期的なコントロールに影響します。

4. 効率的なルーティングシステム

パラメータのごく一部だけを活性化することで、比較的軽量なハードウェアでも動作可能になります。

限界と、まだ遅れている領域

MiniMax-M2は印象的ですが、完璧なモデルではありません。

1. マルチモーダル能力は限定的

トップクラスのプロプライエタリモデルに見られる豊かなマルチモーダル推論や動画理解には及びません。

2. エコシステムの成熟度はまだ後れを取っている

GPTとClaudeには以下があります

- 洗練されたUX

- 安定したAPI

- 十分にテストされたツール群

MiniMaxは追いついていますが、まだ完全ではありません。

3. 長文コンテキストメモリは良好だが、最先端レベルではない

超長文コンテキストタスクでは、Gemini 2.5 ProやGemini 3 ProといったGoogle Geminiシリーズが依然としてリードしています。

4. 安全性とガードレールの堅牢性が低い

多くのオープンウェイトモデルと同様、ハルシネーション制御は弱めです。

5. 出力の冗長性

M2は「インターリーブ思考」アーキテクチャにより、出力トークン数が多くなる傾向があります。この点はコスト計算時に考慮が必要です。

グローバルAI業界への広範な影響

1. ハイエンド知能の民主化

コスト障壁を大幅に下げることで、より多くの個人や小規模企業がトップクラスのAI性能にアクセスできるようになります。

2. オープンウェイト志向へのシフト

プロプライエタリモデルは、開発者エコシステムにおいて市場シェアを失う可能性があります。

3. AI研究の加速

研究者は、最先端レベルのアイデアをローカルでテストし、より速く反復できるようになります。

4. アメリカのAIプロバイダーの価格設定への圧力

比較が近い水準を示し続ける場合、サブスクリプションベースのAPIは支持を失う可能性があります。

市場見通し|今後6〜12ヶ月の具体的シナリオ

エコシステムの急速な成長 – 量子化ビルドや展開用ツールキットがさらに登場し、M2をプロダクション環境で使いやすくなることが予想されます。ベンダーページやクラウドリスティングは、すでにこの勢いを示唆しています。

ポリシーと規制への注目 – オープンモデルは、出所と安全性に関してより多くの注目を集めるでしょう。検証のためのコミュニティ基準がより厳格化されることが予想されます。

競合他社の対応 – クローズドベンダーは、より深いツール(より優れたアシスタントAPI、低レイテンシーエンドポイント)や、より柔軟な価格設定またはライセンスを推進して顧客を維持しようとするでしょう。

ハイブリッド化 – より多くのチームが混合スタックを採用するでしょう。コスト重視の内部利用にはオープンモデル、ミッションクリティカルな外部機能にはクローズドモデル。

MiniMax-M2のエコシステムが急速に成熟すれば、業界全体でローカルおよびハイブリッド展開の採用が加速するでしょう。

結論|誰がMiniMax-M2を試すべきか、そしてどのように?

MiniMax-M2を試すべき人

✅ エンジニアリング主導のスタートアップで、内部開発者ワークフローの推論コストを削減したい方

✅ ツール開発企業で、複数ファイル推論を必要とするコードアシスタントやCI自動化を構築している方

✅ 研究チームで、ローカルで再現可能な推論が必要で、安全レイヤーを自分で管理する意思がある方

延期するか慎重に進むべき人

⚠️ 厳格なモデレーションやコンプライアンスのニーズがある公開会話型製品を構築している場合(安全工学に投資しない限り)

⚠️ すぐに使える完全マネージドのエンタープライズSLAを探している場合

実践的な次のステップ

単一の測定可能なワークフロー(例:PRトリアージ)から始めましょう。マネージドM2イメージを使用するか、ローカルの量子化ビルドを実行します。客観的な指標(PRあたりの時間短縮、誤検知率、人間による再作業)と安全インシデントを測定します。それらの指標を使用して、採用を拡大するかどうかを決定してください。

よくある質問

Q: MiniMax-M2をコンシューマー向けハードウェアでローカル実行できますか?

A: 量子化版を使えば、ハイエンドコンシューマーGPU(RTX 4090等)でも限定的に動作可能です。ただし、公式推奨構成は4x 96GB GPUs(A100/H100クラス)以上です。実用的な性能を得るには、複数枚構成のデータセンターグレードGPUが現実的で、Mac向けにはMLX版があり、M3 Ultra以上(256GB RAM)で動作します。

Q: MiniMax-M2は外部ユーザー向けチャットボットに安全ですか?

A: すぐには使えません。外部ユーザーに公開する前に、追加のガードレール、モニタリング、安全性のファインチューニングが必要です。

Q: すべてのワークロードをクローズドプロバイダーから移行すべきですか?

A: すぐには移行しないでください。まずは内部ワークフローとコスト重視の自動化から始め、観察可能性と安全性の態勢を同等にできるまで、重要な顧客対応機能にはクローズドプロバイダーを維持しましょう。

Q: APIの料金体系はどうなっていますか?

A: 通常は入力$0.30/百万トークン、出力$1.20/百万トークンの従量課金です。期間限定で無料提供されている場合があります。モデルウェイトをダウンロードして自前でホスティングすれば、API料金は不要です。

この記事の著者

Runbo Li

Magic Hour共同創業者兼CEO。Y Combinator採択歴を持つ起業家。

AI動画生成プラットフォーム「Magic Hour」の共同創業者兼CEO。Y CombinatorのWinter 2024バッチに採択された実績を持つ起業家である。Meta(旧Facebook)ではデータサイエンティストとして、新規プロダクト開発部門「New Product Experimentation(NPE)」にて0→1のコンシューマー向けソーシャルプロダクトの開発に従事した経験を有する。

この記事は著者の許可を得て公開しています。

元記事:MiniMax-M2 Just Dropped – And It Might Be the Most Important Open-Source AI Release of 2025

この記事の監修・コメント

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&著書『ChatGPT最強の仕事術』は4万部突破。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。