Sarashina2.2-Vision-3Bで社内資料を完全ローカル分析!日本語特化VLMの実力と導入方法を徹底解説

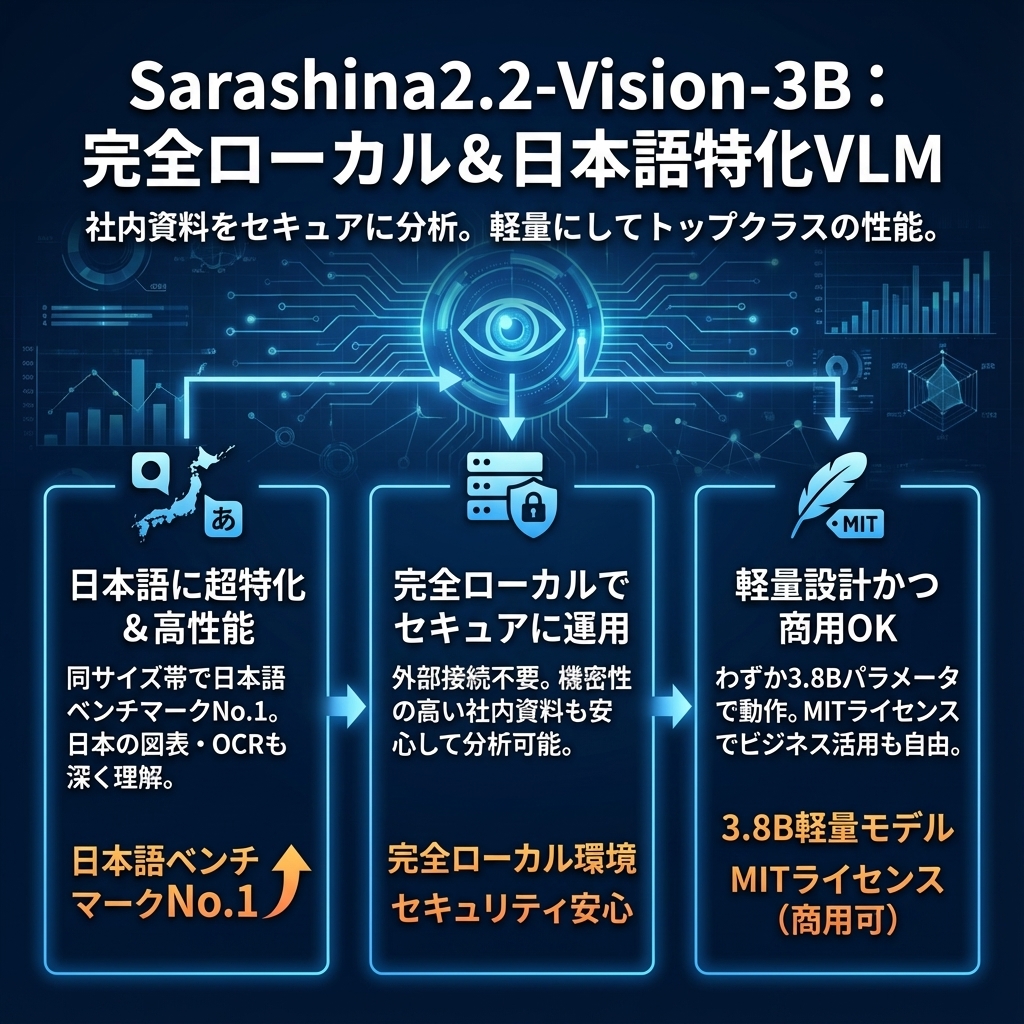

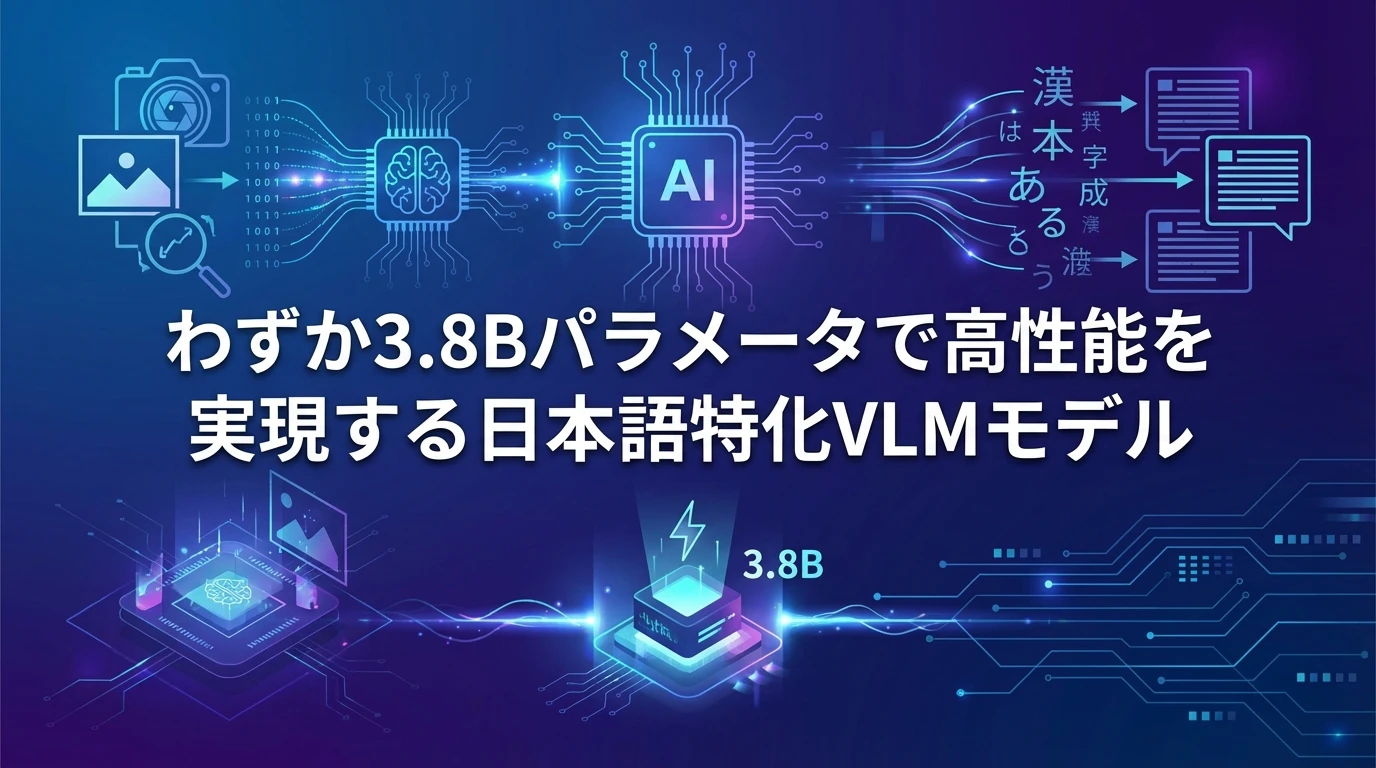

ソフトバンクの子会社であるSB Intuitionsが開発した「Sarashina2.2-Vision-3B」は、日本語に特化した画像理解AIモデルとして大きな注目を集めています。わずか3Bパラメータという軽量設計でありながら、同サイズ帯では日本語ベンチマークでトップクラスの性能を実現し、完全にローカル環境で動作させることができます。

この記事では、Sarashina2.2-Vision-3Bの技術的特徴から実際の導入方法、他モデルとの性能比較まで、企業での活用を検討している方が知っておくべき情報を解説します。特に、社内資料の画像分析や文書処理を効率化したい方にとって、このモデルがどのような価値を提供できるかを具体的にお伝えします。

目次

Sarashina2.2-Vision-3Bとは?日本語特化VLMの革新性

Sarashina2.2-Vision-3Bは、画像とテキストを同時に理解・処理できるVision-Language Model(VLM)です。従来の大規模VLMが数十億から数百億パラメータを必要とする中、わずか3.8Bパラメータで高い性能を実現している点が最大の特徴です。

このモデルの革新性は、日本語処理に特化した設計にあります。開発元のSB Intuitionsは、日本特有の画像や文字を深く理解できるよう、日本語を含む図表データやOCRデータを豊富に学習データに取り入れました。

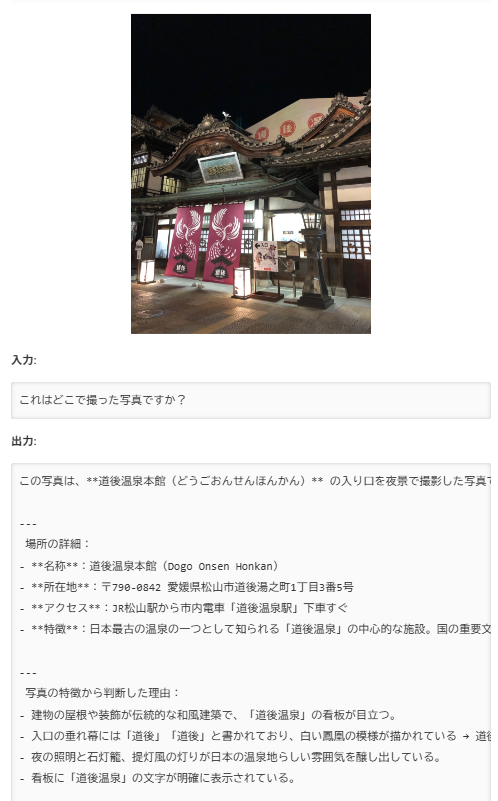

その結果、道後温泉本館の写真を見せて「これはどこで撮った写真ですか?」と質問すると、単に場所を答えるだけでなく、歴史的背景や文化的意義まで含めた詳細な解説を日本語で提供できます。

| 項目 | 詳細 |

|---|---|

| 開発元 | SB Intuitions(ソフトバンク子会社) |

| パラメータ数 | 約3.8B(軽量モデル) |

| ライセンス | MITライセンス(商用利用可能) |

| 基盤モデル | Sarashina2.2-3B-Instruct + SigLIP画像エンコーダ |

| 特徴 | 日本語特化・ローカル実行可能・軽量設計 |

技術アーキテクチャ:軽量でも高性能を実現する仕組み

Sarashina2.2-Vision-3Bの高い性能は、緻密に設計された5段階の学習プロセスによって実現されています。この学習手法は、単純にデータを大量投入するのではなく、各段階で異なる目的を持った戦略的なアプローチを採用しています。

事前学習段階での工夫

Stage 1: Projector Warmupでは、画像エンコーダが処理する視覚情報と、言語モデルが扱うテキスト情報の間にある「埋め込み空間のギャップ」を埋める作業を行います。これは、異なるモダリティのデータを統合するために不可欠なステップです。

Stage 2: Vision Encoder Pretrainingでは、特に日本特有の画像や文字の理解能力向上に焦点を当てます。ここで日本語を含む図表データやOCRデータを大量に学習させることで、日本の文化的コンテキストを深く理解できるようになります。

Stage 3: Full Model Pretrainingでは、画像とテキストが混在するinterleavedデータを活用し、文脈に応じた画像理解能力を獲得します。これにより、単独の画像だけでなく、文書内の図表なども適切に解釈できるようになります。

事後学習での精度向上

Stage 4: Instruction Tuningでは、ユーザーの指示に対して適切に応答する能力を向上させます。画像キャプション生成、OCR、VQA(Visual Question Answering)など、多様なタスクに対応できるよう調整されます。

Stage 5: Mixed Preference Optimizationでは、DPO損失、BCO損失、SFT損失を組み合わせた独自の手法により、ユーザーの嗜好に合致した高品質な応答を生成できるよう最適化されます。

例えるなら、この5段階学習は「留学生シェフが日本料理店で一人前になるまでの研修コース」みたいなものです。

Stage 1では、まず「材料の名前と言語」を揃えるフェーズで、見たことのない食材と日本語の名前を結びつけます(画像エンコーダ=食材、言語モデル=レシピ本)。

Stage 2では、日本特有の食材や調味料(和食の出汁・味噌・海苔など)を重点的に仕込まれ、日本ならではの味や見た目の感覚を身につけます。

Stage 3で、レシピと盛り付けの写真をセットで見ながら「文章と見た目の関係」を覚え、メニュー全体を理解できるようになります。

その後、Stage 4で「お客さんからの注文の出し方」に慣れる接客トレーニング(指示チューニング)が入り、最後のStage 5で「この店らしい味付け・盛り付け」に微調整して、常連さんの好みにピタッと合う料理を出せるようになるイメージです。

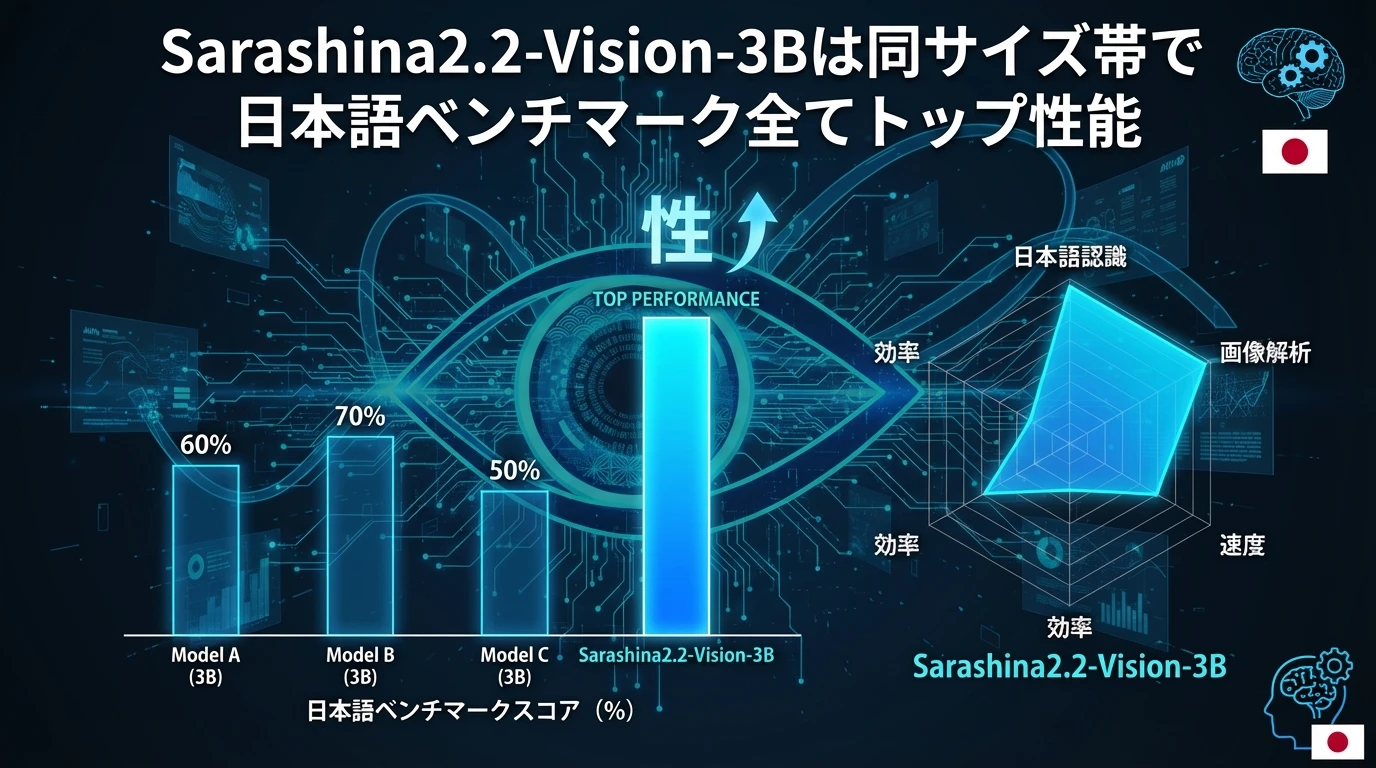

性能比較:同サイズ帯でトップクラスの実力

Sarashina2.2-Vision-3Bの真価は、他の主要VLMとの性能比較で明確に現れます。特に日本語ベンチマークにおいて、同サイズ帯のモデルを大きく上回る性能を示しています。

日本語ベンチマークでの優位性

| モデル | パラメータ数(B) | BusinessSlide VQA | Heron-Bench | JDocQA | JMMMU |

|---|---|---|---|---|---|

| Sarashina2.2-Vision-3B | 3.8 | 3.932 | 3.214 | 3.327 | 0.486 |

| Qwen2.5-VL-3B-Instruct | 3.8 | 3.516 | 2.000 | 3.019 | 0.450 |

| Qwen3-VL-4B-Instruct | 4.4 | 4.105 | 2.330 | 3.596 | 0.493 |

| InternVL3_5-4B | 4.7 | 3.311 | 1.893 | 2.626 | 0.437 |

この結果から、Sarashina2.2-Vision-3Bは同じ3.8BパラメータのQwen2.5-VL-3B-Instructを全ての日本語ベンチマークで上回っていることがわかります。特にHeron-Benchでは3.214対2.000と大幅な差をつけており、日本語コンテキストでの理解力の高さが際立っています。

注目すべきは、より大きなパラメータ数を持つQwen3-VL-4B-Instruct(4.4B)やInternVL3_5-4B(4.7B)と比較しても、多くのベンチマークで競合する性能を示していることです。これは、パラメータ効率の観点で非常に優秀な結果と言えます。

実際の導入方法:ローカル環境での構築手順

Sarashina2.2-Vision-3Bの大きな魅力の一つは、一般的なGPU環境でローカル実行できることです。クラウドAPIに依存せず、社内データを外部に送信することなく画像分析が可能になります。

必要な環境とセットアップ

モデルの実行には、CUDA対応のGPUが必要です。推奨環境としては、VRAM 8GB以上のGPUが望ましいとされています。実際の検証では、RTX 3090(24GB VRAM)やRTX A6000(48GB VRAM)での動作が確認されています。

セットアップは比較的簡単で、以下の依存関係をインストールするだけで開始できます:

- transformers==4.57.1

- torch

- torchvision

- pillow

- protobuf

- sentencepiece

- accelerate

基本的な使用方法

モデルの読み込みと推論は、Hugging Face Transformersライブラリを使用して行います。画像とテキストを同時に入力し、日本語での詳細な分析結果を得ることができます。

実際の推論では、画像の解像度やファイルサイズが処理時間に大きく影響します。検証では、5760×3840ピクセルの高解像度画像で処理が重くなる事例が報告されており、実用的なサイズに調整することが推奨されます。

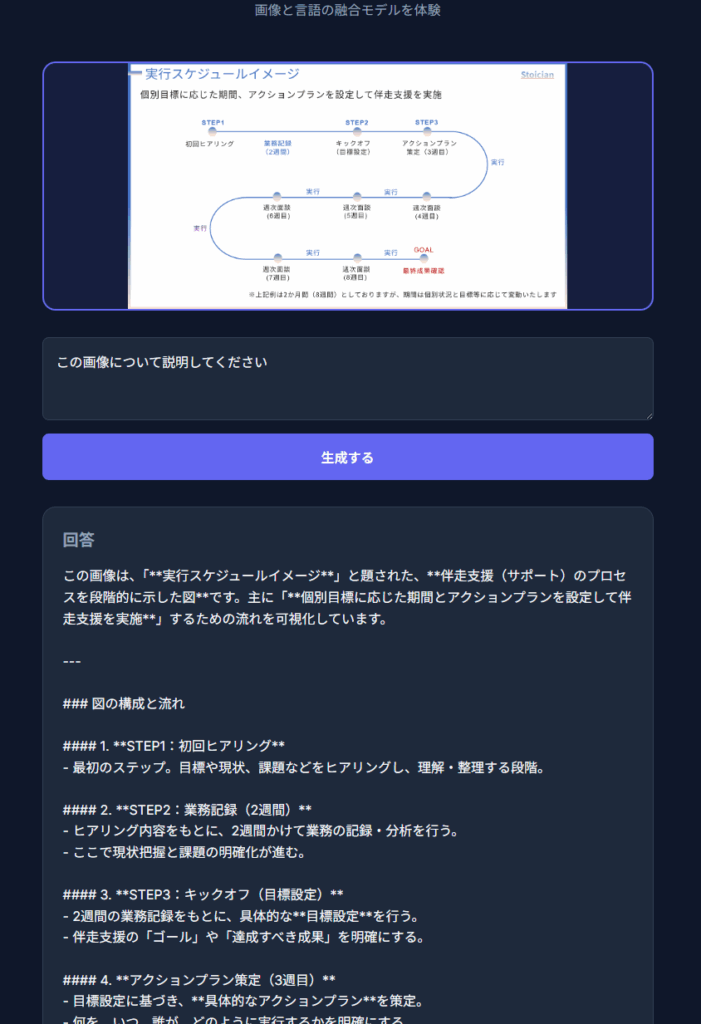

実際にローカル環境で動かした結果

私のPCはNVIDIAのGeForce RX 5080なのですが、実際にローカル環境で動かしてみました。以下の資料の画像を投入し、説明を求めたところ、5分くらいかかり、画像のような分析を出してくれました。ちょっと時間はかかりましたが、このクオリティを完全ローカルで実現できるのは驚異といえます。

企業での活用シーン:社内資料分析の革新

Sarashina2.2-Vision-3Bは、企業の様々な業務シーンで威力を発揮します。特に、これまで人手に頼っていた画像・文書分析業務の自動化において、大きな価値を提供できます。

社内資料の自動分析

会議資料、プレゼンテーション、技術文書に含まれる図表やグラフを自動で読み取り、内容を日本語で要約できます。例えば、売上推移のグラフを見せると、数値の変化だけでなく、トレンドの分析や注目すべきポイントまで指摘してくれます。

また、手書きメモやホワイトボードの内容も高精度で認識し、デジタル化できます。これにより、会議後の議事録作成や、アイデアの整理作業を大幅に効率化できます。

品質管理・検査業務での応用

製造業では、製品の外観検査や品質チェックにおいて、画像から異常を検出し、日本語で詳細なレポートを生成できます。従来のルールベースの検査システムでは対応困難だった、複雑な判断を要するケースでも、人間に近い柔軟な判断が可能になります。

文書処理の自動化

契約書、申請書、報告書などの文書画像から、重要な情報を抽出し、構造化されたデータとして出力できます。OCR機能だけでなく、文脈を理解した上での情報整理が可能なため、単純な文字認識を超えた高度な文書処理が実現できます

今後の展望と発展可能性

Sarashina2.2-Vision-3Bの登場は、日本語VLM分野における重要なマイルストーンです。MITライセンスでの公開により、研究機関や企業での活用が促進され、さらなる改良や応用開発が期待されます。

特に注目すべきは、このモデルが示したパラメータ効率の高さです。大規模モデルに頼らずとも、適切な学習戦略により高い性能を実現できることが証明されました。これは、計算資源に制約のある環境でのAI活用において、新たな可能性を示しています。

また、日本特有の文化的コンテキストを深く理解できる能力は、グローバルモデルでは実現困難な価値を提供します。今後、より多くの日本企業がこのような特化型モデルを活用することで、業務効率化と競争力向上を実現できると考えられます。

まとめ

Sarashina2.2-Vision-3Bは、日本語に特化した軽量VLMとして、企業での実用的な画像分析ソリューションを提供します。主要なポイントを以下にまとめます:

- 軽量設計:3.8Bパラメータで一般的なGPU環境でも実行可能

- 日本語特化:同サイズ帯では日本語ベンチマークでトップクラスの性能

- ローカル実行:社内データを外部に送信せずに分析可能

- 商用利用可能:MITライセンスで企業での活用に制限なし

- 多様な応用:文書分析、品質管理、資料作成支援など幅広い用途

- 開発効率:既存の開発ツールとの連携により迅速なアプリケーション構築が可能

企業でのAI活用を検討している方にとって、Sarashina2.2-Vision-3Bは日本語環境での画像・文書分析において、実用的で信頼性の高い選択肢となるでしょう。ただし、導入前には処理速度や安全性の要件を十分に検討し、適切な運用体制を整備することが重要です。

参考リンク

本記事の作成にあたり、以下の情報源を参考にしています:

- Sarashina2.2-Vision-3B – Hugging Face

- Sarashina2.2-Vision-3B: コンパクトかつ性能が高いVLMの公開 – SB Intuitions

- 日本語AIの新星がすごすぎる…!Sarashina2.2-Vision-3Bの特徴・仕組み・活用例を解説

- 「Sarashina2.2-Vision-3B」を試す – Zenn

- ITmedia AI+ 関連記事

よくある質問(FAQ)

Q1

Sarashina2.2-Vision-3BはどのようなAIモデルですか?

Sarashina2.2-Vision-3Bは、ソフトバンクの子会社SB Intuitionsが開発した日本語に特化した画像理解AIモデル(VLM)です。画像とテキストを同時に理解・処理でき、3.8Bパラメータという軽量設計ながら、日本語ベンチマークで高い性能を発揮します。ローカル環境で動作するため、社内データを外部に送信せずに利用できます。

Q2

Sarashina2.2-Vision-3Bの導入に必要な環境は何ですか?

Sarashina2.2-Vision-3Bの実行には、CUDA対応のGPUが必要です。VRAM 8GB以上のGPUが推奨されており、RTX 3090(24GB VRAM)やRTX A6000(48GB VRAM)での動作が確認されています。また、transformers、torch、torchvisionなどのPythonライブラリのインストールも必要です。

Q3

Sarashina2.2-Vision-3Bは商用利用できますか?

はい、Sarashina2.2-Vision-3BはMITライセンスで公開されており、商用利用が可能です。企業での画像分析や文書処理など、幅広い用途で活用できます。

Q4

Sarashina2.2-Vision-3Bで社内資料を分析する場合、どのような活用ができますか?

Sarashina2.2-Vision-3Bは、会議資料やプレゼンテーションに含まれる図表やグラフを自動で読み取り、内容を日本語で要約できます。手書きメモやホワイトボードの内容もデジタル化できるため、議事録作成やアイデア整理を効率化できます。

Q5

Sarashina2.2-Vision-3Bの導入にあたって注意すべき点はありますか?

Sarashina2.2-Vision-3Bは軽量モデルですが、複雑な画像分析には相応の処理時間が必要です。また、安全性訓練が限定的なため、不適切な出力や偏見を含む可能性のある結果を生成する場合があります。企業での本格運用前には、十分な検証と安全性対策が重要です。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、

AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、

チャンネル登録数は18万人超(2025年7月時点)。