2025年12月、中国のAI企業DeepSeekが発表したDeepSeek-V3.2が、AI業界に大きな衝撃を与えています。

このモデルは、GPT-5やGemini 3.0 Proといった最先端のクローズドソースモデルと同等の性能を持ちながら、完全にオープンソースで提供されているのです。

目次

DeepSeek-V3.2の驚異的な性能は、3つの革新的な技術によって実現されています。

従来のアテンション機構の最大の課題は、計算複雑性がシーケンス長の二乗に比例して増加することでした。これにより、長いコンテキストを扱う際の計算コストが膨大になり、実用的な展開が困難になっていました。

DeepSeek-V3.2では、DeepSeek Sparse Attention(DSA)という新しいアテンション機構を導入しました。DSAは以下の2つの主要コンポーネントで構成されています:

Lightning Indexerは、クエリトークンと候補トークン間のインデックススコアを高速計算し、最も関連性の高いトップKトークンのみを選択します。これにより、計算複雑性をO(L²)からO(L)に大幅に削減しながら、モデルの性能を維持することに成功しています。

例えると、従来の仕組みは「図書館で調べ物をするときに、棚の本を端から端まで全部ペラペラめくっていく」ようなやり方でした。DSA では、Lightning Indexer が超高速検索機のように「今の疑問に関係が深い本トップK」を瞬時に選び出し、その本の中だけを Fine-grained Token Selection がページ単位で丁寧に読むイメージです。結果として、膨大な蔵書を持つ大図書館でも、短時間で必要な情報にたどり着けます。

実際の効果として、DeepSeek-V3.2は128,000トークンという長いコンテキストを効率的に処理できるようになり、大規模な文書分析やエージェント的タスクでの活用が可能になりました。

オープンソースモデルの大きな課題の一つは、ポストトレーニング段階での計算リソース不足でした。DeepSeek-V3.2では、この問題を解決するため、事前学習コストの10%を超える計算予算をポストトレーニングに投入するという大胆なアプローチを採用しました。

例えるなら、これまでのオープンソースモデル開発は「試合前の練習には時間をかけるのに、試合後の反省会や改善トレーニングはほとんどできない」ような状態でした。DeepSeek-V3.2は、あえて「試合後の改善トレーニングにも十分なコーチと練習時間を確保する」方針に切り替えたことで、選手(モデル)が実践的に強くなる余力を得たイメージです。

この大規模な投資により、DeepSeek-V3.2はGPT-5と同等の性能を実現し、特別バリアントのDeepSeek-V3.2-SpecialeはGPT-5を上回る性能を達成しています。強化学習プロトコルには、以下の技術が組み込まれています:

AIエージェントの能力向上には、推論とツール使用を統合した高品質な学習データが不可欠です。DeepSeek-V3.2では、1,800以上の異なる環境と85,000の複雑なプロンプトを自動生成する革新的なパイプラインを開発しました。

このパイプラインの特徴は以下の通りです:

| タスクタイプ | データ数 | 特徴 |

| 検索エージェント | 50,275件 | 多様なドメインでの情報検索タスク |

| 一般エージェント | 4,417件 | 複雑な環境での問題解決 |

| コードインタープリター | 5,908件 | プログラミングと実行能力 |

特に注目すべきは「Thinking with Tools」機能で、モデルが実際にツールを呼び出す前に、<think>タグ内で推論プロセスを明示的に表示します。これにより、エージェントの思考過程が透明化され、より信頼性の高い意思決定が可能になります。

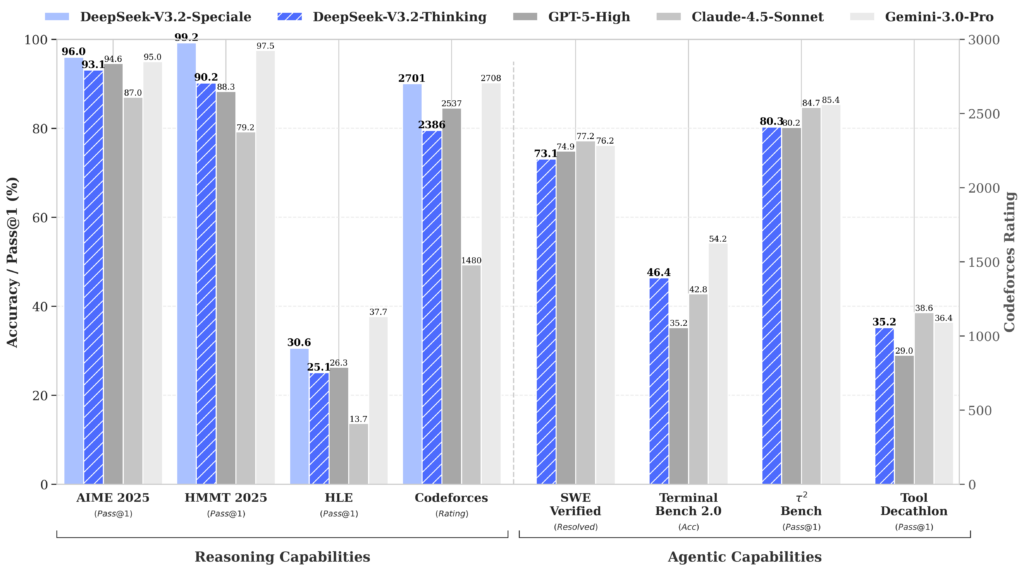

DeepSeek-V3.2の性能は、複数の権威あるベンチマークで実証されています。特に数学系のタスクでは圧倒的な成果を示しており、以下のような結果を記録しています:

特にDeepSeek-V3.2-Specialeは、推論タスクに特化した設計により、Gemini-3.0-Proと同等の推論能力を発揮し、2025年の国際数学オリンピック(IMO)と国際情報オリンピック(IOI)で金メダル級の性能を達成しました。

コーディング能力においても、HumanEvalで89%のスコアを記録し、GPT-4o miniやChatGPT-4を上回る性能を示しています。また、中国語コンテンツ生成では、これらのモデルを明確に上回る結果を出しています。

DeepSeek-V3.2の成功は、中国のオープンソースLLM生態系の急速な発展を象徴しています。現在、中国は世界のオープンソースLLMの約40%(約1,509モデル)を占めており、この分野でのリーダーシップを確立しています。

| 企業・組織 | 主要モデル | 特徴 |

| Alibaba | Qwen 3シリーズ | 0.5B〜235Bパラメータ、Apache 2.0ライセンス |

| Moonshot AI(ByteDance系) | Kimi K2 | 1兆パラメータ、128Kコンテキスト |

| Zhipu AI | GLM-4.5 | 355Bパラメータ、MoEアーキテクチャ |

| DeepSeek | DeepSeek-V3.2 | 685Bパラメータ、MITライセンス |

| Baidu | Ernie | 多言語対応、2025年4月から無料提供 |

これらのモデルは、いずれも商用利用可能なライセンスで提供されており、企業や研究機関が自由に活用できる環境が整っています。特に注目すべきは、これらのモデルが単なる「追随者」ではなく、独自の技術革新を通じて西欧のクローズドソースモデルと対等、あるいはそれを上回る性能を実現していることです。

DeepSeek-V3.2の登場は、AI業界における重要な転換点を示しています。主要なポイントを以下にまとめます:

DeepSeek-V3.2は、「世界クラスの検証可能な知能が、独占的な壁の向こうに閉じ込められている必要はない」ことを実証しました。これは単なる技術的成果を超えて、AI技術の民主化と、より公平で開かれたAI生態系の構築に向けた重要な一歩と言えるでしょう。

企業や研究機関にとって、DeepSeek-V3.2は最先端のAI技術を自社の戦略的資産として活用する新たな機会を提供しています。適切な実装戦略と技術的準備により、この革新的なモデルの恩恵を最大限に活用することが可能になるでしょう。

DeepSeek-V3.2は、中国のAI企業DeepSeekが開発した大規模言語モデルです。GPT-5やGemini 3.0 Proと同等の性能を持ちながら、完全にオープンソースで提供されている点が特徴です。特に、数学系のベンチマークで高いスコアを記録し、国際数学オリンピック(IMO)と国際情報オリンピック(IOI)で金メダル級の性能を達成しています。

DeepSeek-V3.2は、DeepSeek Sparse Attention(DSA)による効率化、スケーラブル強化学習フレームワーク、大規模エージェント的タスク合成パイプラインという3つの革新的な技術によって、高い性能を実現しています。DSAは計算複雑性をO(L²)からO(L)に削減し、128,000トークンという長いコンテキストを効率的に処理できます。

はい、DeepSeek-V3.2はMITライセンスの下で提供されているため、商用利用に制限はありません。ライセンス費用が不要で、自社環境での完全な制御、特定用途へのカスタマイズ、ベンダーロックインの回避といったメリットがあります。

DeepSeek-V3.2は685Bパラメータという大規模なモデルサイズのため、ローカル実行には高性能なGPUクラスターが必要です。推奨設定はtemperature = 1.0, top_p = 0.95です。

DeepSeek-V3.2-Specialeは、DeepSeek-V3.2の高性能バリアントであり、特に深い推論タスクに特化した設計となっています。数学系のベンチマークで100%のスコアを記録し、国際数学オリンピック(IMO)と国際情報オリンピック(IOI)で金メダル級の性能を達成しています。ただし、ツール呼び出し機能はサポートしていません。

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。