GPT-OSS 20Bローカル実証レビュー:文字起こし要約精度がGPT-4oクラスに到達

OpenAIが2025年、ついにGPT-OSS(GPT Open Source Style)として、オープンウェイトモデルを公開しました。これは従来のクローズドなAPIサービスとは大きく異なり、ローカル環境で動作する本格的なAIモデルです。

GPT-OSSには2つのバリエーションがあります:

- GPT-OSS 120B:117Bパラメータの大規模モデル(単一80GB GPUで効率動作)

- GPT-OSS 20B:21Bパラメータの中規模モデル(一般的なPCでも動作可能)

特に注目すべきは、これらのモデルがMixture of Experts(MoE)アーキテクチャを採用している点です。120Bモデルは実際の推論時には5.1Bパラメータ、20Bモデルは3.6Bパラメータのみを活性化するため、見た目のパラメータ数よりもはるかに軽量に動作します。

実際に「GPT-OSS 20B」は自分のPCで試してみたので、その結果なども詳しく共有します。

目次

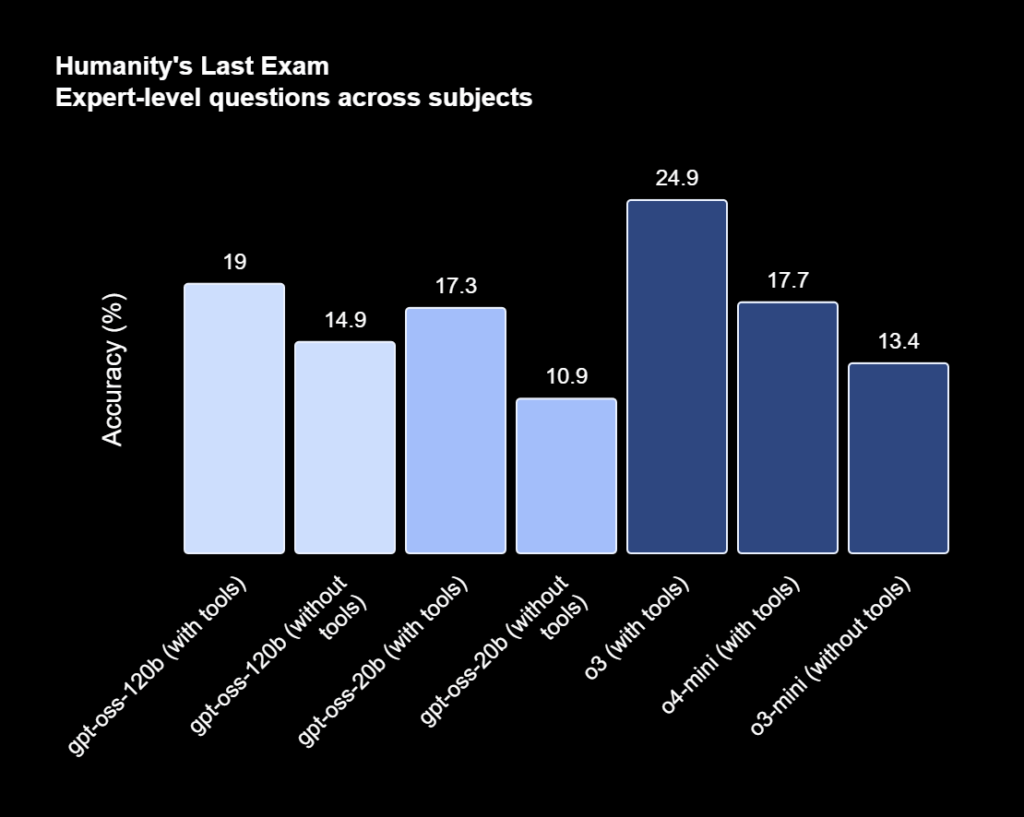

ベンチマーク性能:GPT-4o miniと同等レベルを実現

公開されたベンチマーク結果によると、GPT-OSS 120BはGPT-4o miniと同等の性能を示しています。特に以下の分野で優秀な結果を記録しました:

| 評価項目 | GPT-OSS 120B | GPT-OSS 20B | 特徴 |

| Human’s Last Exam | 高スコア | 高スコア | 非常に難しい問題への対応力 |

| Mizツール(ヘルスベンチ) | 非常に高い | 良好 | 専門的な医療・健康分野の知識 |

| GPQA | 良好 | まあまあ | 科学的推論能力 |

これらの結果は、特に20Bモデルでも実用的なレベルの性能を持っていることを示しています。私自身、実際に試してみましたが、多くのビジネスユースケースで十分活用できる水準と認識しました。

実際の検証:文字起こしデータの要約・抽出精度

最も重要なのは、実際のビジネスシーンでどの程度使えるかという点です。ビジネスシーンにおいて最もLLMのニーズがあると私が考えているのが「非構造化テキストデータの構造化」です。今回は、「1時間程度の会議文字起こしデータから、情報抽出・要約」というタスクで、GPT-OSS 20Bの性能を検証してみました。

検証環境と条件

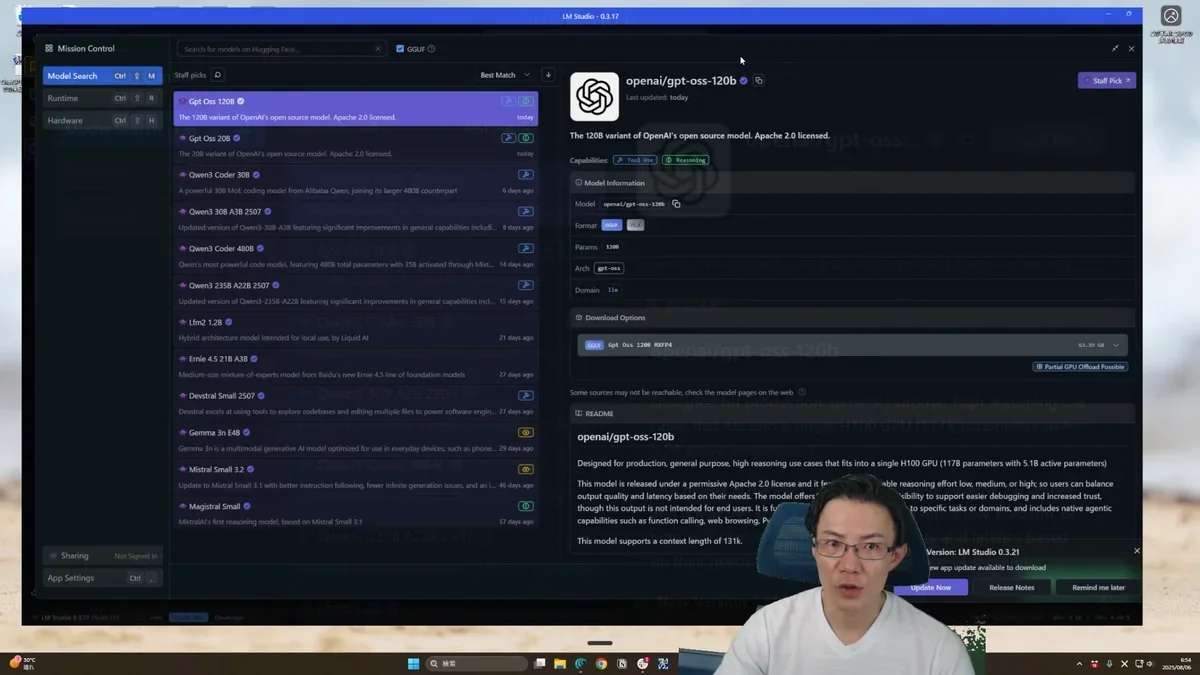

検証にはLM Studioを使用し、以下の条件で実施しました:

- 使用モデル:GPT-OSS 20B

- コンテキスト長:20,000トークン(長文処理のため拡張)

- 比較対象:GPT-4、Gemma 3(6.9Bパラメータ)

- テストデータ:実際のプロジェクト会議の文字起こし

- 主なPCスペック:Intel Core Ultra9、Nvidia GeForce RTX5080

Q&Aの抽出:GPT-4oと同水準

結果は期待を大きく上回るものでした。GPT-4で処理した「正解データ」と比較して、GPT-OSS 20Bの出力はほぼ同等の品質を実現していました。スピード感も数十秒で、非常に早い処理速度でした。

議事録の作成:GPT-4oと同水準

こちらも同様に、GPT-4で処理した「正解データ」と比較して、GPT-OSS 20Bの出力はほぼ同等の品質を実現していました。プロンプト内で出力フォーマットをかなり強く指定しましたが、しっかりと遵守していました。

これまでこの精度の処理を行うには、クラウドAPIを使用する必要がありましたが、完全にローカル環境で遜色ないクオリティを実現できるようになりました。

この精度は、従来Gemma 3でも「使い物になるレベル」でしたが、GPT-OSS 20Bでは内容の明確さと密度が一段階向上していました。まさに「GPT-4クラスの回答」と言える品質です。

Windowsへの本格導入:Microsoftとの連携

特に注目すべきは、MicrosoftがGPT-OSS 20BのGPU最適化バージョンをWindowsデバイスに導入すると発表している点です。これにより、一般的なWindowsユーザーでも、高品質なローカルAIを標準的に利用できる時代が到来します。

ローカルAI活用の本格化が始まるか

今回の検証を通じて、私はローカルAI活用の時代が本格的に到来したと確信しています。特に以下の点で大きな変化を感じています:

非構造化データ処理の革命

これまで高精度な非構造化データ処理(文字起こし、議事録、レポート分析など)には、クラウドAPIが必須でした。しかし、GPT-OSS 20Bレベルの性能があれば、社内の大量の非構造データを完全にローカル環境で処理できます。

これは特に以下のような企業にとって革命的です:

- 機密性の高いデータを扱う企業:外部APIにデータを送信する必要がない

- 大量のデータ処理が必要な企業:API利用料を気にせず処理できる

- リアルタイム処理が必要な業務:ネットワーク遅延なしで即座に処理

コスト構造の根本的変化

60万円程度のPCで、従来数十万円の月額API利用料が必要だった処理を無制限に実行できるようになります。初期投資は必要ですが、長期的なコスト削減効果は計り知れません。

他のオープンウェイトモデルとの比較

現在、Gemma 3、Qwen 3、DeepSeek 14Bなど、様々なオープンウェイトモデルが利用可能です。私の検証では、これらのモデルも十分実用的でしたが、GPT-OSS 20Bは以下の点で優位性があると考えます。

- OpenAIブランドの信頼性:企業導入時の安心感

- API互換性:既存のOpenAI APIとの互換性により移行が容易

- ツール使用能力:ウェブ検索やPython実行などの高度な機能

- 推論機能:自律的なワークフロー内での使用が可能

まとめ

GPT-OSS 20Bの実証検証を通じて、以下の重要なポイントが明らかになりました:

- ローカルでも処理精度がGPT-4oクラスに到達:ビジネス実用レベルの高精度を実現

- 60万円程度のPCで動作可能:中級PCユーザーでも導入可能な現実的な要件

- 完全ローカル処理による機密性確保:外部APIへのデータ送信が不要

- Windowsへの標準搭載予定:一般ユーザーへの普及が加速

これらの要素が組み合わさることで、ローカルAI活用の本格化が現実のものとなりました。特に非構造化データの処理において、クラウドAPIに依存しない新しい選択肢が生まれたことは、多くの企業にとって革命的な変化となるでしょう。

OpenAIがオープンウェイトモデルの提供に本格参入したことで、AI業界全体の競争がさらに激化し、ユーザーにとってより良い選択肢が増えることが期待されます。今後のローカルAIエコシステムの発展に、大いに注目していきたいと思います。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 GPT-OSSとは何ですか?

GPT-OSS(GPT Open Source Style)は、OpenAIが公開したローカル環境で動作するオープンウェイトモデルです。従来のAPIサービスとは異なり、ユーザー自身の環境でAIモデルを動かすことができます。GPT-OSSには、120Bと20Bの2つのバリエーションがあります。

Q2 GPT-OSS 20Bはどのようなタスクに適していますか?

GPT-OSS 20Bは、特に長文の文字起こしデータからの情報抽出や要約といったタスクに適しています。記事内の検証では、会議の文字起こしデータから質問応答や議事録の作成において、GPT-4と同等の品質を実現しています。

Q3 GPT-OSS 20Bをローカルで動かすには、どのようなPCスペックが必要ですか?

GPT-OSS 20Bをローカルで動作させるには、最低でも16GBのRAM、NVIDIA 2000シリーズ以上のGPU、15GB以上のストレージが必要です。推奨環境としては、16GB以上のRAM、NVIDIA RTX 4080以上のGPU、50GB以上のストレージ、Windows 11が推奨されています。

Q4 GPT-OSS 20Bの安全性はどのように確保されていますか?

GPT-OSSは、有害データの除去、プロンプトインジェクション防御、ファインチューニングの悪用防止など、多岐にわたる安全対策が施されています。化学兵器や生物兵器に関連する情報のフィルタリングや、悪意のあるプロンプトの検知・ブロック機能などが実装されています。

Q5 GPT-OSS 20Bを使うことで、どのようなコスト削減効果が期待できますか?

GPT-OSS 20Bをローカル環境で使用することで、クラウドAPIの利用料を大幅に削減できます。これまで月額数十万円のAPI利用料がかかっていた処理を、初期投資(60万円程度のPC)のみで無制限に実行できるようになり、長期的なコスト削減が期待できます。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。