NVIDIA Jet-Nemotron完全ガイド|Transformerの進化形?最大53.6倍高速なハイブリッドLLMの衝撃

大規模言語モデル(LLM)の性能は日々向上していますが、スケーリングの効率性という大きな課題に直面しています。従来のTransformerアーキテクチャは、フルアテンション機構により以下の問題を抱えています!

✅ この記事はこんな方におすすめ

- AI研究者・エンジニアで最新のLLM技術動向を追いたい方

- 企業でAI導入を検討中で、コスト効率の良いソリューションを探している方

- Transformerの限界を感じている開発者の方

現在のTransformerが抱える3つの課題:

- メモリ消費の急激な増加 – 長いシーケンスでの処理が困難

- 処理速度の低下 – コンテキスト長に比例した性能劣化

- 非効率なレイヤー設計 – 全レイヤーが同じ負荷を担う必要性の疑問

そこで登場したのが、NVIDIAが開発した革命的なアーキテクチャ「Jet-Nemotron」です。

Jet-Nemotronは、既存の事前学習済みモデルを活用しながら、コストの高い部分をよりスマートな仕組みに置き換えるという画期的なアプローチを採用しています。

目次

🔍 PostNAS(Post Neural Architecture Search)の革新性

従来のアプローチとは異なり、PostNASは以下の特徴を持ちます。

従来の方法: ゼロからの再学習が必要

PostNASの方法: 既存モデルのMLP重みを固定し、アテンション部分のみを最適化

これにより、従来の一からの再学習と比較して効率的に、効率性と精度を両立したアーキテクチャの探索が可能になります。

PostNASって聞き慣れない言葉ですが、普通のAIの作り方と何が根本的に違うんですか?

従来は新しいモデルを作るときにゼロから学習させる必要がありましたが、PostNASは既存の優秀なモデルの「知識部分(MLP層)」は固定して、「注意機構(アテンション)」の部分だけを効率的に最適化する手法です。料理で例えると、「レシピ全体を一から作り直す」のではなく、「基本の調理法は活かして、調味料の組み合わせだけを変えて美味しくする」ような感覚ですね。これにより、膨大な計算コストをかけずに効率的なモデルが作れるようになりました。

PostNASの4ステップ実行プロセス

PostNASは以下の4つの段階で動作します。

ステップ1:レイヤープルーニング(重要度の特定)

どのフルアテンション層が実際に重要かを判定します。推論や検索に不可欠な層もあれば、ほとんど影響のない層も存在することが判明しました。

ステップ2:ブロック選択(最適設計の決定)

様々な線形アテンション設計をテストし、最高の性能を発揮するドロップイン代替案を選択します。

ステップ3:JetBlock設計(新ブロックの構築)

候補をテストした後、新しいブロック(JetBlock)を詳細設計・構築します。

ステップ4:ハードウェア対応最適化(実用性の確保)

理論値ではなく、GPU上での実際のスループットを基準にハイパーパラメータを調整します。

💡 重要ポイント

パラメータ数よりもKVキャッシュサイズが真のボトルネックであることに着目し、長コンテキスト推論の実用性を重視した設計となっています。

JetBlockの革新的な仕組み|なぜ他の線形アテンションより優秀なのか

従来の線形アテンション手法の課題

Mamba2、GLA、Gated DeltaNetなどの従来手法は、フルアテンションの二次コストを近似しようと試みましたが、精度の大幅な低下という代償を払っていました。

JetBlockの2つの革新技術

1. V(値)トークンへの動的畳み込みカーネル

固定変換の代わりに、各ステップで値の集約方法を適応的に調整。これにより、メモリ爆発を避けながら柔軟性を確保しています。

2. Q(クエリ)・K(キー)トークンでの静的畳み込み排除

GLAのような従来設計では全箇所で静的畳み込みを使用していましたが、JetBlockはQ・Kでの使用を廃止。冗長性を削減し、効率性を向上させています。

JetBlockっていう技術がすごそうですが、正直かなり複雑で理解が追いつきません…何がそんなに画期的なんでしょうか?

JetBlockの革新性は、従来の線形アテンション(Mamba2、GLAなど)が抱えていた「精度の大幅な低下」という問題を解決したことです。簡単に言うと、従来手法は「処理速度は上がるけど賢さが落ちる」というトレードオフがありました。しかしJetBlockは独自の動的な仕組みにより、「速度向上」と「高精度」を両立することに成功しています。技術的には複雑ですが、結果として「今まで以上に賢く、今まで以上に早い」AIが実現できたということです。

🎯 JetBlockの実力

検索タスクと数学的推論タスクの両方で従来手法を上回る性能を実証:

- Mamba2との比較:精度向上 + 高速化

- GLAとの比較:メモリ効率 + 処理速度向上

- Gated DeltaNetとの比較:総合性能で優位

ハイブリッドアテンション|全てのレイヤーが同じではない

🔬 研究で判明した重要な発見

すべてのアテンション層が等しく重要ではないことが実証されました。

重要な層: 多段階推論や検索に不可欠

一般的な層: パターンマッチング程度の処理で充分

ハイブリッドアテンションの戦略的設計

Jet-Nemotronは完全にフルアテンションを排除するのではなく

✅ 戦略的なポイントにフルアテンション層を配置

✅ その他の層をJetBlockで効率化

この設計により実現できること:

- 本当に重要な部分でのフルアテンション精度

- その他すべての部分でのJetBlock効率性

- KVキャッシュサイズの大幅削減(最大256Kトークンまで対応)

驚異的なベンチマーク結果|数字で見る圧倒的性能

主要な成果

🚀 Jet-Nemotronの実績

- 主要ベンチマークで同等以上の性能を実現

- 最大53.6倍のスループット向上を達成

- 長コンテキスト処理での大幅な効率化

📊 包括的評価結果

以下の幅広いベンチマークで評価を実施:

- 推論系: MMLU、GSM8K、MATH、ARC

- 常識推論: PIQA、TruthfulQA

- 検索・質問応答: SQuAD

- コーディング: EvalPlus、CRUXEval

- 長コンテキスト: LongBench(最大256Kトークン)

結果: ほぼすべてのケースで、桁違いの高速化を実現しながら高精度を維持

学習プロセスの詳細|どのように構築されたのか

第1段階:知識蒸留による基礎構築

- データセット: Nemotron-CC、Redstone-QA(約500億トークン)

- 手法: MLPを固定したフルアテンションモデルからの蒸留

- 目的: 効率的な初期モデルの構築

第2段階:本格的な学習による性能向上

- 追加データ: 追加で約3500億トークン

- 特徴: 数学・コーディングデータを重点的に使用

- 環境: NVIDIA H100 GPU、最大256Kトークン対応

💡 学習のコツ

段階的アプローチにより、計算コストを抑制しながら高性能を実現しています。

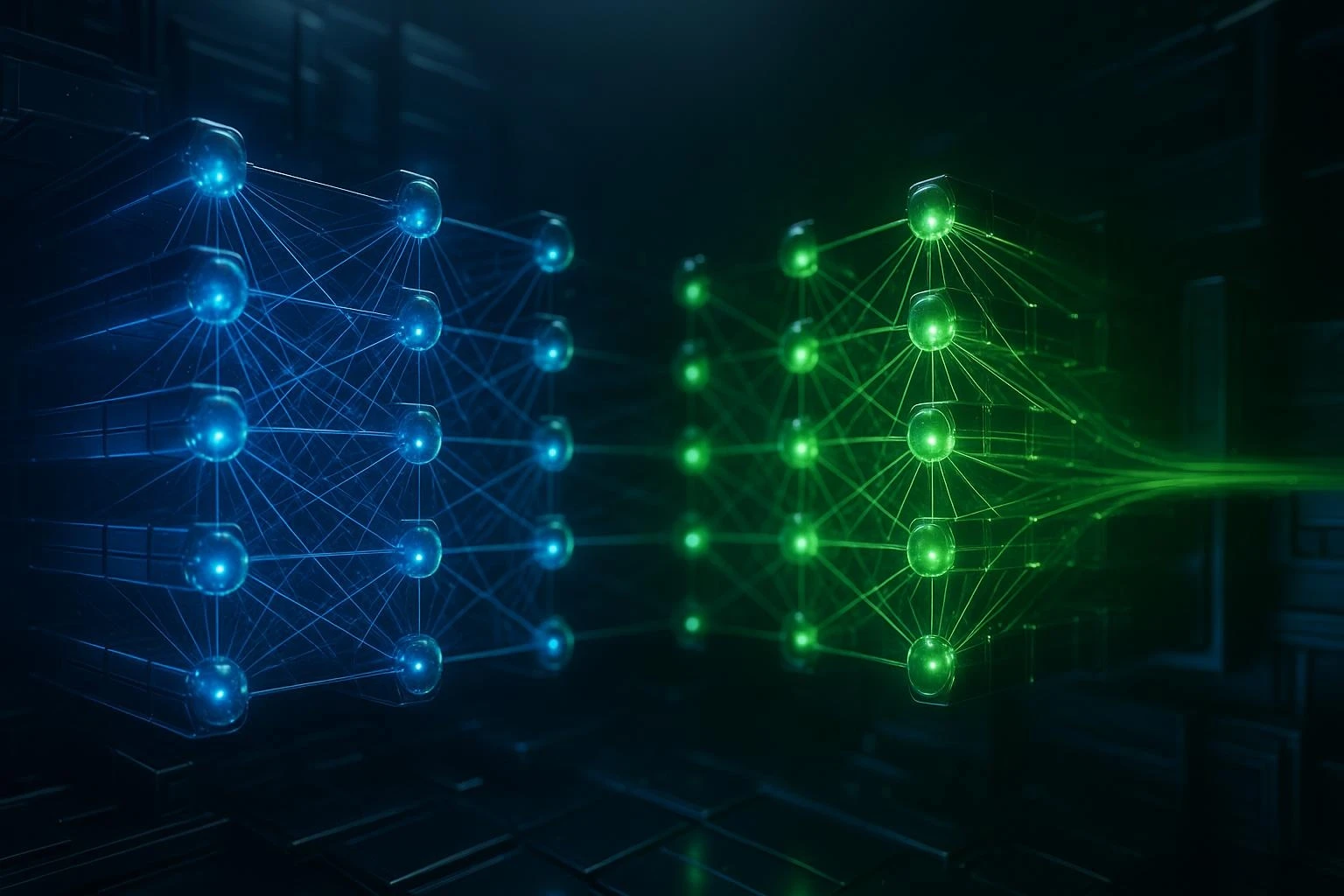

Transformerとの根本的な違い|パラダイムシフトの本質

従来のTransformerの考え方

「すべての層がフルアテンションを受けるべき」

これにより発生する問題:

- コンテキスト長に対する二次スケーリング

- KVキャッシュの大幅な増加

- 長コンテキスト使用の非実用性

Jet-Nemotronの革新的アプローチ

3つの根本的な変更点

- 大部分をJetBlock線形アテンションに置換 → メモリ・計算コストの大幅削減

- 推論・検索に重要な部分のみフルアテンション維持 → 精度の確保

- GPU性能とキャッシュサイズを最適化目標に設定 → 実用性の向上

📈 設計哲学の転換

| 従来のTransformer | Jet-Nemotron |

|---|---|

| 汎用性重視の柔軟な設計 | ハードウェア制約を考慮した実用設計 |

| パラメータ数が性能指標 | キャッシュサイズと推論速度が重要指標 |

| 理論的な最適化 | GPU実装を前提とした最適化 |

具体的な活用シーンとユースケース

🎯 こんな場面で威力を発揮します

53倍も速くなるのはすごそうですが、実際のビジネスではどんな場面で活用できるんでしょうか?

最も分かりやすいのは「長い文書を扱う業務」での劇的な改善です。例えば、法務部門での契約書チェック、研究部門での学術論文の分析、カスタマーサポートでの過去やり取り履歴を踏まえた回答生成などが考えられます。また、従来なら高性能なサーバーが必要だった処理が、RTX 3090のような比較的身近なGPUでも実行できるようになるため、中小企業でも気軽にAI活用が始められます。チャットボットなら「即座に返答」、文書要約なら「数十ページを数秒で処理」といった体験が期待できますね。

企業・研究機関向け

- 長文書解析: 契約書、技術文書、学術論文の高速処理

- リアルタイム応答: チャットボット、カスタマーサポートでの即座な回答

- コスト削減: 既存のGPUインフラでより多くのユーザーに対応

開発者・エンジニア向け

- プロトタイピング: 高速な実験とイテレーション

- 長コンテキストアプリケーション: 小説執筆支援、コード解析ツール

- リソース制約環境: エッジデバイスでのAI推論

⚠️ 導入時の注意点とトラブルシューティング

よくある問題と対策

問題1:既存モデルからの移行

症状: 精度の一時的な低下

対策: 段階的な移行とファインチューニングの実施

問題2:ハードウェア互換性

症状: 期待した速度向上が得られない

対策: NVIDIA H100またはA100での動作確認、ドライバー更新

問題3:長コンテキストでのメモリ不足

症状: 256Kトークン処理時のOOM(Out of Memory)エラー

対策: バッチサイズの調整、グラディエントチェックポイントの使用

技術仕様・用語解説

| 用語 | 説明 | 重要度 |

|---|---|---|

| PostNAS | 事前学習後にアーキテクチャを最適化する手法 | ⭐⭐⭐ |

| JetBlock | 動的畳み込みを使用した新しい線形アテンションブロック | ⭐⭐⭐ |

| KVキャッシュ | アテンション計算で使用するキー・値の保存領域 | ⭐⭐ |

| ハイブリッドアテンション | フルアテンションと線形アテンションの組み合わせ | ⭐⭐ |

| 線形アテンション | 計算量を線形に抑えたアテンション機構 | ⭐⭐ |

まとめ|Jet-Nemotronが切り開く新時代

🚀 Jet-Nemotronの4つの核心価値

- PostNAS: 実用的で効率的なアーキテクチャ探索手法

- JetBlock: 従来手法を凌駕する動的線形アテンション設計

- ハイブリッド戦略: 線形・フルアテンションの最適バランス

- ハードウェアファースト: パラメータ数よりキャッシュ最適化を重視

📊 衝撃的な成果の再確認

NVIDIAは、大規模なフルアテンションTransformerに頼らずとも、最大53.6倍の高速化を実現しながら最先端の精度を達成できることを実証しました。

🎯 次のステップ|今すぐできること

初心者の方

- 公式ドキュメントの確認: NVIDIA開発者サイトで最新情報をチェック

- ベンチマーク結果の詳細分析: 自社ユースケースとの適合性を評価

- 技術コミュニティへの参加: 最新の知見と実装事例を収集

上級者の方

- 実装の検討: 既存システムでの試験導入を計画

- パフォーマンス測定: 具体的な速度向上とコスト削減効果を検証

- カスタマイズの研究: 特定用途向けの最適化手法を調査

アテンション機構の再設計と最適化により、Jet-NemotronはAI推論の効率性において新たなスタンダードを確立したといえるでしょう。

従来の「より大きなモデルがより良い結果をもたらす」という固定概念から脱却し、「より賢い設計がより実用的な価値を生む」という新時代の幕開けです。

🚀 さあ、次世代LLMの世界を体験してみませんか?

この記事が役立ったら、ぜひ実際にJet-Nemotronを試してみて、その驚異的なパフォーマンスを体感してください!

この記事の著者

Mehul Gupta

DBS銀行のデータサイエンティスト。生成AIの実務活用や教育に精通し、情報発信も積極的に行う。

Mehul Gupta(メフル・グプタ)は、DBS銀行のデータサイエンティストであり、 著書『LangChain in Your Pocket』の著者としても知られています。 AIや機械学習の知見を発信するプラットフォーム「Data Science In Your Pocket」を主宰し、 Mediumでは350本以上の技術記事を執筆するトップライターとして活躍中です。 過去にはTata 1mgにて医療データのデジタル化にも取り組みました。 趣味はギター演奏とAI教育への貢献です。

この記事は著者の許可を得て公開しています。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&著書『ChatGPT最強の仕事術』は4万部突破。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。