NVIDIA Nemotron Nano v2完全ガイド|推論特化型LLMを無料で使う方法とは?

生成AIの世界では、「大きければ大きいほど良い」という常識が覆されつつあります。NVIDIAが静かに開発を進めてきた最新モデル「Nemotron-Nano-9B-v2」は、わずか90億パラメータでありながら、推論タスクで既存の大型モデルを凌駕する性能を示しています。

こんな方におすすめです!

✅ AI開発者で、効率的な推論モデルを探している方

✅ エッジデバイスでの軽量なAI実装を検討している方

✅ 最新の推論技術トレンドをキャッチアップしたい方

✅ NVIDIAエコシステムでAIプロジェクトを進めている方

この記事では、Nemotron Nano v2の特徴から実際の使用方法まで、日本の開発者が知っておくべき情報をわかりやすく解説していきます。

目次

Nemotron Nano v2とは?基本概要を理解しよう

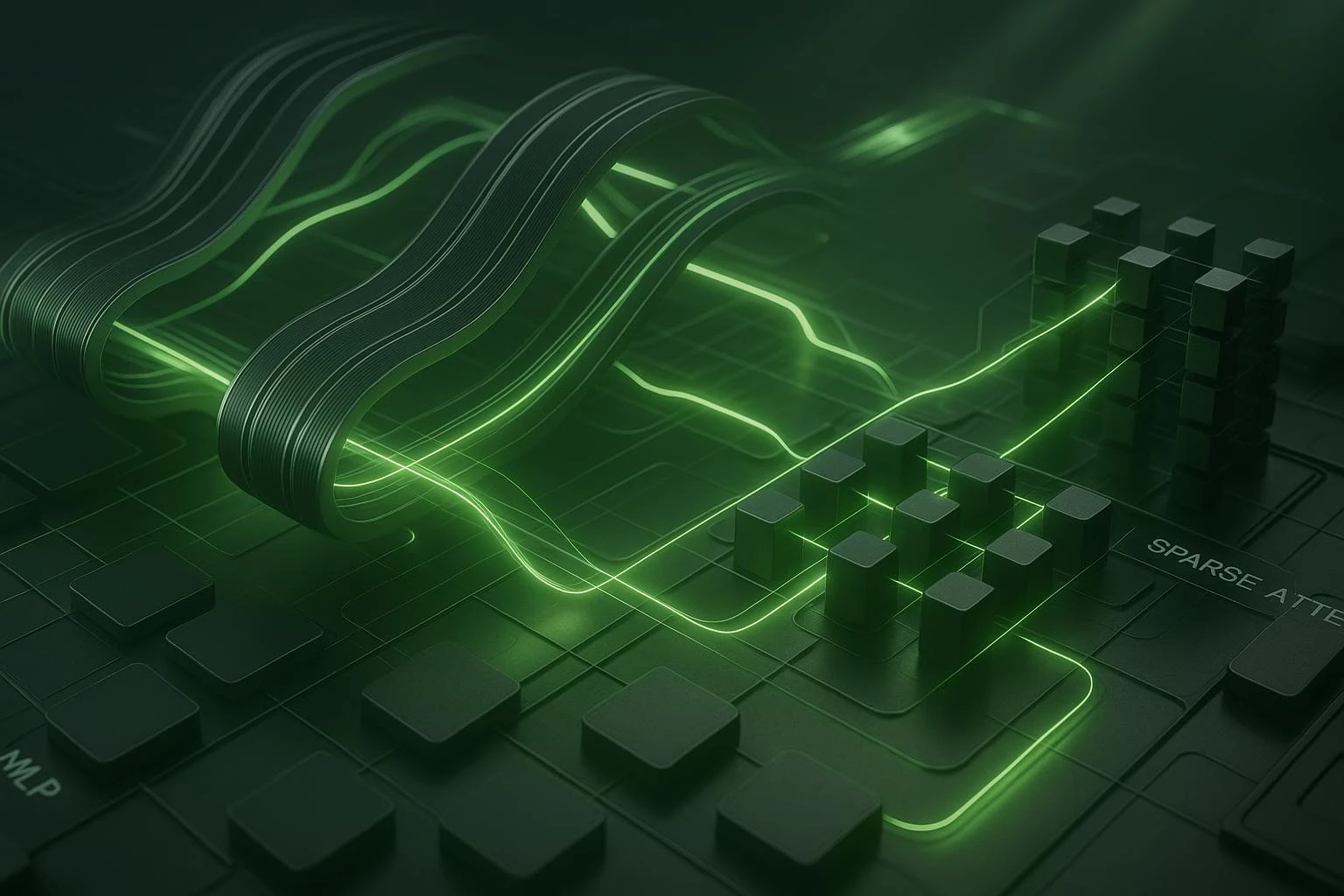

革新的なハイブリッドアーキテクチャ

Nemotron Nano v2の最大の特徴は、従来の「フルアテンション型」とは異なるハイブリッド設計にあります。

アーキテクチャの内訳

- Mamba-2: 高効率なシーケンス処理

- MLP(多層パーセプトロン): 基本的な特徴抽出

- スパースアテンション: わずか4層のみ使用

💡 なぜこの設計が画期的なのか?

従来のLLMは全レイヤーでアテンション機構を使用していましたが、NVIDIAは「必要な箇所でのみアテンションを使えば十分」という仮説のもと、計算効率を大幅に向上させました。

聞き慣れない言葉ばかりですが、普通のAIの作り方と何が根本的に違うんですか?

従来のLLMは全レイヤーでアテンション機構を使用していましたが、NVIDIAは「必要な箇所でのみアテンションを使えば十分」という仮説のもと、計算効率を大幅に向上させました。

トレーニング規模とデータソース

学習データの規模

- 総トークン数: 20兆トークン

- パブリックデータソース: Wikipedia、GitHub、arXiv、The Stackなど

- プライベートデータ: Workbench、Global Regulationなど(詳細非公開)

特に注目すべき合成データセット

- PrismMath: 高品質な数学特化データ(DeepSeek + Qwen生成)

- Art of Problem Solving: 25.5億トークンの問題解決データ(DeepSeek-R1生成)

- STEM教育データ: 豊富な科学・技術・工学・数学関連データ(OpenStax + GSM8K基盤)

⚠️ 重要ポイント

高品質な合成データを積極的に活用することで、従来の「ウェブスクレイピングデータ頼み」から脱却し、推論能力の大幅向上を実現しています。また、学習には20兆トークンを使用し、公開されているNemotron-Pre-Training-Dataset-v1は6.6兆トークンのコレクションとなっています。

推論能力の実力|ベンチマーク結果を詳しく解説

主要ベンチマークでの性能比較

Nemotron Nano v2は、同クラスのモデルと比較して優秀な結果を示しています。

Qwen3-8Bとの性能比較

- AIME25(数学的推論): 72.1%でNemotron Nano v2が上回る

- MATH500(数学問題): 97.8%で明確にリード

- GPQA(一般知識): 64.0%で明確な性能向上

- LCB(論理的推論): 顕著な改善

- RULER(長文脈理解、128K): 78.9%で優位性を示す

💡 なぜこれらの結果が重要なのか?

これらのベンチマークは実際のビジネスシーンで求められる能力(数学的計算、論理的思考、長文理解)を測定しており、実用性の高さを示す指標となります。

JetBlockは独自の動的な仕組みにより、「速度向上」と「高精度」を両立することに成功しています。

JetBlockっていう技術がすごそうですが、正直かなり複雑で理解が追いつきません…何がそんなに画期的なんでしょうか?

JetBlockの革新性は、従来の線形アテンション(Mamba2、GLAなど)が抱えていた「精度の大幅な低下」という問題を解決したことです。簡単に言うと、従来手法は「処理速度は上がるけど賢さが落ちる」というトレードオフがありました。しかしJetBlockは独自の動的な仕組みにより、「速度向上」と「高精度」を両立することに成功しています。技術的には複雑ですが、結果として「今まで以上に賢く、今まで以上に早い」AIが実現できたということです。

思考トークン制御機能の活用法

機能概要

内部推論で使用するトークン数に上限を設定可能。これにより、レスポンス速度と推論精度のバランスを調整できます。

実用的な活用シーン

- リアルタイム対話: 低遅延が求められるチャットボット

- モバイル推論: 計算リソースが限られたエッジデバイス

- バッチ処理: 大量のデータを効率的に処理

システム要件とセットアップ方法

対応ハードウェア

推奨GPU

- NVIDIA A100

- NVIDIA H100

- NVIDIA A10G

動作環境

- OS: Linux(必須)

- 実行環境: NVIDIA GPU環境(Linux)

⚠️ 注意事項

MacBookやCPUでの動作はサポートされていません。NVIDIAエコシステム内での利用が前提となります。

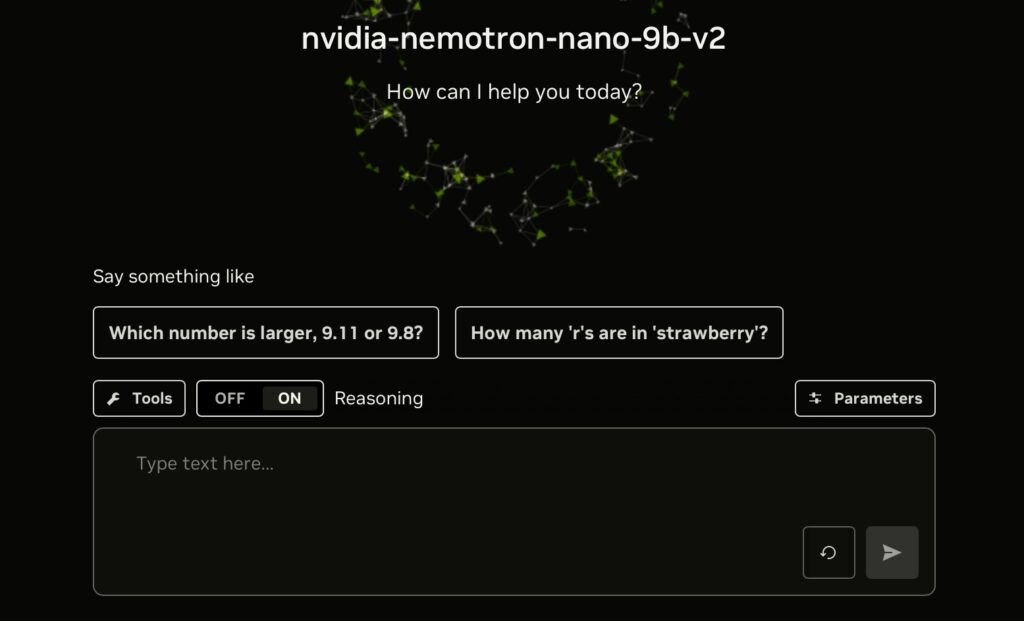

アクセス方法と利用開始手順

Step 1|Hugging Faceからアクセス

- NVIDIA/NVIDIA-Nemotron-Nano-9B-v2にアクセス

- アカウント登録(未登録の場合)

- モデルのダウンロードまたはAPI経由でのアクセス

Step 2|NVIDIA API Catalogの利用

- NVIDIA Developer Programに登録

- API Catalog内でNemotron Nano v2を選択

- 無料トライアルの開始

💡 ライセンスについて

- NVIDIA API Trial Terms of Service: 試用期間中の利用条件

- NVIDIA Open Model License: オープンモデルとしての利用規約

完全無料ではありませんが、トライアル期間中は無料で機能を検証できます。

具体的な活用シーンとユースケース

推奨される利用分野

1. エージェント開発

- 指示に従って自律的に動作するAIエージェント

- 複雑なタスクの分解と実行

- 外部ツールとの連携

2. コーディング支援

- 対応言語: 43のプログラミング言語

- デバッグ支援とコードレビュー

- アルゴリズムの説明と最適化提案

3. RAGパイプライン

- 検索拡張生成(Retrieval-Augmented Generation)

- 企業内文書の検索と要約

- 知識ベースとの連携

4. 数学・論理的推論

- 複雑な計算問題の解決

- 論理的思考プロセスの可視化

- 教育分野での活用

速くなるのはすごそうですが、実際のビジネスではどんな場面で活用できるんでしょうか?

最も分かりやすいのは「長い文書を扱う業務」での劇的な改善です。例えば、法務部門での契約書チェック、研究部門での学術論文の分析、カスタマーサポートでの過去やり取り履歴を踏まえた回答生成などが考えられます。また、従来なら高性能なサーバーが必要だった処理が、RTX 3090のような比較的身近なGPUでも実行できるようになるため、中小企業でも気軽にAI活用が始められます。チャットボットなら「即座に返答」、文書要約なら「数十ページを数秒で処理」といった体験が期待できますね。

実装時の注意点とベストプラクティス

パフォーマンス最適化のコツ

✅ 思考トークン数を用途に応じて調整

✅ バッチサイズを適切に設定

✅ GPU メモリ使用量の監視

よくある問題と対処法

⚠️ メモリ不足エラー: バッチサイズを小さくする

⚠️ 推論速度が遅い: 思考トークン制限を設定

⚠️ 精度が期待より低い: プロンプトエンジニアリングを見直す

開発コストと環境負荷について

トレーニングにかかったリソース

計算コスト

- 総FLOP数: 1.53E+24 FLOP

- 消費電力: 747.6メガワット時

- ベース事前学習: 708 MWh

- 後処理: 35 MWh

- プルーニング・蒸留: 3.7 MWh

💡 これらの数字が意味すること

大規模モデルの開発には莫大なエネルギーが必要ですが、一度開発されれば、効率的な推論により長期的な省エネルギーに貢献します。

まとめ|Nemotron Nano v2を今すぐ試すべき理由

Nemotron Nano v2は、「小さいながらも賢い」という新しいLLMの可能性を示すモデルです。特に以下の点で優れています:

主なメリット

🎯 効率性: 少ないパラメータで高い推論能力

🎯 実用性: リアルタイムアプリケーションに適した速度

🎯 柔軟性: 思考プロセスの制御が可能

🎯 専門性: 数学・論理推論に特化した性能

次のアクションプラン

- まずは体験: Hugging Faceで無料トライアル

公式サイト:https://huggingface.co/ - 用途の検討: 自分のプロジェクトでの活用方法を想像

- 比較検証: 既存ソリューションとの性能比較

- 本格導入: プロダクション環境での実装検討

AIの世界は日々進化しています。Nemotron Nano v2のような効率性と性能を両立したモデルは、今後のAI開発の方向性を示唆する重要な存在です。ぜひ実際に手を動かして、その可能性を体感してみてください!

この記事の著者

Mehul Gupta

DBS銀行のデータサイエンティスト。生成AIの実務活用や教育に精通し、情報発信も積極的に行う。

Mehul Gupta(メフル・グプタ)は、DBS銀行のデータサイエンティストであり、 著書『LangChain in Your Pocket』の著者としても知られています。 AIや機械学習の知見を発信するプラットフォーム「Data Science In Your Pocket」を主宰し、 Mediumでは350本以上の技術記事を執筆するトップライターとして活躍中です。 過去にはTata 1mgにて医療データのデジタル化にも取り組みました。 趣味はギター演奏とAI教育への貢献です。

この記事は著者の許可を得て公開しています。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&著書『ChatGPT最強の仕事術』は4万部突破。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。