Qwen3-Next:学習コスト10分の1で推論速度10倍、Gemini2.5を超える革新的AIモデル

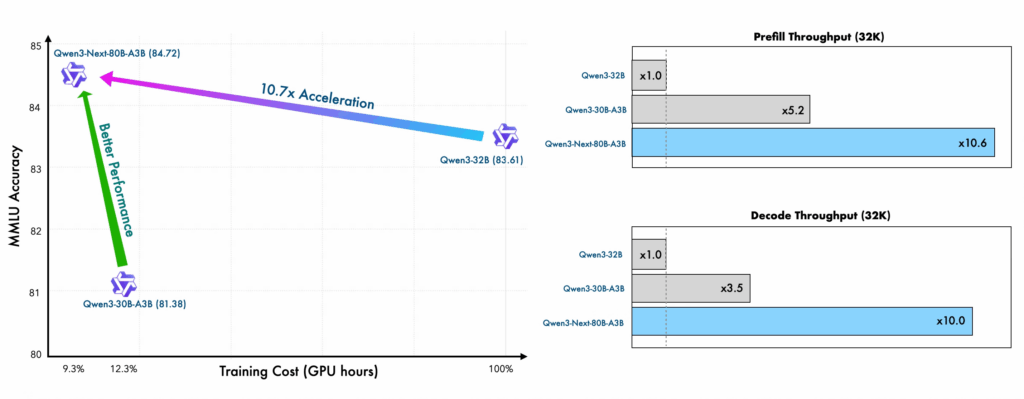

中国のアリババが開発したQwen3-Nextが、AI業界に大きな衝撃を与えています。このモデルは従来の大規模言語モデルが抱えていた「高い学習コスト」「遅い推論速度」「限定的なコンテクスト処理能力」という三大課題を一気に解決し、一部のベンチマークではGoogleのGemini 2.5 Flash Thinkingを上回る性能を実現しました。

特に注目すべきは、800億パラメータという大規模モデルでありながら、推論時には実質30億パラメータのみを使用する革新的な設計です。これにより、従来モデルと比較して学習コストを10分の1以下に削減し、32Kトークン以上の長文処理では10倍以上の推論スループットを達成しています。

本記事では、Qwen3-Nextの革新的な技術仕様と、なぜこれほどまでに効率的な処理が可能になったのか、その背景にある技術的ブレークスルーを詳しく解説します。

目次

Qwen3-Nextとは:次世代AIモデルの全体像

Qwen3-Nextは、アリババが2025年9月に発表した次世代基本モデルアーキテクチャです。このモデルは、大規模言語モデルの効率と性能を向上させるための新しいアーキテクチャを採用し、従来のQwenモデルシリーズを大幅に進化させました。

最大の特徴は、ハイブリッドアテンションメカニズムとMoE(Mixture of Experts)構造を組み合わせた革新的な設計にあります。この組み合わせにより、800億パラメータという大規模なモデルサイズを維持しながら、実際の推論時には約30億パラメータのみを活用する超効率的な処理を実現しています。

具体的な性能面では、235億パラメータのモデルと同等のパフォーマンスを示しながら、学習コストは10パーセント未満に抑制。さらに、32Kトークンを超える長文コンテクストにおいて、従来モデルの10倍以上のスループットを実現しています。

革新的技術1:ハイブリッドアテンションメカニズムの仕組み

Qwen3-Nextの核心技術の一つが、ハイブリッドアテンションメカニズムです。この技術は、従来のTransformerアーキテクチャが抱えていた計算コストとメモリ使用量の急激な増加問題を根本的に解決します。

従来の標準的なTransformerでは、コンテキスト長を拡張すると、メモリや計算コストが二次関数的に増加するという課題がありました。Qwen3-Nextは、Gated DeltaNetと標準アテンションレイヤーを3:1の比率で組み合わせることで、この問題を解決しています。

この設計により、遠く離れたトークン間の依存関係を保持しながら、効率的な処理を実現。特に長文処理において、従来モデルでは処理が困難だった大量のテキストデータを、高速かつ正確に解析できるようになりました。

実際の処理では、軽量かつ近似的な手法を採用することで、計算負荷を大幅に軽減しつつ、モデルの表現力を維持しています。これにより、32Kトークンを超える長文コンテクストでも、実用的な速度での推論が可能になっています。

革新的技術2:超スパースMoE設計による効率化

Qwen3-Nextのもう一つの革新技術が、超スパースMoE(Mixture of Experts)設計です。この技術は、512個の総エキスパートを持ちながら、推論中には10個のルーティングエキスパートと1個の共有エキスパートのみを組み合わせて使用します。

この設計の優れた点は、特定のタスクに最も適したエキスパートのみをアクティブ化し、他のエキスパートは待機状態に保つことで、計算効率を大幅に向上させていることです。800億パラメータという大規模なモデルでありながら、実際に使用されるのはわずか30億パラメータという効率的な処理を実現しています。

この仕組みにより、従来の大規模モデルが抱えていた「高い計算コスト」と「遅い推論速度」という課題を同時に解決。特に、入力トークンが多い状況では10倍以上の高速推論処理が可能になり、実用的なアプリケーションでの活用範囲が大幅に拡大しました。

コスト削減の実績:学習・推論両面での大幅効率化

Qwen3-Nextが業界に与えた最大のインパクトの一つが、圧倒的なコスト削減効果です。従来モデルと比較して、学習コストを10分の1以下に削減し、推論コストも大幅に軽減しています。

学習コストの削減効果

従来の大規模言語モデルの開発では、膨大な計算リソースと時間が必要でした。Qwen3-Nextは、ハイブリッドアテンションメカニズムと超スパースMoE設計により、同等の性能を維持しながら学習コストを10パーセント未満に抑制しています。

この削減効果により、高性能なAIモデルの開発・運用における経済的障壁が大幅に低下し、より多くの組織や研究機関がAI開発に参入できる環境が整いました。

推論コストの最適化

推論処理においても革新的な効率化を実現しています。特に32Kトークン以上の長文処理では、従来モデルの10倍以上の推論スループットを達成。これにより、大量のドキュメント解析や長文生成タスクが、実用的なコストと時間で処理可能になりました。

この高速化は、リアルタイムでの顧客サポート、大規模なログ解析、複雑な文書処理など、様々な実用的アプリケーションでの活用を可能にしています。

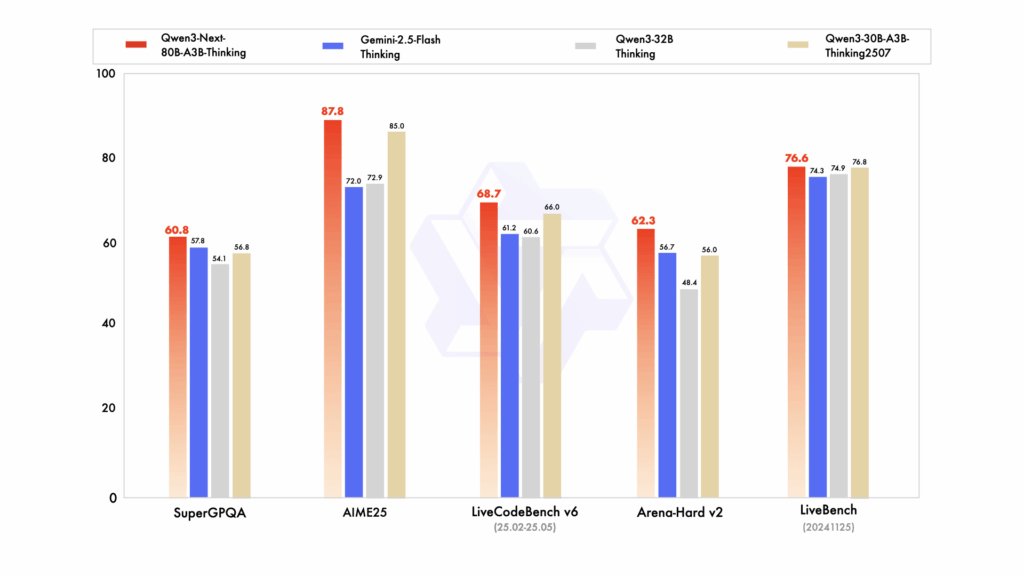

ベンチマーク性能:Gemini 2.5 Flash Thinkingを上回る実力

Qwen3-Nextの真価は、客観的なベンチマーク評価において明確に示されています。特に複雑な推論タスクにおいて、Gemini 2.5 Flash Thinkingを上回る性能を複数のベンチマークで達成しています。

主要ベンチマークでの優位性

Qwen3-Next-Thinkingモデルは、以下のベンチマークでGemini 2.5 Flash Thinkingを上回る結果を記録しました。

- GPQA(科学的推論):複雑な科学的問題解決において優位性を示す

- 数学問題解決:高度な数学的推論タスクで高い精度を実現

- ライブ行動アリーナハードV2:実践的な問題解決能力で優秀な成績

これらの結果は、Qwen3-Nextが単なる効率化だけでなく、実際の問題解決能力においても最高水準の性能を持つことを証明しています。

235億パラメータモデルとの比較

さらに注目すべきは、Qwen3-Nextが235億パラメータの大規模モデルと同等、または一部で上回る性能を示していることです。これは、効率的なアーキテクチャ設計により、パラメータ数に依存しない高い性能を実現していることを意味します。

大規模コンテクスト対応:最大262,144トークンの処理能力

Qwen3-Nextは、長文処理において従来モデルを大幅に上回る能力を持っています。最大262,144トークンの処理が可能で、YaRN技術により100万トークンまで拡張可能な設計になっています。

長文処理の実用的メリット

32Kトークン以上の長文コンテクストにおいて、Qwen3-Nextは従来のQwen3-32Bモデルの10倍以上のスループットを実現しています。これにより、以下のような実用的なメリットが生まれます:

| 用途 | 従来の課題 | Qwen3-Nextでの改善 |

| 大規模文書解析 | 処理時間が長く、コストが高い | 10倍高速化、大幅なコスト削減 |

| 長文生成 | 一貫性の維持が困難 | 長文コンテクストで高い一貫性 |

| 複雑な推論タスク | メモリ不足で処理不可 | 効率的なメモリ使用で処理可能 |

技術的な処理効率

ハイブリッドアテンションメカニズムにより、長文処理時のメモリ使用量を大幅に削減しながら、処理精度を維持しています。これは、従来のTransformerアーキテクチャでは実現困難だった、実用的な長文処理を可能にする革新的な技術です。

実用的な活用事例と応用可能性

Qwen3-Nextの革新的な性能は、様々な実用的なアプリケーションでの活用を可能にしています。特に、コスト効率と処理速度の両面での優位性により、従来は実現困難だった用途での活用が期待されています。

開発・技術分野での活用

ログ解析・開発支援システムでは、Qwen3-Nextの長文処理能力を活用した革新的なアプリケーションが登場しています。大量のログファイルやエラー報告を瞬時に分析し、問題箇所を特定するツールが実用化されており、開発効率の大幅な向上を実現しています。

ビジネス・顧客サポート分野

多言語対応(119言語・方言対応)を生かしたグローバル対応システムが構築されています。Model Context Protocol(MCP)とファンクションコールに標準対応しているため、エージェント型タスクにおいて他のオープンソースモデルをリードする性能を発揮しています。

研究・教育分野での可能性

高い処理効率により、研究機関や教育機関でも導入しやすいコスト構造を実現。複雑な学術文献の解析や、大規模なデータセットの処理が、限られた予算内で実行可能になっています。

オープンソース戦略とアクセシビリティ

Qwen3-Nextは、アリババのオープンソース戦略の一環として公開されており、研究者や開発者が自由に利用できる環境が整備されています。これにより、AI技術の民主化と普及が加速されることが期待されています。

800億パラメータという大規模モデルでありながら、効率的な設計により、比較的小規模なローカル環境でも動作可能な設計になっています。これは、大企業だけでなく、スタートアップや個人開発者にとっても、高性能なAIモデルへのアクセスを可能にする重要な要素です。

また、従来のQwen3シリーズ全般において最大97%の価格削減を実現しているという報告もあり、AI技術の活用における経済的障壁を大幅に低下させています。

まとめ

Qwen3-Nextは、AI業界における真の技術革新を実現したモデルです。主要なポイントを以下にまとめます:

- 革新的アーキテクチャ:ハイブリッドアテンションメカニズムと超スパースMoE設計により、効率と性能を両立

- 圧倒的なコスト削減:学習コストを10分の1以下、推論コストも大幅削減を実現

- 高速処理能力:32Kトークン以上の長文処理で10倍以上のスループットを達成

- 優秀なベンチマーク性能:Gemini 2.5 Flash Thinkingを上回る複数のベンチマーク結果

- 大規模コンテクスト対応:最大262,144トークン、拡張により100万トークンまで処理可能

これらの特徴により、Qwen3-Nextは単なる性能向上ではなく、AI技術の活用における根本的なパラダイムシフトを実現しています。高性能なAI技術がより身近で実用的な存在となり、様々な分野での革新的な活用が期待される、まさに次世代のAIモデルと言えるでしょう。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 Qwen3-Nextとは何ですか?

Qwen3-Nextは、アリババが開発した次世代のAIモデルアーキテクチャです。大規模言語モデルの効率と性能を向上させることを目指し、ハイブリッドアテンションメカニズムとMoE(Mixture of Experts)構造を組み合わせて、学習コストと推論速度を大幅に改善しています。

Q2 Qwen3-Nextは従来のモデルと比べて、どの程度コストが削減されますか?

Qwen3-Nextは、ハイブリッドアテンションメカニズムと超スパースMoE設計により、従来のモデルと比較して学習コストを10分の1以下に削減しています。また、推論コストも大幅に軽減されており、AI開発・運用における経済的障壁を大きく下げています。

Q3 Qwen3-NextはどのようなタスクでGemini 2.5 Flash Thinkingを上回る性能を発揮しますか?

Qwen3-Nextは、GPQA(科学的推論)、数学問題解決、ライブ行動アリーナハードV2といった複雑な推論タスクにおいて、Gemini 2.5 Flash Thinkingを上回る性能を発揮します。特に科学的な問題解決や高度な数学的推論において高い精度を実現しています。

Q4 Qwen3-Nextは最大でどのくらいの長さの文章を処理できますか?

Qwen3-Nextは、最大262,144トークンまでの文章を処理できます。さらに、YaRN技術を使用することで、100万トークンまで拡張可能です。これにより、大規模な文書解析や長文生成タスクにおいて、高いパフォーマンスを発揮します。

Q5 Qwen3-Nextはオープンソースですか?

はい、Qwen3-Nextはアリババのオープンソース戦略の一環として公開されており、研究者や開発者が自由に利用できます。これにより、AI技術の民主化と普及が促進されることが期待されています。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。