CAG(Cache-Augmented Generation)とは?パナソニックコネクトのカスハラAI導入事例から学ぶRAGとの違いと実装メリット

2025年、カスタマーハラスメント(カスハラ)対策が企業にとって重要な課題となる中、パナソニックコネクトが注目すべき技術的アプローチでカスハラ相談AIを実装しました。従来のRAG(Retrieval-Augmented Generation)ではなく、CAG(Cache-Augmented Generation)という手法を採用したのです。

この記事では、パナソニックコネクトの実装事例を通じて、CAGとRAGの根本的な違い、CAGを選択する判断基準、そして実装時のメリットについて詳しく解説します。特に、限定的なドキュメントを扱う企業内AIシステムを検討している方にとって、技術選択の重要な指針となる内容をお届けします。

目次

パナソニックコネクトのカスハラ相談AI実装事例

パナソニックコネクトは、2025年6月にカスハラ対応方針を発信し、社内でカスタマーハラスメントを受けた従業員が相談できる特化AIシステムを導入しました。同社は初期の頃からAI導入を積極的に進めており、その豊富な経験を活かした今回の実装は業界でも注目を集めています。

今回の特化AIの最大の特徴は、対象ドキュメントが「対応例を含んだカスハラ対応マニュアルのみ」という限定的な範囲であったことです。この条件を踏まえ、同社はRAGではなくCAGを採用するという戦略的判断を下しました。

CAGの実装により、対象となるファイル全文をAIが生成時に参照できる仕組みを構築。これはインコンテキストラーニングの考え方に基づいており、全文をプロンプトに含めて対応する手法です。マニュアル程度の文書量であれば、現在のLLMのコンテキストウィンドウに余裕で収まり、利用回数が限定的であれば大幅なコスト増加にもならないという実用的な判断でした。

CAGとRAGの根本的な違いとは

CAG(Cache-Augmented Generation)とRAG(Retrieval-Augmented Generation)は、どちらも大規模言語モデルの知識拡張手法ですが、そのアプローチには根本的な違いがあります。

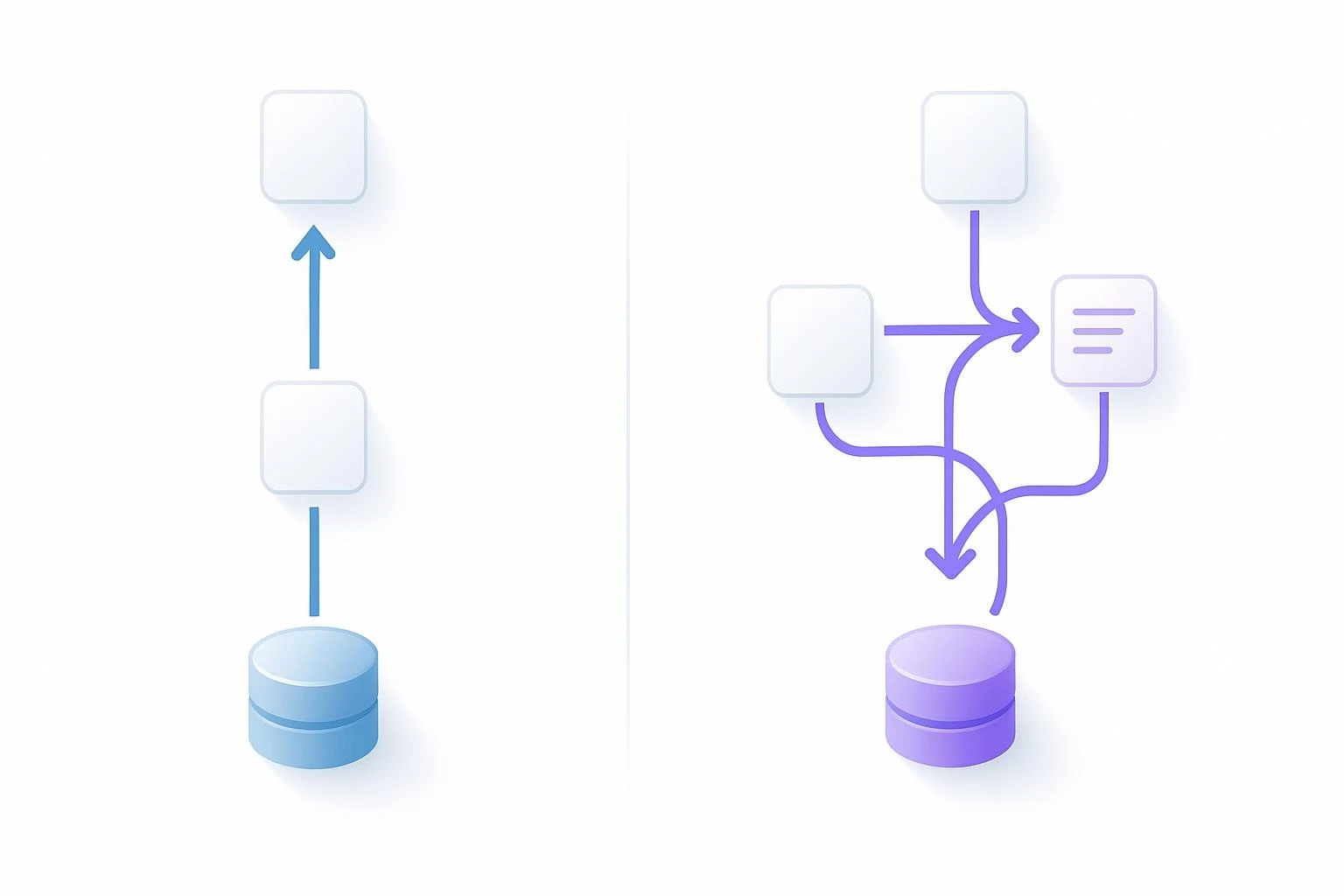

処理フローの違い

RAGの処理フロー:

- ユーザーからの質問があるたびに、毎回データベースから関連情報を検索

- 検索された情報と質問を組み合わせてLLMに入力

- 回答を生成

CAGの処理フロー:

- 事前に知識ベース全体をLLMのコンテキストに読み込み

- 推論時は検索なしで、プリロードされた情報から直接回答生成

- 検索ステップを完全に省略

インコンテキストラーニングとの違い

CAGとインコンテキストラーニングは密接に関連していますが、実装面で重要な違いがあります。インコンテキストラーニングは毎回プロンプトに全ての情報を含める手法ですが、CAGは各LLMが提供するキャッシュ機能を活用します。

具体的には、OpenAIやGoogle Geminiなどが提供するコンテキストキャッシュ機能を使用することで、同じ文書を繰り返し処理する際の効率を大幅に向上させます。キャッシュを使用することで、処理速度の向上とコスト削減の両方を実現できるのです。

CAGを選択すべき条件と判断基準

パナソニックコネクトの事例から、CAGが適している条件を整理すると以下のようになります:

| 条件 | CAGの適用可否 | 理由 |

| 対象ドキュメント数 | 限定的(マニュアル1冊程度) | コンテキストウィンドウに収まる範囲 |

| 利用頻度 | 中程度以下 | コスト効率が良い |

| 精度要求 | 高い | 全文参照により高精度を実現 |

| 応答速度 | 重視する | 検索ステップがないため高速 |

精度向上のメカニズム

CAGが高精度を実現できる理由は、検索による情報の取りこぼしがないことにあります。RAGでは関連性の高い情報を検索して取得しますが、検索アルゴリズムの限界により、重要な情報が漏れる可能性があります。

一方、CAGでは対象ドキュメント全文がコンテキストに含まれているため、LLMは全ての情報を参照して回答を生成できます。特にマニュアルのような体系的な文書では、この全文参照のメリットが顕著に現れます。

今後の技術発展とCAGの展望

2025年現在、LLMのコンテキストウィンドウは数十万〜数百万トークンまで拡大しており、CAGで扱える文書量は飛躍的に増加しています。この技術進歩により、従来はRAGでしか対応できなかった大規模な文書群も、CAGでの処理が可能になりつつあります。

また、各LLMプロバイダーがキャッシュ機能の改善を続けており、CAGの経済性はさらに向上すると予想されます。特に企業内の限定的な文書を扱うユースケースでは、CAGの優位性がより明確になると考えられます。

ただし、複雑度が高いタスクにおいては、LLMの推論能力に限界があることも明らかになっており、CAGとRAGの使い分けがより重要になってくるでしょう。

まとめ

パナソニックコネクトのカスハラ相談AI実装事例は、CAGという技術選択の有効性を実証する重要な事例です。以下のポイントを改めて整理します:

- CAGは限定的な文書群に対して高精度な回答を提供できる技術

- 検索ステップを省略することで、処理速度とコスト効率を向上

- キャッシュ機能の活用により、繰り返し利用時の経済性が大幅改善

- 対象文書の特性と利用パターンを慎重に分析した技術選択が重要

- マニュアルや規程など、完結性の高い文書での効果が特に高い

企業でAIシステムを導入する際は、RAGとCAGの特性を理解し、自社の要件に最適な技術を選択することが成功の鍵となります。パナソニックコネクトの事例は、その判断基準と実装アプローチの優れた参考例として、多くの企業にとって価値ある示唆を提供しています。

よくある質問(FAQ)

Q1 CAG(Cache-Augmented Generation)とは何ですか?

CAG(Cache-Augmented Generation)は、大規模言語モデル(LLM)の知識拡張手法の一つで、事前に知識ベース全体をLLMのコンテキストに読み込ませ、推論時に検索なしで直接回答を生成する技術です。特に、対象ドキュメントが限定的な場合に、RAGよりも高精度かつ高速な回答を提供できるとされています。

Q2 RAG(Retrieval-Augmented Generation)とCAG(Cache-Augmented Generation)の主な違いは何ですか?

RAGは、ユーザーからの質問があるたびにデータベースから関連情報を検索し、その情報と質問を組み合わせてLLMに入力して回答を生成します。一方、CAGは事前に知識ベース全体をLLMに読み込ませるため、検索ステップが不要です。RAGは大量のドキュメントに対応できますが、CAGは限定的なドキュメントでの利用に適しています。

Q3 どのような場合にCAG(Cache-Augmented Generation)を選択すべきですか?

CAGは、対象ドキュメントが限定的(マニュアル1冊程度など)、利用頻度が中程度以下、高い精度が要求される、応答速度を重視する場合に適しています。特に、企業内のマニュアルや規定など、単体で完結した情報を含む文書に対して効果を発揮します。

Q4 CAG(Cache-Augmented Generation)を実装する際のコスト構造はどのようになっていますか?

CAGでは、初回読み込み時に大きなトークン数を消費しますが、キャッシュ機能により2回目以降のコストが大幅に削減されます。利用回数が少ない場合でも1回あたりのコストは比較的高くなります。主要なLLMプロバイダーが提供するキャッシュ機能を活用することで、コストを最適化できます。

Q5 パナソニックコネクトがカスハラ相談AIにCAG(Cache-Augmented Generation)を採用した理由は何ですか?

パナソニックコネクトでは、カスハラ対応マニュアルという限定的なドキュメントを対象としていたため、CAGが適していると判断しました。CAGは、マニュアル全文をAIが参照できるため、高精度な回答が期待できます。また、利用頻度が限定的であれば、コスト効率が良いという点も考慮されました。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。