RAG(Retrieval-Augmented Generation)システムの処理速度に課題を感じていませんか?検索した文書をLLMに渡すたびに、長いレスポンス時間に悩まされている方も多いのではないでしょうか。

そんな中、Meta社のSuperintelligence Labsが2025年9月に発表した「REFRAG」という革新的な技術が、RAGの世界に大きな変革をもたらそうとしています。この技術は、従来のRAGシステムを30倍高速化し、さらにコンテキストサイズを16倍に拡張することを可能にします。

本記事では、REFRAGの核心的な仕組みから実際の性能向上まで、この画期的な技術について詳しく解説します。RAGシステムの効率化を検討している方にとって、明日からの実装に向けた具体的な知見を得られる内容となっています。

目次

REFRAGとは何か?従来のRAGとの根本的な違い

REFRAGは「REpresentation For RAG」の略称で、従来のRAGシステムが抱える根本的な課題を解決する革新的なアプローチです。

従来のRAGシステムでは、外部データベースから関連する文書を検索し、その文書をテキスト形式のままLLMに渡していました。しかし、REFRAGは全く異なるアプローチを採用しています。検索した文書をベクトル形式に圧縮し、そのベクトルデータを直接LLMに投入するのです。

この違いは単なる技術的な改良ではありません。人間が使う言語は本質的に冗長であり、LLMに理解させる目的であれば、もっと効率的な形式で情報を伝達できるという発想に基づいています。つまり、「文書=たくさんのトークン」ではなく「文書=圧縮されたチャンク埋め込み(ベクトル)」として捉え直すことで、処理効率を劇的に向上させているのです。

REFRAGの核心技術:3つの要素による効率的な処理

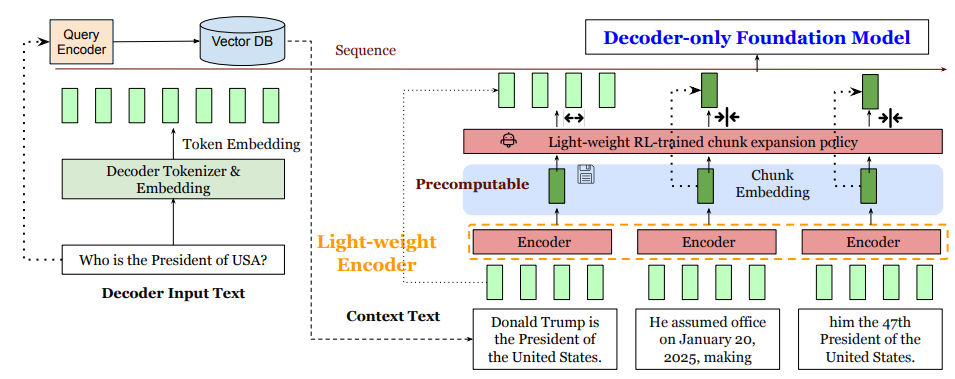

REFRAGは「圧縮(Compression)」「感知(Sensing)」「拡張(Expansion)」という3つの核心技術から構成されています。

1. 圧縮技術:チャンク埋め込みによる情報の効率化

まず、検索で取得したデータは16個のキャラクターごとに分割され、それぞれがベクトル化されます。この際、軽量エンコーダーを使用して、各チャンクを固定サイズの圧縮ベクトルに変換します。

重要なのは、この圧縮プロセスで情報が失われないよう、事前学習によって精度を担保している点です。エンコーダーとデコーダーを連携させる学習レシピにより、デコーダーが圧縮されたチャンク埋め込みを元のチャンク埋め込みとして正確に解釈できるよう訓練されています。

2. セレクティブコンプレッション:必要に応じた柔軟な処理

REFRAGの特徴的な機能として、セレクティブコンプレッションがあります。これは、ベクトルで十分な情報が得られると判断される場合はベクトルを使用し、ベクトルでは情報が不足すると判断される場合は元のテキストを使用するという、状況に応じた柔軟な処理を行います。

この判断は強化学習によって最適化されたポリシーによって行われ、チャンク埋め込みを保持するか、元のトークンフォーマットを保持するかを動的に決定します。

3. 効率的な再構築:情報の正確な復元

圧縮されたベクトルから必要な情報を正確に復元するため、REFRAGは再構築タスクによる学習を行います。エンコーダーが入力トークンを圧縮し、デコーダーが圧縮された埋め込みを使用して元のトークンを正確に再構築できるよう学習されています。

驚異的な性能向上:30倍の高速化と16倍の容量拡張

REFRAGの実験結果は、従来のRAGシステムと比較して驚異的な性能向上を示しています。

| 性能指標 | 改善倍率 | 具体的な効果 |

| 初回トークン生成速度 | 30倍高速化 | 従来3秒かかっていた処理が0.1秒で完了 |

| コンテキストサイズ | 16倍拡張 | より多くの関連情報を同時に処理可能 |

| 全体的な処理速度 | 約9倍向上 | レスポンス時間の大幅な短縮 |

特に注目すべきは、初回トークン生成時間の30倍高速化です。これは、ユーザーがクエリを送信してから最初の応答が返ってくるまでの時間が劇的に短縮されることを意味します。例えば、従来1秒かかっていた処理が約0.033秒で完了するようになります。

また、答えの正確性についても、従来の高速化手法と比較して精度の低下は見られず、むしろ一部のケースでは精度が向上していることが確認されています。

REFRAGが解決する従来RAGの課題

REFRAGが画期的である理由を理解するために、従来のRAGシステムが抱えていた課題を整理してみましょう。

情報圧縮による情報損失の問題

通常のRAGシステムでは、ベクトル化は検索のためだけに使用され、実際にLLMに渡されるのは元の文書データでした。しかし、ベクトル化の過程で意味的な情報が失われる可能性があり、特に独自性の高いデータや専門的な内容では情報の劣化が懸念されていました。

REFRAGは、事前学習によってこの問題を解決しています。ベクトル化後も元の情報を高い確率で保持できるよう、モデルが学習されているため、情報損失を最小限に抑えながら効率化を実現しています。

コンテキスト長の制限による情報取得の限界

従来のRAGシステムでは、LLMのコンテキストサイズの制限により、取得できる関連情報の量が限られていました。特に、検索で得られた関連性の低い情報が多い場合、本当に必要な情報を十分に取得できないという課題がありました。

REFRAGは、コンテキストサイズを16倍に拡張することで、より多くの関連情報を同時に処理できるようになりました。これにより、検索の関連性が低い場合でも、より多くの情報から有用な内容を抽出できるようになっています。

REFRAGの適用場面と実用性の考察

REFRAGの技術的特性を踏まえると、その適用場面は明確に分かれると考えられます。

高い効果が期待できる場面

一般的な情報が多く含まれる元データに対しては、REFRAGは非常に高い効果を発揮すると考えられます。十分な事前学習により、入力トークンとベクトルが近い出力を生成するよう訓練できるため、かなり高い精度で検索結果や回答を生成できるでしょう。

具体的には、以下のような用途で特に効果的と予想されます:

- FAQ システムや顧客サポート

- 一般的な知識ベースを活用した質問応答

- 標準的な文書形式での情報検索

- 大量の類似文書からの情報抽出

慎重な検討が必要な場面

一方で、独自性が非常に高いデータや特殊な専門分野のデータについては、慎重な検討が必要です。ベクトル化の際に情報が破損する確率が高く、個別性が犠牲になる可能性があるため、仕様について十分な検証が必要でしょう。

また、適切な事前学習を大量に行う必要があるため、RAGのソースとなるデータベースの性質によって、使用可能かどうかが明確に決まってくると考えられます。

実装における技術的考慮事項

REFRAGを実際のシステムに導入する際には、いくつかの重要な技術的考慮事項があります。

事前学習の重要性

REFRAGの精度を担保するためには、適切な事前学習が不可欠です。エンコーダーとデコーダーを連携させる学習レシピにより、圧縮されたベクトルから元の情報を正確に復元できるよう、十分な学習を行う必要があります。

特に、再構築タスクでは、入力が通常のテキストの場合の結果と、入力がベクトル化されたデータの場合の出力を整合させる学習が重要になります。

セレクティブコンプレッションの最適化

強化学習によるセレクティブコンプレッションのポリシー最適化も重要な要素です。どの情報をベクトル形式で処理し、どの情報を元のテキスト形式で処理するかの判断基準を、対象ドメインに応じて適切に調整する必要があります。

REFRAGがもたらす未来への展望

REFRAGの登場は、RAGシステムの効率化において大きな転換点となる可能性があります。30倍の高速化と16倍の容量拡張という性能向上は、これまで処理時間やリソースの制約で実現できなかった用途での活用を可能にするでしょう。

特に、リアルタイム性が求められるアプリケーションや、大量の文書を扱う企業システムにおいて、REFRAGの技術は大きな価値を提供すると考えられます。

ただし、適切な学習が行われれば様々なタイプのデータに応用可能と考えられるものの、実装には十分な検証と最適化が必要です。特に、対象ドメインの特性を十分に理解し、適切な事前学習とポリシー調整を行うことが成功の鍵となるでしょう。

まとめ

REFRAGは、従来のRAGシステムの課題を根本的に解決する革新的な技術として、大きな注目を集めています。本記事で解説した主要なポイントを改めて整理すると:

- 核心技術:文書をベクトル形式で圧縮してLLMに直接投入する革新的なアプローチ

- 性能向上:初回トークン生成を30倍高速化、コンテキストサイズを16倍拡張

- 3つの要素:圧縮、セレクティブコンプレッション、効率的な再構築による最適化

- 精度担保:事前学習による情報損失の最小化と高精度の維持

- 適用場面:一般的な情報では高効果、専門性の高いデータでは慎重な検討が必要

REFRAGの技術は、RAGシステムの効率化を検討している組織にとって、大きな可能性を秘めています。ただし、成功のためには対象データの特性を十分に理解し、適切な学習と最適化を行うことが不可欠です。今後の発展と実用化に向けた動向に、引き続き注目していく価値があるでしょう。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 REFRAGとは何ですか?

REFRAG(REpresentation For RAG)は、Meta社が開発したRAGシステムを高速化する技術です。従来のRAGシステムではテキスト形式でLLMに文書を渡していましたが、REFRAGでは文書をベクトル形式に圧縮してLLMに投入することで、処理速度を大幅に向上させます。

Q2 REFRAGは従来のRAGシステムと何が違うのですか?

従来のRAGシステムでは、検索した文書をテキストのままLLMに渡していましたが、REFRAGは検索した文書をベクトル形式に圧縮してLLMに渡します。これにより、LLMが処理するデータ量を削減し、処理速度を向上させることができます。

Q3 REFRAGによってRAGシステムはどれくらい高速化されますか?

REFRAGを導入することで、RAGシステムの初回トークン生成速度が最大30倍高速化されます。また、コンテキストサイズも16倍に拡張されるため、より多くの情報を一度に処理できるようになります。全体的な処理速度は約9倍向上します。

Q4 REFRAGのコア技術は何ですか?

REFRAGは主に3つのコア技術で構成されています。「圧縮(Compression)」は、テキストデータをベクトル形式に変換しデータ量を削減します。「感知(Sensing)」は、ベクトルと元のテキストのどちらを使用するかを判断します。「拡張(Expansion)」は、圧縮されたベクトルから必要な情報を正確に復元します。

Q5 REFRAGはどのような場面で活用できますか?

REFRAGは、FAQシステムや顧客サポート、一般的な知識ベースを活用した質問応答など、一般的な情報が多く含まれる元データに対して高い効果を発揮します。ただし、独自性の高いデータや特殊な専門分野のデータについては、慎重な検討が必要です。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。