大規模言語モデル(LLM)の性能向上に伴い、メモリ使用量の増大が深刻な課題となっています。高性能なモデルほど大量のメモリを必要とし、一般的なデバイスでの実行が困難になっているのが現状です。しかし、ファーウェイのチューリッヒ研究センターが開発した革新的な量子化技術「SINQ」が、この問題に対する画期的な解決策を提供しています。

SINQは、従来の量子化手法が抱えていた「外れ値問題」を根本的に解決し、モデルの精度をほぼ維持しながらメモリ使用量を60~70%削減することを実現する技術です。これにより、これまでデータセンター級の高性能ハードウェアでしか動作しなかった大規模モデルが、スマートフォンやパソコンなどの一般的なデバイスでも利用可能になる可能性が広がっています。

目次

量子化技術とは何か?基本概念を理解する

量子化とは、モデルの重みの精度を意図的に下げることで、計算負荷とメモリ使用量を削減する技術です。例えば、通常16桁で表現される数値を4桁程度に変換することで、モデルサイズを大幅に軽量化できます。

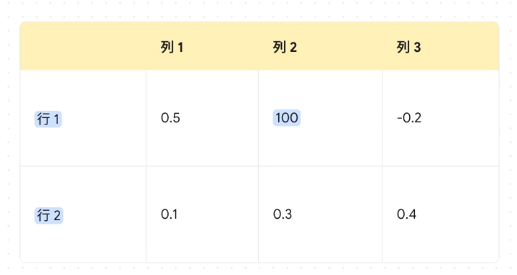

しかし、従来の量子化手法には大きな問題がありました。それが「外れ値問題」です。重み行列内に存在する極端に大きな値(外れ値)が、量子化の精度に深刻な影響を与えていたのです。標準的な量子化では重みの次元ごとに1つのスケール係数を使用するため、外れ値が存在するとスケーリングが歪み、同じスケールを共有する他のパラメータに大きな精度低下をもたらします。

特にビット幅が4以下の低精度量子化では、この問題が顕著に現れ、パープレキシティの著しい劣化につながっていました。つまり、モデルを軽量化すればするほど、性能が大幅に低下してしまうというジレンマが存在していたのです。

SINQの革新的な解決策:デュアル軸スケーリング

SINQの最も重要な革新は、行と列に別々のスケーリングベクトルを導入した二軸スケーリングです。単一のスケール係数を使用する代わりに、行方向と列方向で独立したスケール因子を設定することで、外れ値の影響を効果的に再分配します。

通常の量子化が「全員に同じサイズの制服を配る」ようなものだとすると、SINQは「身長(列方向)と体型(行方向)を見て、それぞれに合うサイズを同時に調整する」ような仕組み。だから、全員がちょうど良く動ける=モデル全体の性能を保てるのです。

この手法により、外れ値がある場合でも、数値をうまくコントロールして精度をあまり下げずに計算のボリュームを下げることができるようになりました。Sinkhorn行列正規化にインスパイアされた反復的なスケーリングプロセスを通じて、行と列の分散をバランスさせることで、量子化エラーをより小さく均等に保つことが可能になったのです。

さらに、SINQはキャリブレーション不要で動作するため、従来の手法と比較して実装が簡単で、処理速度も向上しています。すべての非キャリブレーション均一量子化ケースにおいて、最も低いWikitext-2およびC4パープレキシティを達成しており、その技術的優位性は明確です。

驚異的な性能向上:具体的な数値で見るSINQの効果

SINQの実際の性能は、数値で見ると非常に印象的です。3ビット量子化と4ビット量子化の両方で、Qwen3モデルの各サイズにおいて優れた結果を示しており、BFloat16ベースラインとのギャップを約半分に削減することに成功しています。

量子化速度についても、SINQは単一GPUにおいてRTNベースラインと同等の処理時間を実現し、すでに高速な量子化技術として知られるHQQを上回る速度を達成しています。具体的な量子化時間のデータを見ると、Qwen3-14Bモデルでは約21秒で量子化が完了するという驚異的な速さです。

メモリ削減効果も顕著で、これまで60GB以上のメモリを必要としていたAIモデルが、わずか20GB程度で動作可能となります。これは、NVIDIAのA100 80G(約290万円)やH100(約450万円)でなければ動作しなかったAIモデルを、より安価なハードウェアで実行できることを意味します。

つまり「モデルを小さくしても、頭の良さはほとんど変わらない」という次世代の量子化が現実になったのです。

ビジネスへの影響:ローカルLLMの可能性が大きく広がる

SINQの登場により、ビジネス環境でのLLM活用に大きな変化が期待されます。現在、かなりレベルが高いオープンソースのLLMやモデルが出てきていますが、レベルを上げようと思うとパラメータやサイズが大きくて、なかなか一般的な環境では実行できないという課題がありました。

しかし、SINQという手法を使うことによって、精度を下げずにレベルが高いモデルでも、メモリサイズやパラメータの処理のスピードを上げることができるため、より低コストなデバイス、例えばスマートフォンやパソコンなどでも、レベルが高いモデルを使うことができるようになりやすくなります。

これは単にコスト削減だけでなく、プライバシーとデータセキュリティの向上にも大きく貢献します。クラウドAPIに依存せず、データがデバイス上で処理されるため、医療・金融分野でのコンプライアンス要件を満たしやすくなるのです。特に医療分野では、患者データのクラウド送信を回避するための需要が高まっており、ローカルLLMの重要性はますます増しています。

実用化への道筋:対応モデルと技術的制約

SINQは、Qwen3シリーズ、Llama、DeepSeekなど幅広い大規模言語モデルでの利用に成功しており、実用性の高さが証明されています。Apache 2.0ライセンスでオープンソースとして公開され、GitHubとHugging Faceで利用可能となっているため、開発者コミュニティでの活用も期待されます。

ただし、技術的な制約も存在します。SINQは4ビット量子化でのパフォーマンスを大幅に改善する技術ですが、3ビット以下への量子化では依然として課題が残っています。例えば、Qwen3-7Bモデルで3ビット量子化を実施した場合、基準となるFP16モデルのパープレキシティが5.28であるのに対し、SINQを適用した3ビット量子化モデルでは7.85となり、一定の性能低下は避けられません。

それでも、4ビット量子化においては、従来手法と比較して圧倒的な優位性を示しており、実用的な観点から十分な性能を提供しています。

今後の展望:エッジAIとローカルLLMの未来

SINQのような革新的な量子化技術の登場により、エッジデバイスでのAI処理能力は飛躍的に向上すると考えられます。低遅延処理の実現により、Snapdragonチップセットを搭載したCopilot+ PCでは、ローカルLLMによる推論処理が50-100msの遅延で実現可能になるなど、リアルタイム性が求められるアプリケーションでの活用も期待されます。

データセンターでのコスト削減だけでなく、個人や企業が自分たちのデバイスやサーバーでレベルが高いモデルを使うことができやすくなることで、AI技術の民主化が進むでしょう。これにより、より多くの人々が高性能なAIモデルにアクセスできるようになり、イノベーションの加速が期待されます。

まとめ

SINQは、大規模言語モデルの量子化技術において画期的な進歩をもたらしました。主要なポイントを整理すると以下の通りです:

- 外れ値問題の解決:デュアル軸スケーリングにより、従来の量子化手法が抱えていた根本的な課題を克服

- 大幅なメモリ削減:60~70%のメモリ使用量削減を実現し、高性能モデルの一般デバイスでの実行を可能に

- 精度の維持:BFloat16ベースラインとのギャップを約半分に削減し、実用的な性能を確保

- 幅広い対応:Qwen3、Llama、DeepSeekなど主要なLLMで利用可能

- オープンソース:Apache 2.0ライセンスで公開され、開発者コミュニティでの活用が促進

この技術により、ローカルLLMの可能性はさらに広がり、AI技術の民主化と実用化が大きく前進することが期待されます。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 SINQとは何ですか?

SINQは、ファーウェイが開発した大規模言語モデル(LLM)の量子化技術です。モデルの精度を維持しながら、メモリ使用量を大幅に削減(60~70%)できるため、スマートフォンやパソコンなどの一般的なデバイスでも高性能なLLMを利用できるようになります。

Q2 量子化技術における外れ値問題とは何ですか?

外れ値問題とは、量子化の際に重み行列内の極端に大きな値(外れ値)が精度に悪影響を与える問題です。従来の量子化手法では、外れ値によってスケーリングが歪み、他のパラメータの精度低下を引き起こしていました。SINQはこの問題を解決するために、二軸スケーリングを導入しています。

Q3 SINQはどのようにメモリ使用量を削減するのですか?

SINQは、モデルの重みの精度を下げることでメモリ使用量を削減します。具体的には、通常16桁で表現される数値を4桁程度に変換します。SINQでは、二軸スケーリングという独自の手法を用いることで、精度を維持したまま大幅なメモリ削減を可能にしています。

Q4 SINQの二軸スケーリングとはどのような技術ですか?

SINQの二軸スケーリングは、行と列に別々のスケーリングベクトルを導入する技術です。これにより、外れ値の影響を効果的に再分配し、量子化エラーを小さく均等に保つことができます。Sinkhorn行列正規化にインスパイアされた反復的なスケーリングプロセスを通じて、行と列の分散をバランスさせます。

Q5 SINQはどのLLMで利用できますか?

SINQは、Qwen3シリーズ、Llama、DeepSeekなど、幅広い大規模言語モデルで利用可能です。Apache 2.0ライセンスでオープンソースとして公開されており、GitHubとHugging Faceで利用できます。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。