国産LLM「PLaMo 2.0」後継モデル開発へ:PFN・さくらインターネット・NICT共同プロジェクトの全貌

日本のAI技術の自立性を高める重要な動きが始まっています。2025年9月、Preferred Networks(PFN)、さくらインターネット、情報通信研究機構(NICT)の3者が、完全国産の大規模言語モデル(LLM)開発に向けた基本合意を発表しました。この協業により、2026年春を目標に「PLaMo 2.0」の後継となる新たなLLM群が誕生する予定です。

海外製LLMへの依存が高まる中、なぜ今、国産LLMの開発が重要なのでしょうか。そして、この3者連携によってどのような技術的ブレークスルーが期待できるのでしょうか。本記事では、この画期的なプロジェクトの詳細と、日本のAI戦略における意義について詳しく解説します。

目次

国産生成AIエコシステム構築の戦略的意義

今回の3者協業は、単なる技術開発にとどまらず、「日本社会と調和する国産生成AIエコシステム」の構築を目指しています。将来的な国家や社会の競争力の源泉として生成AIが位置づけられる中、完全に海外依存の状況は国家レベルでのリスクとなりかねません。

例えるなら、これは「自国の食料を自国で育てるための農業基盤づくり」のようなものです。今までは輸入に頼っていた食料(=海外製AI)を、自国で育て収穫できる体制(=国産AIエコシステム)に変えることで、いざというときの安全と安定を確保しようとしているのです。

特に重要なのは、悪意を持った利用や、意図せずにヘイトスピーチなどが発生する可能性への対策です。国産LLMであれば、日本の文化や法制度に適合した安全性の確保が可能になります。また、データの保管場所を国内に限定し、日本の法律に準拠した利用規約を設定できるため、企業にとっても安心して利用できる環境が提供されます。

各組織の役割と技術的貢献

PFNの技術開発力

Preferred Networksは、2026年春に向けて同社がフルスクラッチ開発した国産LLM「PLaMo 2.0」の後継となるLLM群をNICTと共同開発します。現在のPLaMo 2.0は31ビリオンパラメータのモデルとして提供されており、比較的コンパクトながら高い日本語性能を実現しています。

PFNの強みは、独自に構築した日本語データの活用にあります。同社は日本語を多く含む大量の合成学習データやWebデータを蓄積しており、これらのデータを活用することで、世界最高クラスの日本語性能を持つ純国産モデルの開発を目指しています。

NICTの膨大な日本語データ資産

情報通信研究機構(NICT)は、2008年から独自に収集している700億ページを超える日本語Webページという、他に類を見ない貴重なデータ資産を提供します。現在も1日あたり約2,000万ページの日本語ページを継続的に収集しており、過去15年以上にわたって蓄積されたこのデータセットは、国産LLMの学習において決定的な優位性をもたらします。

NICTはまた、共同開発するLLMをベースに、動作原理の異なるAIを組み合わせた「AI複合体」の開発も計画しています。これにより、信頼性、創造性、多様性を兼ね備えた次世代のAIシステムの実現を目指しています。

さくらインターネットのインフラ基盤

さくらインターネットは、フルマネージドの生成AI向け実行基盤「さくらの生成AIプラットフォーム」において、NICTとPFNが共同開発するLLMを提供します。これにより、クラウド基盤からアプリケーションまで完全に国内で完結した生成AIの活用が可能になります。

同社のプラットフォームでは、すでに複数の国産LLMモデルに対応しており、「gpt-oss-120b」や「llm-jp-3.1-8x13b-instruct」などのモデルが利用可能です。また、NECの「cotomi」などの国産高性能言語モデルも提供されており、日本語理解に特化した高精度な言語処理を実現しています。

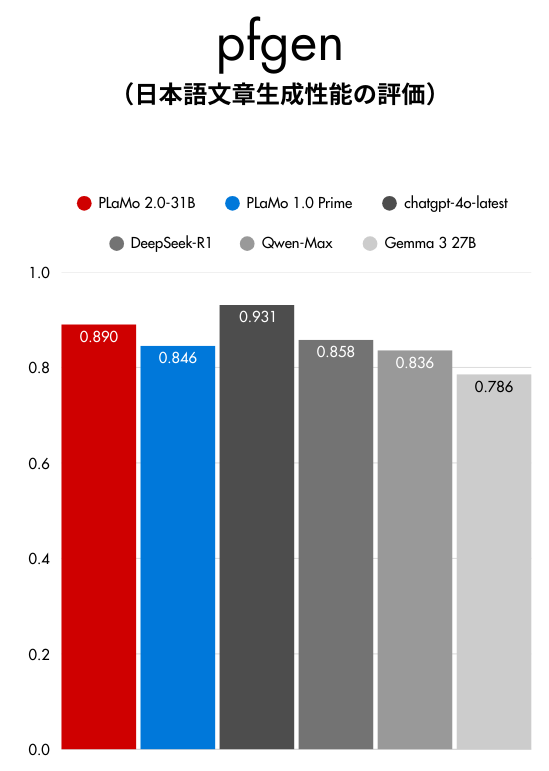

PLaMo 2.0の現在の性能と競合比較

現在提供されているPLaMo 2.0の性能は、日本語タスクにおいて注目すべき結果を示しています。各種の日本語性能評価において、Claude 2.5やGPT-4 miniと比較してもレベルが高い性能を発揮しており、特に日本語の自然な文章生成や要約タスクでは、GPT-4を超える性能を示すケースも確認されています。

310億パラメータという比較的コンパクトなモデルサイズでありながら、この高い日本語性能を実現している点は特筆すべきです。これは、日本語に特化したデータセットと学習手法の最適化によるものと考えられます。

| モデル | パラメータ数 | 日本語性能 | 特徴 |

| PLaMo 2.0 | 310億 | 高 | 国産、日本語特化 |

| GPT-4 mini | 非公開 | 中〜高 | 多言語対応 |

| Claude 2.5 | 非公開 | 中〜高 | 多言語対応 |

国産LLM活用の実践的メリット

データセキュリティとプライバシー保護

国産LLMの最大のメリットの一つは、データセキュリティとプライバシー保護における優位性です。海外製LLMと比較して、以下の点で大きなアドバンテージがあります:

- データの暗号化:国内基準に準拠した高度な暗号化技術

- アクセス制御:日本の法規制に適合した厳格なアクセス管理

- 不正アクセスの監視:24時間体制でのセキュリティ監視

- データ漏洩・改ざん防止:多層防御による包括的な保護

日本語オンリー環境での優位性

完全に日本語のLLMは、日本語オンリーの環境で使える用途であれば積極的に活用すべきです。特に、日本の文化や商習慣を踏まえた文章生成や、日本語特有の表現の理解において、海外製モデルでは対応が困難な領域で真価を発揮します。

例えるなら、これは「日本料理を作るなら、日本の包丁と調味料を使うようなもの」です。海外のツールでも料理はできますが、繊細な味や風味(=日本語のニュアンス)を再現するには、やはり日本語専用の道具(=国産LLM)が適しているのです。

ただし、多言語対応については課題も残ります。日本語以外の言語も同時に学習することでLLMの精度が向上する傾向があるため、そのバランスをどう取るかが今後の開発における重要なポイントとなります。

2026年春に向けた開発ロードマップ

2026年春のリリースに向けて、以下のような開発が進められる予定です:

技術的な改良点

現在の310億パラメータから、さらに大規模なモデルへの拡張が検討されています。NICTとの連携により、より豊富で高品質な学習データが利用可能になることで、現在のPLaMo 2.0を大幅に上回る性能の実現が期待されます。

サービス展開の拡大

さくらインターネットのプラットフォームを通じて、企業向けのAPI提供やクラウドサービスとしての展開が計画されています。これにより、中小企業でも手軽に国産LLMを活用できる環境が整備される予定です。

国産LLM活用時の注意点と課題

性能面での制約

現時点では、PLaMo 2.0のパラメータ数は31ビリオンと、最新の海外製大規模モデルと比較すると小規模です。そのため、極めて複雑な推論タスクや、専門性の高い分野での性能については、用途によっては海外製モデルに劣る可能性があります。

多言語対応の限界

日本語に特化している分、英語やその他の言語での性能は海外製モデルに及ばない可能性があります。グローバルなビジネスで多言語対応が必要な場合は、用途に応じて使い分けることが重要です。

まとめ:国産LLMエコシステムの未来

PFN、さくらインターネット、NICTによる国産LLM開発プロジェクトは、日本のAI技術の自立性確保において極めて重要な取り組みです。以下の点で大きな意義があります:

- 技術的自立性の確保:海外依存からの脱却と国産技術の競争力向上

- データセキュリティの強化:国内法準拠による安全な利用環境の提供

- 日本語性能の最適化:日本の文化・商習慣に適合した高精度な言語処理

- 包括的エコシステムの構築:データ収集からサービス提供まで一貫した国産環境

- 企業利用の促進:中小企業でも活用しやすいクラウドサービスの提供

2026年春のリリースに向けて、この国産LLMプロジェクトがどのような成果を上げるか、日本のAI業界全体が注目しています。完全に海外依存の状況から脱却し、日本独自の強みを活かしたAI技術の発展が期待されます。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 PLaMo 2.0とは何ですか?

PLaMo 2.0は、Preferred Networks(PFN)が開発した国産の大規模言語モデル(LLM)です。31ビリオンパラメータを持ち、高い日本語性能を実現しています。特に日本語の自然な文章生成や要約タスクにおいて、優れた性能を発揮することが確認されています。

Q2 国産LLMを開発するメリットは何ですか?

国産LLMの主なメリットは、データセキュリティとプライバシー保護の強化です。国内の法規制に準拠したデータの暗号化、アクセス制御、不正アクセス監視体制を構築しやすく、企業が安心して利用できる環境を提供できます。また、日本の文化や商習慣に最適化された日本語処理能力も魅力です。

Q3 PLaMo 2.0の後継モデルはいつ頃リリースされますか?

PLaMo 2.0の後継となる新しいLLM群は、Preferred Networks(PFN)、さくらインターネット、情報通信研究機構(NICT)の共同プロジェクトにより開発が進められており、2026年春のリリースが目標とされています。

Q4 さくらインターネットは国産LLM開発でどのような役割を担っていますか?

さくらインターネットは、フルマネージドの生成AI向け実行基盤「さくらの生成AIプラットフォーム」を提供し、NICTとPFNが共同開発するLLMを提供します。クラウド基盤からアプリケーションまで完全に国内で完結した生成AIの活用を可能にします。

Q5 NICTは国産LLM開発にどのように貢献していますか?

情報通信研究機構(NICT)は、2008年から収集している700億ページを超える日本語Webページという膨大なデータ資産を提供します。このデータセットは、国産LLMの学習において重要な役割を果たし、より高品質なモデル開発に貢献します。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。