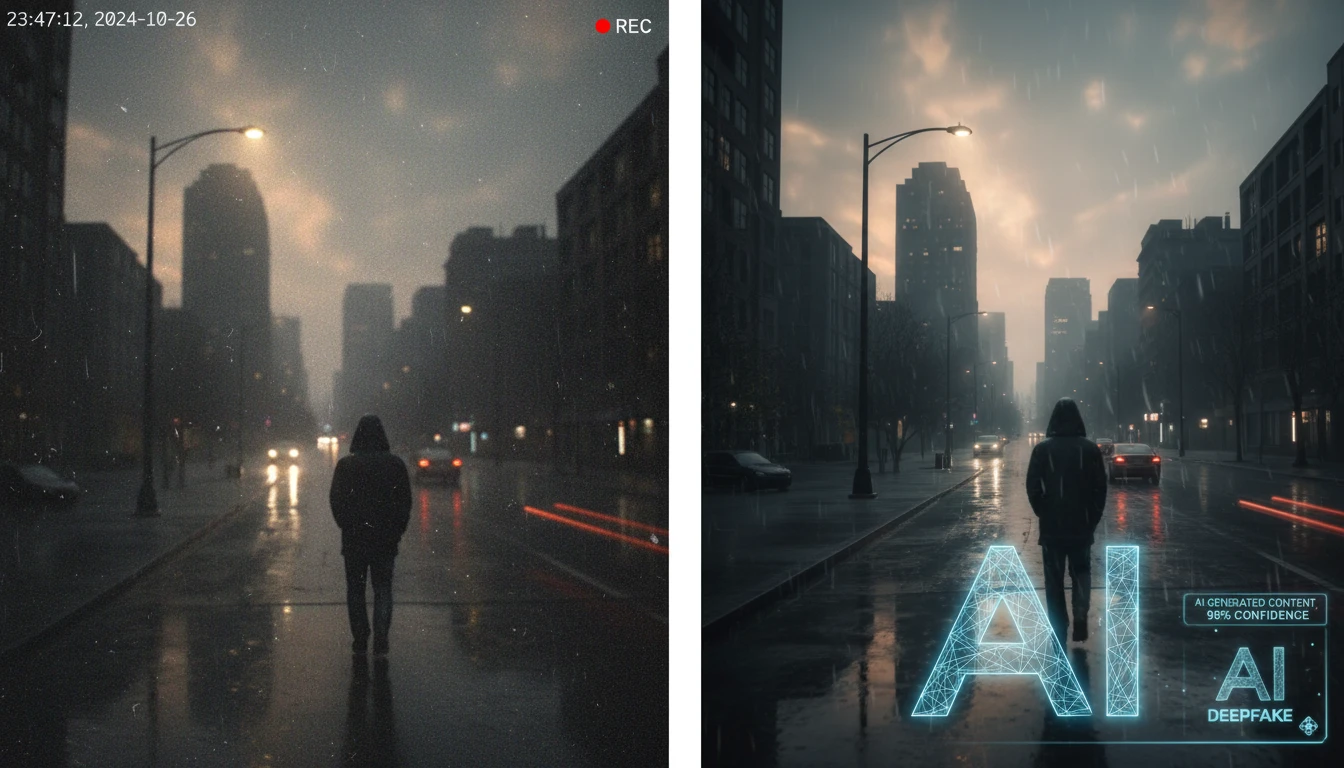

AI動画生成技術「Sora」のウォーターマーク機能が、本来の目的とは逆の悪用をされる事例が発生しています。AI生成動画を識別するためのウォーターマークが、今度は本物の動画に意図的に追加され、「これはAI生成だから信用できない」という印象操作に使われているのです。

この新たな手口は、情報の真偽を判断する私たちの基準を根本から揺るがす可能性があります。本記事では、この問題の詳細と、私たちが注意すべきポイントについて詳しく解説します。

目次

Soraウォーターマークの本来の目的と現状

OpenAIが開発したAI動画生成モデル「Sora」には、生成された動画にウォーターマーク(透かし)を自動的に埋め込む機能が搭載されています。これは、AI生成コンテンツと実際の映像を区別するための重要な識別機能として設計されました。

しかし、現在この仕組みに深刻な問題が生じています。ウォーターマークを削除するツールが出回っているだけでなく、逆に本物の動画にSoraのウォーターマークを後から追加できるツールまで登場しているのです。

これは「本物のブランドバッグからロゴを消したり、偽物に本物そっくりのロゴを貼り付けたりできる」ようなものです。どれが正規品か分からなくなり、ブランド価値が下がってしまいます。

この状況により、ウォーターマークの存在自体が信頼性の指標として機能しなくなりつつあります。むしろ、悪意ある情報操作の道具として悪用される危険性が高まっています。

「本物を偽物に見せかける」新たな悪用手口

従来のフェイク動画問題は「偽物を本物に見せかける」ことが主な脅威でした。しかし、現在発生している問題は、その逆の「本物を偽物に見せかける」という新たな手口です。

具体的な悪用パターンとして、以下のようなケースが考えられます:

- 証拠隠滅の手段:不都合な真実を記録した本物の動画に、後からSoraのウォーターマークを追加し、「これはAI生成の偽物だ」と主張する

- 情報操作:本物の動画を拡散した後、ウォーターマーク付きバージョンを追加拡散し、「実は偽物でした」と印象操作を行う

- 責任逃れ:問題となった動画について、「AI生成だから責任はない」という言い訳を可能にする

これらの手口は、情報の信頼性を根本から破壊する可能性があります。なぜなら、ウォーターマークという「信頼の証」が、逆に「疑いの種」として機能してしまうからです。

例えるなら、これは「防犯カメラの映像に“合成です”という偽ラベルを貼って、犯罪の証拠を揉み消す」ようなものです。本来“真実を守るための印”が、逆に“真実を隠す道具”にされてしまっています。

情報拡散における複雑な問題構造

この問題をさらに複雑にしているのは、インターネット上での情報拡散の特性です。一つの動画が拡散される過程で、複数のバージョンが同時に流通することがあります。

例えば、以下のような状況が発生する可能性があります:

- オリジナルの本物動画(ウォーターマークなし)

- 意図的にウォーターマークを追加された同じ動画

- さらに別の加工が施されたバージョン

この状況では、「どれがオリジナルなのか」「どのバージョンが信頼できるのか」を判断することが極めて困難になります。悪意ある者は、「ウォーターマークのない方が偽物で、ウォーターマーク付きが本物のAI生成動画だ」と主張することも可能になってしまいます。

技術的な対策の限界と課題

現在のウォーターマーク技術には、根本的な技術的限界があります。デジタルウォーターマークは、基本的に「後から追加可能」な技術であるため、悪用を完全に防ぐことは困難です。

2025年7月時点では、以下のような技術的課題が存在しています:

| 課題 | 詳細 | 影響 |

| ウォーターマーク削除ツール | AI技術を使ってウォーターマークを除去 | AI生成動画の偽装が容易に |

| 偽ウォーターマーク追加ツール | 本物動画にSoraのウォーターマークを追加 | 本物動画の信頼性を損なう |

| 検証技術の遅れ | ウォーターマークの真正性を確認する手段が限定的 | 一般ユーザーによる判断が困難 |

これらの技術的課題により、ウォーターマークだけに依存した真偽判定は、もはや信頼できない状況となっています。

私たちが取るべき対策と心構え

この複雑な状況において、私たちはどのような対策を取るべきでしょうか。以下のポイントが重要と考えられます:

1. 複数の情報源による検証

単一の動画や情報源だけでなく、複数の独立した情報源から同様の内容が報告されているかを確認することが重要です。特に重要な情報については、信頼できるメディアや公式発表との照合を行いましょう。

2. ウォーターマークに過度に依存しない

ウォーターマークの有無だけで真偽を判断するのではなく、動画の内容、撮影状況、公開経緯なども含めて総合的に判断する必要があります。

3. 情報の出所と経緯の確認

動画がどこから、どのような経緯で公開されたのかを可能な限り追跡し、信頼できるソースからの情報かどうかを確認しましょう。

4. 専門機関による検証結果の活用

重要な情報については、ファクトチェック機関や専門機関による検証結果を参考にすることが有効です。

今後の展望と社会的な対応の必要性

この問題は、技術的な解決策だけでは対処が困難な、社会全体で取り組むべき課題です。今後は以下のような対応が必要になると考えられます:

- 法的枠組みの整備:悪意あるウォーターマーク操作に対する法的規制の検討

- プラットフォーム側の対策:SNSや動画共有サイトでの検証機能の強化

- メディアリテラシー教育:一般市民の情報判断能力向上のための教育

- 技術標準の確立:より信頼性の高い真正性証明技術の開発と標準化

特に重要なのは、私たち一人一人が「完璧な判定技術は存在しない」という前提で情報と向き合うことです。技術的な解決策を待つだけでなく、批判的思考と慎重な情報評価の習慣を身につけることが求められています。

まとめ

Soraウォーターマークの悪用問題は、AI技術の発展に伴う新たな情報操作の手口として深刻な脅威となっています。主要なポイントを以下にまとめます:

- 新たな悪用手口:本物動画にAIウォーターマークを追加し、偽物として印象操作する手法が登場

- 技術的限界:現在のウォーターマーク技術では、悪用を完全に防ぐことは困難

- 複雑な拡散構造:複数バージョンの動画が同時流通し、真偽判定がより困難に

- 総合的判断の重要性:ウォーターマークだけでなく、複数の要素を総合して情報の信頼性を評価する必要

- 社会的対応の必要性:技術的解決策だけでなく、法的整備やメディアリテラシー向上が不可欠

この問題への対処には、技術開発者、プラットフォーム運営者、法制度、そして私たち一般ユーザーの協力が不可欠です。情報の真偽を見極める能力を高めながら、より信頼できる情報環境の構築に向けて取り組んでいく必要があります。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 Soraのウォーターマークは、なぜ悪用されるようになったのですか?

本来、AI生成動画を識別するためにSoraのウォーターマークが導入されましたが、ウォーターマークを削除したり、逆に本物の動画に追加したりするツールが登場したため、信頼性が低下し悪用されるようになりました。

Q2 本物の動画にSoraのウォーターマークを追加する悪用手口とは、具体的にどのようなものですか?

例えば、不都合な真実を記録した動画にウォーターマークを加え、「AI生成の偽物」と主張したり、動画を拡散後にウォーターマーク付きのバージョンを拡散して印象操作をしたりする手口があります。

Q3 Soraのウォーターマークの悪用に対して、個人でできる対策はありますか?

単一の情報源に頼らず、複数の情報源で検証したり、ウォーターマークの有無だけで判断せず動画の内容や出所を確認したりすることが重要です。また、ファクトチェック機関の検証結果も参考にしましょう。

Q4 ウォーターマーク以外に、AI生成動画と本物の動画を見分ける方法はありますか?

動画の内容、撮影状況、公開経緯などを総合的に判断することが重要です。ウォーターマークだけに頼らず、複数の情報源を照らし合わせるなど、多角的な視点を持つように心がけましょう。

Q5 Soraのウォーターマーク悪用問題に対して、社会全体ではどのような対策が必要ですか?

法的枠組みの整備(悪意あるウォーターマーク操作への規制)、プラットフォーム側の対策(検証機能の強化)、メディアリテラシー教育、信頼性の高い真正性証明技術の開発と標準化などが考えられます。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。