Meta「Omnilingual ASR」が音声認識を革命化:1600以上の言語対応でWhisperを圧倒する性能を実現

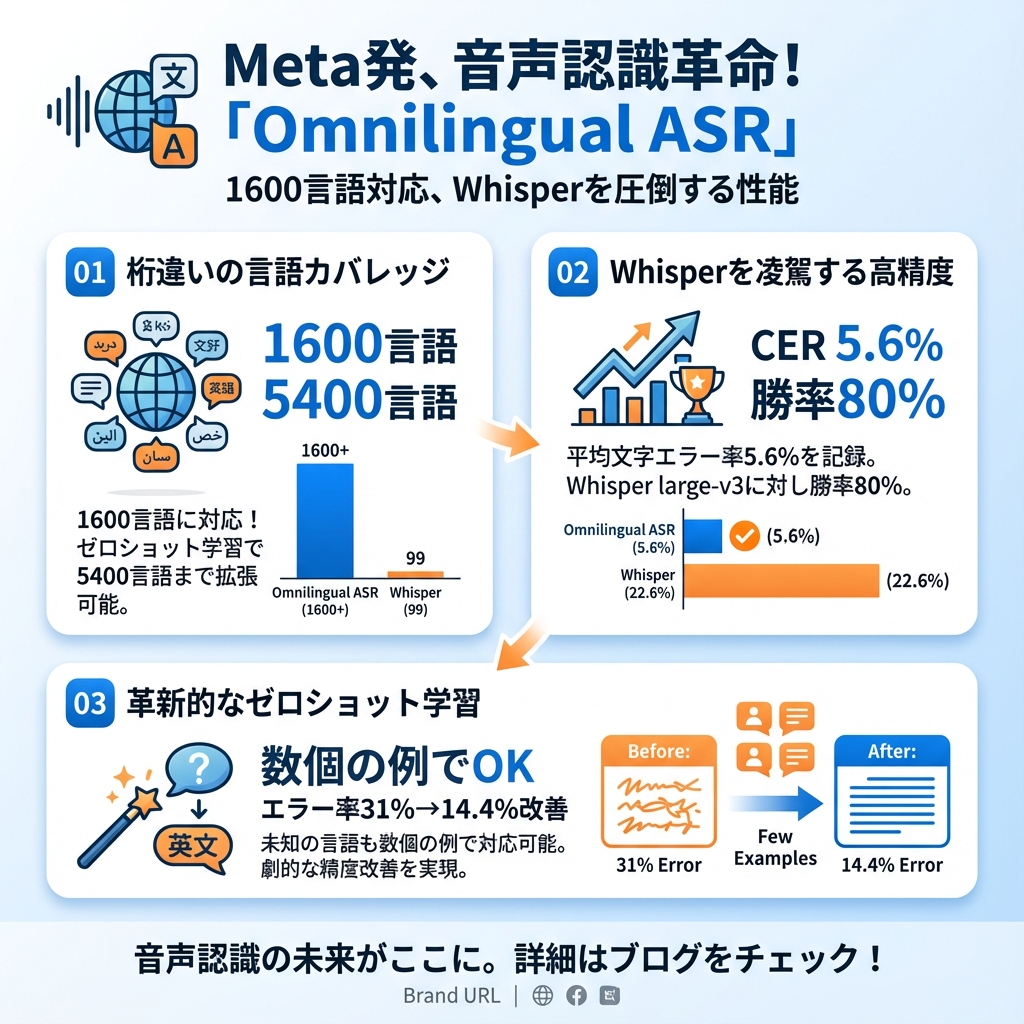

音声認識技術の分野で、Metaが画期的な発表を行いました。新たにオープンソースで公開された「Omnilingual ASR」は、なんと1600以上の言語に対応し、さらにゼロショット学習により5400以上の言語まで拡張可能な、史上最大規模の多言語音声認識システムです。

世界には7000以上の言語が存在するとされていますが、これまでの音声認識システムでは、そのうちのごく一部しかサポートされていませんでした。OpenAIのWhisperでさえ99言語の対応に留まっている中、Omnilingual ASRは桁違いの言語カバレッジを実現し、特に500以上の「これまで一度も音声認識システムでサポートされたことのない言語」を含んでいることが注目されます。

目次

従来システムとの圧倒的な性能差

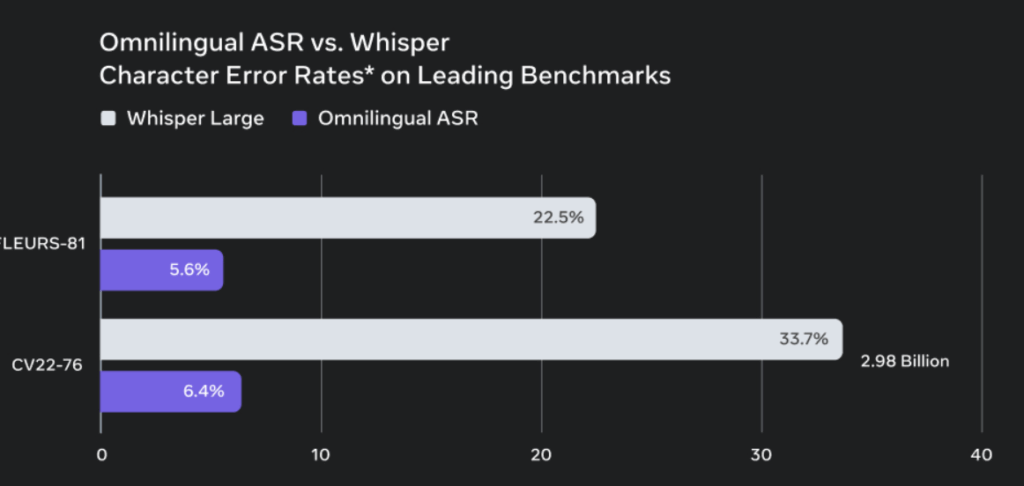

Omnilingual ASRの性能は、既存の音声認識システムを大きく上回っています。FLEURS-81テストセットでの比較では、平均文字エラー率(CER)が5.6%を記録し、Whisper large-v3の22.6%を大幅に下回りました。さらに驚くべきことに、81言語中65言語でWhisperを上回る性能を示し、勝率80%という圧倒的な結果を残しています。

特に注目すべきは、コンパクトな300Mパラメータモデルでさえ、はるかに大きなWhisper large-v3モデルを複数のベンチマークで上回ったことです。これは、Omnilingual ASRのアーキテクチャ設計と学習効率の優秀さを物語っています。

革新的なゼロショット学習機能

Omnilingual ASRの最も革新的な機能は、ゼロショット学習による未知言語への対応です。この機能により、システムが学習していない言語でも、わずか数個の音声・テキストペアの例を提供するだけで、その言語の音声認識が可能になります。

実際のテストでは、32の未学習言語において、10個のコンテキスト例を提供することで、平均文字エラー率を31%から14.4%まで大幅に改善することに成功しました。この機能により、理論上は5400以上の言語への対応が可能となり、「文字体系が確立されているほぼすべての話し言葉」をカバーできる可能性があります。

7Bパラメータの巨大エンコーダーが支える技術基盤

Omnilingual ASRの高性能を支えているのは、7Bパラメータまでスケールアップされた自己教師あり学習エンコーダーです。このエンコーダーは、wav2vec 2.0をベースとして大幅に拡張されており、1600以上の言語にわたる堅牢な音声表現を学習しています。

システムのアーキテクチャは、この巨大な音声エンコーダーと、1.2Bパラメータの大規模言語モデル(LLM)にインスパイアされたTransformerデコーダーを組み合わせたハイブリッド構造となっています。エンコーダーが音響的な知識を処理し、デコーダーが言語的な構造化を担当することで、効率的かつ高精度な音声認識を実現しています。

430万時間の多様なデータセットで学習

Omnilingual ASRは、430万時間という膨大な音声データで学習されています。このデータセットは、既存の公開データセットに加えて、コミュニティとの協力により収集された音声録音を含んでおり、特に350以上の低リソース言語をカバーしています。

データ収集においては、地域組織との有償パートナーシップを通じて、ネイティブスピーカーを募集・報酬を支払うという倫理的なアプローチが採用されました。これにより、従来のシステムでは対応が困難だった、デジタル化されていない言語や方言も含む、真に多様なデータセットの構築が実現されています。

実用性を重視したモデルファミリー

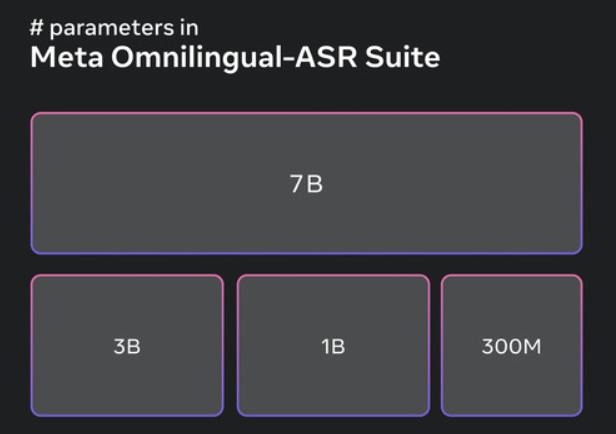

Omnilingual ASRは、単一のモデルではなく、用途に応じて選択できるモデルファミリーとして提供されています:

- 自己教師あり学習モデル:300M、1B、3B、7Bパラメータの4種類で、様々な下流タスクに対応

- CTCベースASRモデル:基本的な音声認識アプリケーション向け

- LLM-ASRモデル:最高精度を求める用途向け

- ゼロショットLLM-ASRモデル:未知言語への対応が可能

最小の300Mモデルは低電力デバイスでもリアルタイム動作が可能で、最大の7Bモデルは最高精度を提供します。7Bモデルの推論には約17GBのGPUメモリが必要ですが、小型モデルでも十分実用的な性能を発揮します。

言語の多様性と社会的インパクト

世界の言語分布を見ると、興味深い事実が浮かび上がります。7000以上存在する言語のうち、82%以上がわずか23億人のみによって使用されており、総数の半分は1万人未満の話者しか持たないマイナー言語です。100万人以上の話者を持つ言語は、全体のわずか7.2%に過ぎません。

このような状況において、Omnilingual ASRは単なる技術的進歩を超えた社会的意義を持っています。これまで音声認識技術から取り残されてきた言語コミュニティが、自分たちの言語でデジタル社会により公平にアクセスできる基盤を築くものです。

コミュニティ主導の言語保存への貢献

Omnilingual ASRの開発において特筆すべきは、コミュニティ中心のアプローチです。データ収集プロセスでは、地域のNGOや非営利団体と協力し、言語話者に適切な報酬を支払いながら音声データを収集しました。

このアプローチにより、多くの参加者が「将来の世代のために自分たちの言語を記録・保存する」という使命感を持って協力してくれたと報告されています。これは、技術開発が単なる外部からの押し付けではなく、コミュニティ自身の言語保存努力と連携したものであることを示しています。

Apache 2.0ライセンスによる完全オープンソース化

Omnilingual ASRは、Apache 2.0ライセンスの下で完全にオープンソース化されています。これは、過去のMetaのLlamaシリーズが制限的なライセンスを採用していたのとは対照的で、研究者、開発者、企業が自由に使用、修正、商用展開できることを意味します。

GitHubとHugging Faceで公開されており、事前構築された推論パイプライン、言語コード条件付けによる精度向上機能、そして包括的なドキュメントが提供されています。これにより、技術的な専門知識が限られたコミュニティでも、比較的容易にシステムを導入・活用できる環境が整っています。

ノイズ耐性と実用性の確保

実際の使用環境を考慮し、Omnilingual ASRは背景ノイズに対する堅牢性も重視して設計されています。SI-SDRレベルでの測定では、最も厳しい1%のノイズ条件下でも性能は安定しており、一般的な中程度のノイズ環境では良好な堅牢性を示しています。

重要なことに、この堅牢性は高リソース言語と低リソース言語の両方で一貫して維持されており、多様で自然なデータ収集の効果が実証されています。これにより、学校や診療所などの実際の使用環境でも実用的な性能を発揮できます。

今後の展望と課題

Omnilingual ASRは画期的な成果を上げていますが、開発チームも限界を認識しています。最も重要な制約は、ゼロショット性能が完全に学習されたシステムの精度には及ばないことです。ゼロショット機能は「アクセスの提供」であり「完璧さの提供」ではないと位置づけられています。

また、言語コード条件付けについても興味深いトレードオフが発見されています。言語コードを事前に提供すると精度は向上しますが、常に言語コードを期待するように学習されたモデルは、推論時にコードが提供されないと性能が大幅に低下します。最適なバランスとして、学習時に50%の確率で言語コードを提供する手法が採用されています。

音声技術の民主化への第一歩

Omnilingual ASRの登場は、音声認識技術の「民主化」における重要な転換点と言えるでしょう。これまで一部の高リソース言語に限定されていた高精度音声認識が、世界中の多様な言語コミュニティにとって手の届く技術となりました。

特に注目すべきは、このシステムが「静的な言語カバレッジ」から「拡張可能なフレームワーク」へのパラダイムシフトを実現していることです。コミュニティ自身が主導権を持って、自分たちの言語をデジタル世界に導入できる道筋が開かれたのです。

今後、このような技術が同時通訳システムや多言語対応の音声アシスタントなどに発展していく可能性も十分に考えられます。Omnilingual ASRは、真にグローバルで包括的な音声技術エコシステムの構築に向けた、重要な第一歩となるでしょう。

まとめ

MetaのOmnilingual ASRは、以下の点で音声認識技術に革命をもたらしています:

- 圧倒的な言語カバレッジ:1600以上の言語に対応し、ゼロショット学習で5400以上まで拡張可能

- 優秀な性能:Whisperを大幅に上回る精度を、より少ないデータで実現

- 実用的な設計:300Mから7Bまでの多様なモデルサイズと優れたノイズ耐性

- 完全オープンソース:Apache 2.0ライセンスによる自由な利用・改変・商用展開

- 社会的インパクト:言語の多様性保護とデジタル格差の解消への貢献

この技術により、これまで音声認識の恩恵を受けられなかった世界中の言語コミュニティが、自分たちの言語でデジタル技術を活用できる未来が現実のものとなりました。Omnilingual ASRは、技術の進歩が真の意味で人類全体の利益となる可能性を示した、画期的な成果と言えるでしょう。

参考リンク

本記事の作成にあたり、以下の情報源を参考にしています:

- Meta Omnilingual ASR デモサイト

- Meta AI Research – Omnilingual ASR論文

- Hugging Face – Omnilingual ASR Transcriptions

- arXiv – Omnilingual ASR技術論文

- GitHub – Omnilingual ASRリポジトリ

よくある質問(FAQ)

Q1 MetaのOmnilingual ASRとは何ですか?

Metaが開発したオープンソースの多言語音声認識システムです。1600以上の言語に対応し、ゼロショット学習により5400以上の言語まで拡張できます。OpenAIのWhisperよりも多くの言語をカバーし、高い認識精度を誇ります。

Q2 Omnilingual ASRは、OpenAIのWhisperと比べて何が優れていますか?

Omnilingual ASRは、対応言語数がWhisperの99言語に対して1600言語以上と圧倒的に多いです。また、FLEURS-81テストセットでの平均文字エラー率(CER)がWhisper large-v3の22.6%に対し、5.6%と大幅に低く、認識精度も優れています。

Q3 Omnilingual ASRのゼロショット学習とはどのような機能ですか?

ゼロショット学習とは、システムが学習していない言語でも、わずかな音声とテキストの例(数個程度)を提供するだけで、その言語の音声認識を可能にする機能です。これにより、理論上は5400以上の言語に対応できる可能性があります。

Q4 Omnilingual ASRはどのように利用できますか?

Omnilingual ASRはApache 2.0ライセンスでオープンソース化されており、GitHubとHugging Faceで公開されています。研究者、開発者、企業は自由に使用、修正、商用展開できます。事前構築された推論パイプラインやドキュメントも提供されています。

Q5 Omnilingual ASRは、どのような社会的意義がありますか?

これまで音声認識技術から取り残されてきた言語コミュニティが、自分たちの言語でデジタル社会にアクセスできるようになる基盤を築きます。言語の多様性を保護し、デジタル格差の解消に貢献することが期待されます。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。