VibeThinker-1.5B:わずか100万円で訓練した15億パラメータAIが、Gemini 2.5 Flashレベルの推論性能を実現

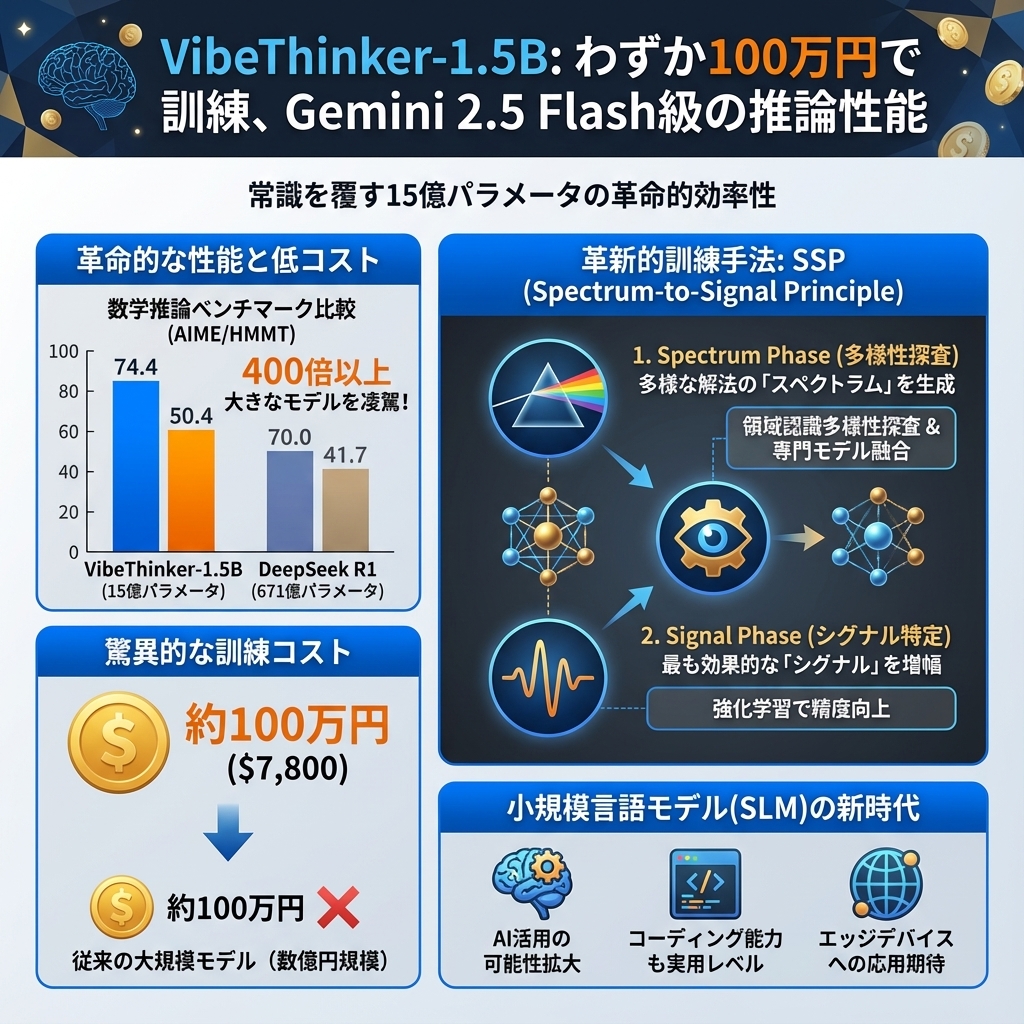

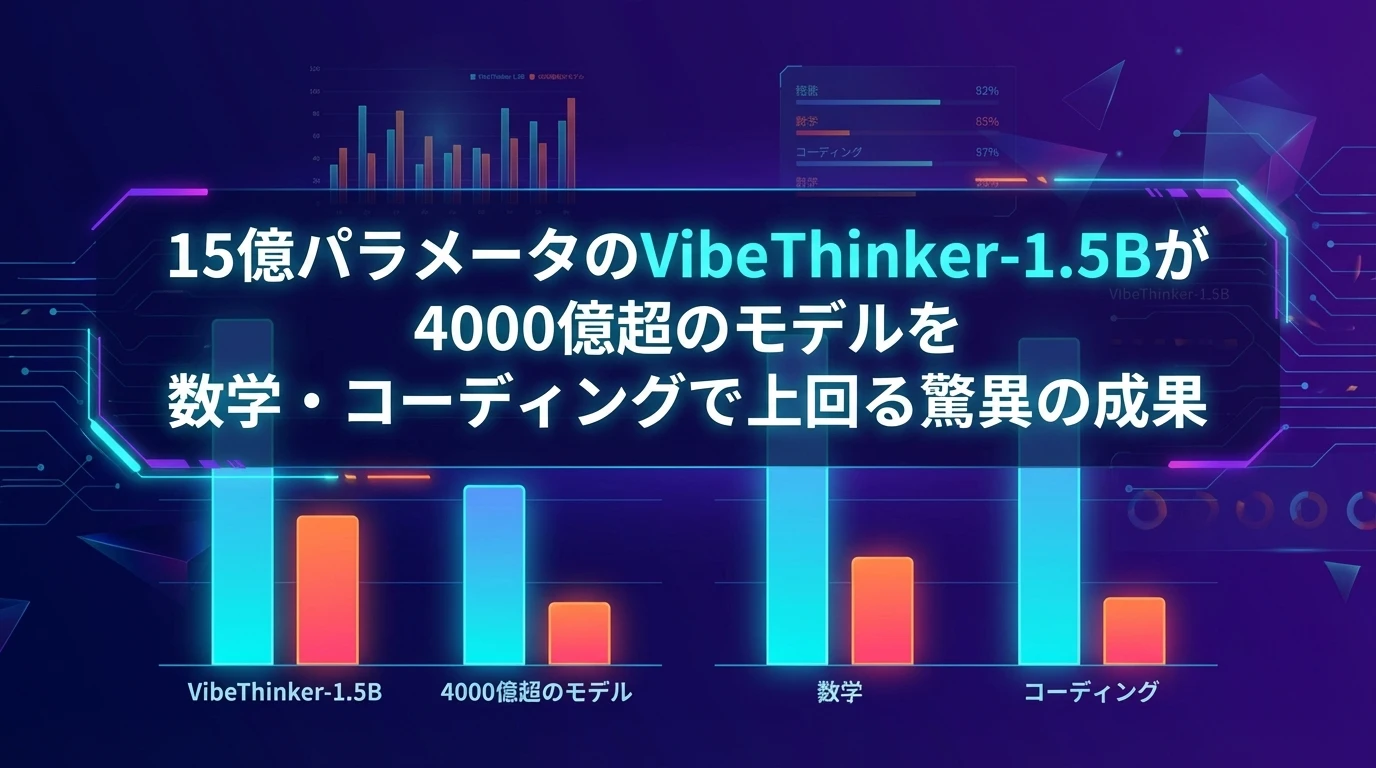

AI業界では「大きいほど優秀」という常識が支配的でした。DeepSeek R1の671億パラメータ、Kimi K2の1兆パラメータといった巨大モデルが注目を集める中、中国のWeibo社が発表したVibeThinker-1.5Bは、この常識を根底から覆す革新的なモデルです。わずか15億パラメータでありながら、数学とコーディングの推論タスクにおいて、400倍以上大きなモデルを上回る性能を実現しています。

最も驚くべきは、その訓練コストです。わずか7,800ドル(約100万円)という低コストで、Gemini 2.5 Flashレベルの推論能力を獲得しました。これは従来の大規模モデル開発に必要な数億円規模の投資と比較して、まさに革命的な効率性を示しています。

この記事では、VibeThinker-1.5Bがどのような技術革新によってこの驚異的な性能を実現したのか、そして小規模言語モデル(SLM)が切り開く新たなAI活用の可能性について詳しく解説します。

目次

VibeThinker-1.5Bの驚異的な性能実績

VibeThinker-1.5Bの性能は、単なる理論値ではありません。実際のベンチマークテストにおいて、以下のような具体的な成果を上げています。

数学推論における圧倒的な成果

最も注目すべきは、高校レベルの数学競技における成績です。AIME(American Invitational Mathematics Examination)やHMMT(Harvard-MIT Mathematics Tournament)といった権威ある数学コンテストのベンチマークにおいて、VibeThinker-1.5Bは以下の成績を記録しました:

| ベンチマーク | VibeThinker-1.5B | DeepSeek R1(671B) | パラメータ比 |

| AIME25 | 74.4 | 70.0 | 1/447 |

| HMMT25 | 50.4 | 41.7 | 1/447 |

これらの数値が示すのは、単なる僅差での勝利ではありません。VibeThinker-1.5Bは、400倍以上のパラメータを持つDeepSeek R1を数学ベンチマークで上回っているのです。特にHMMT25では、50.4対41.7という大幅な差をつけています。

コーディング能力での実力発揮

数学だけでなく、プログラミング能力においても優秀な成績を収めています。LiveCodeBench V6という実践的なコーディングベンチマークでは、51.1というスコアを記録し、Claude Opus 4(56.6)と肉薄しりました。

この成果は、VibeThinker-1.5Bが単なる数学特化モデルではなく、論理的思考を要する幅広いタスクに対応できることを示しています。実際のソフトウェア開発現場で求められるアルゴリズム設計やデバッグ能力において、実用的なレベルに達していると考えられます。

革新的な「Spectrum-to-Signal Principle」とは

VibeThinker-1.5Bの驚異的な性能を支えているのが、開発チームが独自に考案した「Spectrum-to-Signal Principle(SSP)」という訓練フレームワークです。この手法は、従来のAI訓練の常識を覆す画期的なアプローチです。

従来手法の限界と新たなアプローチ

従来のAI訓練では、教師あり学習(SFT)で単一の最適解を目指し、その後強化学習(RL)で精度を向上させるという流れが一般的でした。しかし、この手法には根本的な問題がありました。SFTの段階で解答の多様性が制限されてしまうため、RLフェーズでの改善余地が狭まってしまうのです。

SSPは、この問題を解決するために訓練プロセスを2つの明確に異なる段階に分離しました:

- Spectrum Phase(スペクトラム段階):SFTにおいて、単一の正解を目指すのではなく、多様な解法の「スペクトラム」を生成することに重点を置きます

- Signal Phase(シグナル段階):RLにおいて、多様な解法の中から最も効果的な「シグナル」を特定し、増幅します

多様性探索蒸留の技術的詳細

Spectrum Phaseでは、「Two-Stage Diversity-Exploring Distillation」という手法を採用しています。これは以下の2段階で構成されます:

1. Domain-Aware Diversity Probing(領域認識多様性探査)

数学の知識領域を代数、幾何、微積分、統計学の4つのサブドメインに分割し、各領域で最も多様性の高い専門モデルを特定します。多様性はPass@K指標(K回の試行で正解する確率)で測定されます。

2. Expert Model Fusion(専門モデル融合)

特定された専門モデルを重み付き線形結合により統合し、多様性を最大化した統一SFTモデルを構築します。この過程で、各サブドメインの能力を均等に統合することで、幅広い問題に対応できる基盤を作ります。

MaxEnt-Guided Policy Optimization(MGPO)

Signal Phaseでは、MGPOという独自の強化学習手法を使用します。この手法の特徴は、モデルが高い不確実性を示す問題に対して動的に訓練の重点を置くことです。

具体的には、エントロピー偏差正則化という技術を用いて、理想的な最大エントロピー状態からの偏差を測定し、この偏差に基づいて学習信号を調整します。これにより、モデルは最も学習効果の高い問題に集中的に取り組むことができます。

小規模言語モデルが切り開く新たな可能性

VibeThinker-1.5Bの成功は、AI業界全体に大きな示唆を与えています。これまで「大きければ大きいほど良い」とされてきたパラダイムに対して、効率性と特化性の重要性を示したのです。

コスト効率性の革命

最も重要な変化は、AI開発・運用コストの劇的な削減です。VibeThinker-1.5Bの訓練には、NVIDIA H800 GPUで約3,900時間、総額7,800ドルしかかかりませんでした。これは、大規模モデルの訓練に必要な数百万ドルと比較して、100分の1以下のコストです。

この低コストは、以下のような実用的なメリットをもたらします:

- 中小企業でのAI導入が現実的に:これまで大企業のみが可能だった高性能AI開発が、限られた予算でも実現可能になります

- 研究機関での実験コスト削減:大学や研究所でも、実用的なAIモデルの開発・実験が行えるようになります

- 個人開発者の参入障壁低下:個人レベルでも、専門分野に特化した高性能AIの開発が可能になります

エッジデバイスでの実用化

15億パラメータという軽量性は、エッジデバイスでの実行を可能にします。これにより、以下のような新たな応用分野が開拓されます:

- スマートフォンでの高度な数学計算支援:インターネット接続なしでも、複雑な数学問題の解法を提供

- IoTデバイスでの論理的判断:製造業の品質管理や農業の最適化判断をリアルタイムで実行

- プライバシー保護型AI:機密データを外部に送信することなく、高度な分析処理を実行

専門分野特化の戦略的価値

VibeThinker-1.5Bは、汎用性を犠牲にして数学とコーディングに特化することで、これらの分野では大規模モデルを上回る性能を実現しました。この戦略は、企業のAI活用において重要な示唆を与えています。

例えば、金融機関であれば財務分析に特化したSLM、医療機関であれば診断支援に特化したSLMを開発することで、汎用モデルよりも高い精度と効率性を実現できる可能性があります。

実践的な活用方法と導入手順

VibeThinker-1.5Bは、Hugging Faceでオープンソースとして公開されており、誰でも利用できます。ここでは、実際の導入方法と活用事例を詳しく解説します。

技術要件と環境構築

VibeThinker-1.5Bの実行には、以下の環境が必要です:

- 必須要件:transformers>=4.54.0

- 推奨環境:vLLM==0.10.1またはSGLang>=0.4.9.post6(高速推論のため)

- ハードウェア:8GB以上のVRAMを持つGPU(RTX 3080レベル以上を推奨)

具体的な活用シーン

教育分野での活用

数学教育において、VibeThinker-1.5Bは学生の問題解決プロセスを支援する強力なツールとなります。単に答えを提供するだけでなく、多様な解法アプローチを示すことで、学生の理解を深めることができます。

ソフトウェア開発での活用

コーディング支援において、アルゴリズムの最適化やデバッグ作業を効率化できます。特に競技プログラミングや技術面接の準備において、実践的な価値を発揮します。

研究開発での活用

数学的モデリングが必要な研究分野において、仮説検証や計算プロセスの自動化に活用できます。物理学、工学、経済学などの分野で特に有効です。

制限事項と注意点

VibeThinker-1.5Bは優秀なモデルですが、いくつかの重要な制限事項があります。これらを理解した上で適切に活用することが重要です。

適用範囲の限定

開発チームは明確に「競技スタイルの数学とアルゴリズムコーディング問題での使用を推奨し、他のタスクでの使用は推奨しない」と述べています。これは、モデルが特定分野に最適化されているためです。

具体的には、以下のような用途には適していません:

- 一般的な会話や質問応答:日常会話や幅広い知識を要する質問には不向き

- 創作活動:小説や詩の執筆、創造的なコンテンツ生成には限界がある

- 多言語対応:英語での質問が最も効果的で、他言語では性能が低下する可能性

ハルシネーション(幻覚)の可能性

小規模モデル特有の課題として、事実と異なる情報を生成する可能性があります。特に、訓練データに含まれていない最新の情報や、専門分野外の知識については注意が必要です。

この問題を軽減するためには:

- 出力の検証:重要な計算結果は必ず別の方法で確認する

- 適用範囲の遵守:推奨される数学・コーディング分野での使用に限定する

- 人間の監督:最終的な判断は人間が行う

AI業界への長期的インパクト

VibeThinker-1.5Bの成功は、AI業界全体の方向性に大きな影響を与える可能性があります。これまでの「スケーリング法則」に対する新たな視点を提供しているからです。

効率性重視のパラダイムシフト

従来のAI開発では、「より多くのパラメータ、より多くのデータ、より多くの計算資源」が性能向上の鍵とされてきました。しかし、VibeThinker-1.5Bは、アルゴリズムの革新によって、少ないリソースでも高い性能を実現できることを実証しました。

この変化は、以下のような業界全体の動向を加速させる可能性があります:

- 環境負荷の軽減:大規模モデルの訓練・運用に伴うエネルギー消費を大幅に削減

- AI民主化の促進:高性能AIへのアクセス障壁を下げ、より多くの組織・個人が活用可能に

- 専門特化モデルの普及:汎用性よりも特定分野での卓越性を重視する開発戦略の拡大

企業のAI戦略への示唆

VibeThinker-1.5Bの成功は、企業のAI導入戦略にも重要な示唆を与えています。巨大な汎用モデルに依存するのではなく、自社の特定業務に最適化された小規模モデルを開発・運用することで、より高いROI(投資収益率)を実現できる可能性があります。

例えば:

- 製造業:品質管理や予知保全に特化したSLMの開発

- 金融業:リスク分析や不正検知に特化したSLMの活用

- 医療業:診断支援や薬物相互作用チェックに特化したSLMの導入

まとめ

VibeThinker-1.5Bは、AI業界における「小さくても強い」モデルの可能性を実証した画期的な成果です。わずか100万円の訓練コストで、数百倍大きなモデルを上回る推論性能を実現したことは、AI開発の新たな方向性を示しています。

この記事で解説した主要なポイントを整理すると:

- 驚異的なコストパフォーマンス:7,800ドルの訓練コストで、400倍大きなDeepSeek R1を数学ベンチマークで上回る性能を実現

- 革新的な訓練手法:Spectrum-to-Signal Principleにより、多様性の探索と最適解の特定を効果的に分離

- 実用的な活用可能性:教育、研究、ソフトウェア開発など、数学・コーディング分野での具体的な応用価値

- 業界への長期的影響:効率性重視のパラダイムシフトと、専門特化モデルの普及促進

VibeThinker-1.5Bの成功は、AI技術の民主化と持続可能な発展に向けた重要な一歩です。今後、この技術をベースとした更なる革新が期待され、より多くの組織や個人が高性能AIの恩恵を受けられる未来が近づいています。

参考リンク

本記事の作成にあたり、以下の情報源を参考にしています:

- VibeThinker-1.5B – Hugging Face

- Tiny Model, Big Logic: Diversity-Driven Optimization Elicits Large-Model Reasoning Ability in VibeThinker-1.5B (arXiv)

- Small Language Models for Your Niche Needs in 2025

- AI: What are SLMs and are they good for businesses? – World Economic Forum

よくある質問(FAQ)

Q1 VibeThinker-1.5Bとは何ですか?

VibeThinker-1.5Bは、Weibo社が開発した15億パラメータの小規模言語モデル(SLM)です。従来のAIモデルとは異なり、少ないパラメータ数と低コスト(約100万円)で、大規模モデルを上回る数学とコーディングの推論性能を実現しています。特に、数学競技におけるベンチマークテストで優れた成績を収めています。

Q2 VibeThinker-1.5Bはどのようなタスクに適していますか?

VibeThinker-1.5Bは、特に競技スタイルの数学とアルゴリズムコーディング問題に最適化されています。高校レベルの数学の問題解決や、ソフトウェア開発におけるアルゴリズム設計、デバッグ作業などで高い性能を発揮します。一般的な会話や質問応答、創作活動には不向きです。

Q3 VibeThinker-1.5Bの訓練コストはどのくらいですか?

VibeThinker-1.5Bの訓練コストは非常に低く、NVIDIA H800 GPUで約3,900時間、総額7,800ドル(約100万円)です。これは、大規模言語モデルの訓練に必要な数百万ドルと比較して、100分の1以下のコストであり、中小企業や研究機関、個人開発者でも利用しやすい点が特徴です。

Q4 VibeThinker-1.5Bを利用するために必要な環境は何ですか?

VibeThinker-1.5Bを実行するには、transformers>=4.54.0が必要です。高速推論のためにはvLLM==0.10.1またはSGLang>=0.4.9.post6が推奨されます。ハードウェアとしては、8GB以上のVRAMを持つGPU(RTX 3080レベル以上を推奨)が必要です。

Q5 VibeThinker-1.5Bの性能を支える「Spectrum-to-Signal Principle(SSP)」とは何ですか?

Spectrum-to-Signal Principle(SSP)は、VibeThinker-1.5Bの訓練に用いられる革新的なフレームワークです。SFT(教師あり学習)で多様な解法(スペクトラム)を生成し、RL(強化学習)で最も効果的な解法(シグナル)を特定・増幅します。これにより、従来のAI訓練手法の課題であった解答の多様性不足を解消し、効率的な学習を可能にしています。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。