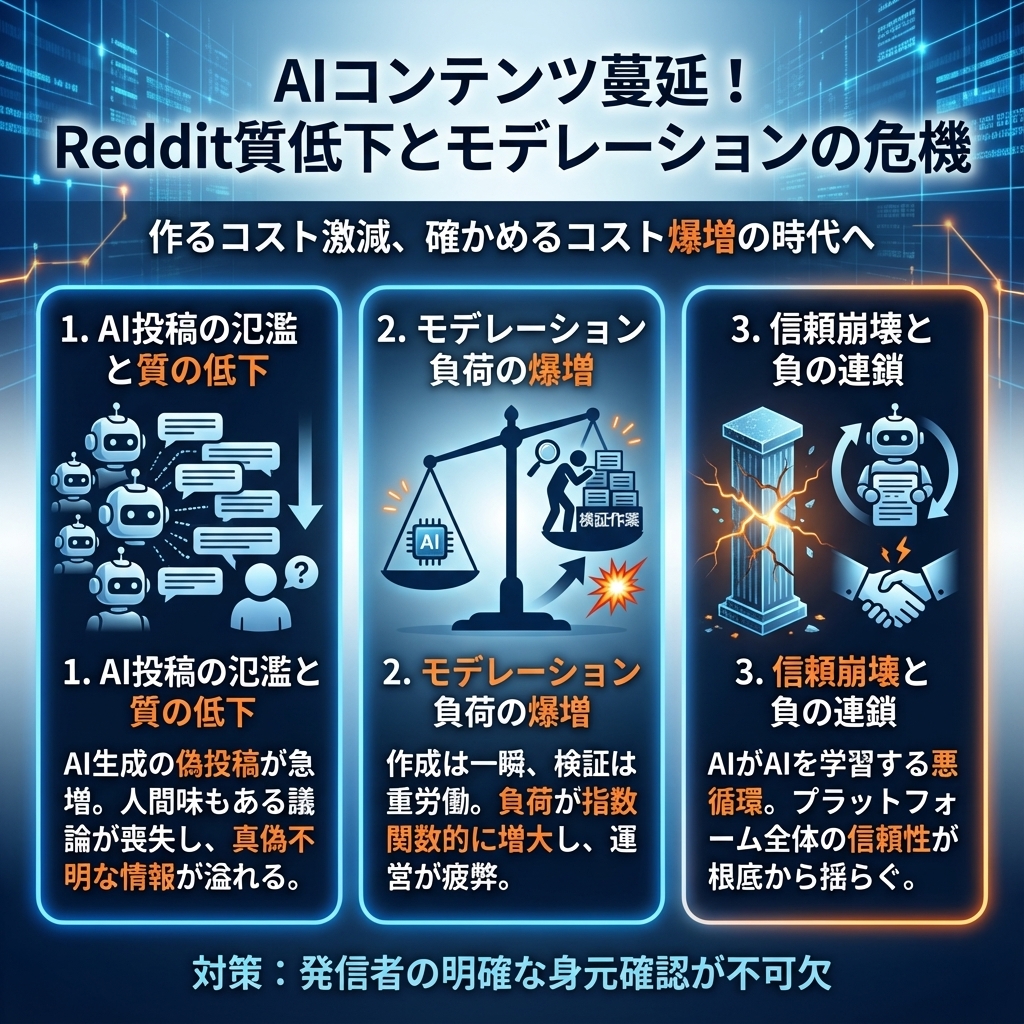

AIコンテンツ蔓延でRedditが質低下、モデレーション負荷爆増の現実と対策

Reddit、Facebook、Instagram、TikTokなど、私たちが日常的に利用するソーシャルメディアプラットフォームで、AI生成コンテンツが急激に増加しています。特にRedditでは、この現象が深刻な問題となっており、プラットフォーム全体の品質低下とモデレーション業務の負荷増大という二重の課題に直面しています。

この問題は単にRedditだけの話ではありません。AI技術の進歩により、誰でも簡単に本物らしいコンテンツを大量生成できるようになった一方で、それを見分け、適切に管理するコストは指数関数的に増加しています。私たちは今、「作るコストが激減し、確かめるコストが爆増する」という新たな時代に突入しているのです。

本記事では、Redditで実際に起きている問題の詳細と、この現象が他のプラットフォームや私たちの日常にどのような影響を与えるのか、そして信頼できるコンテンツを見分け、作り出すための具体的な対策について詳しく解説します。

目次

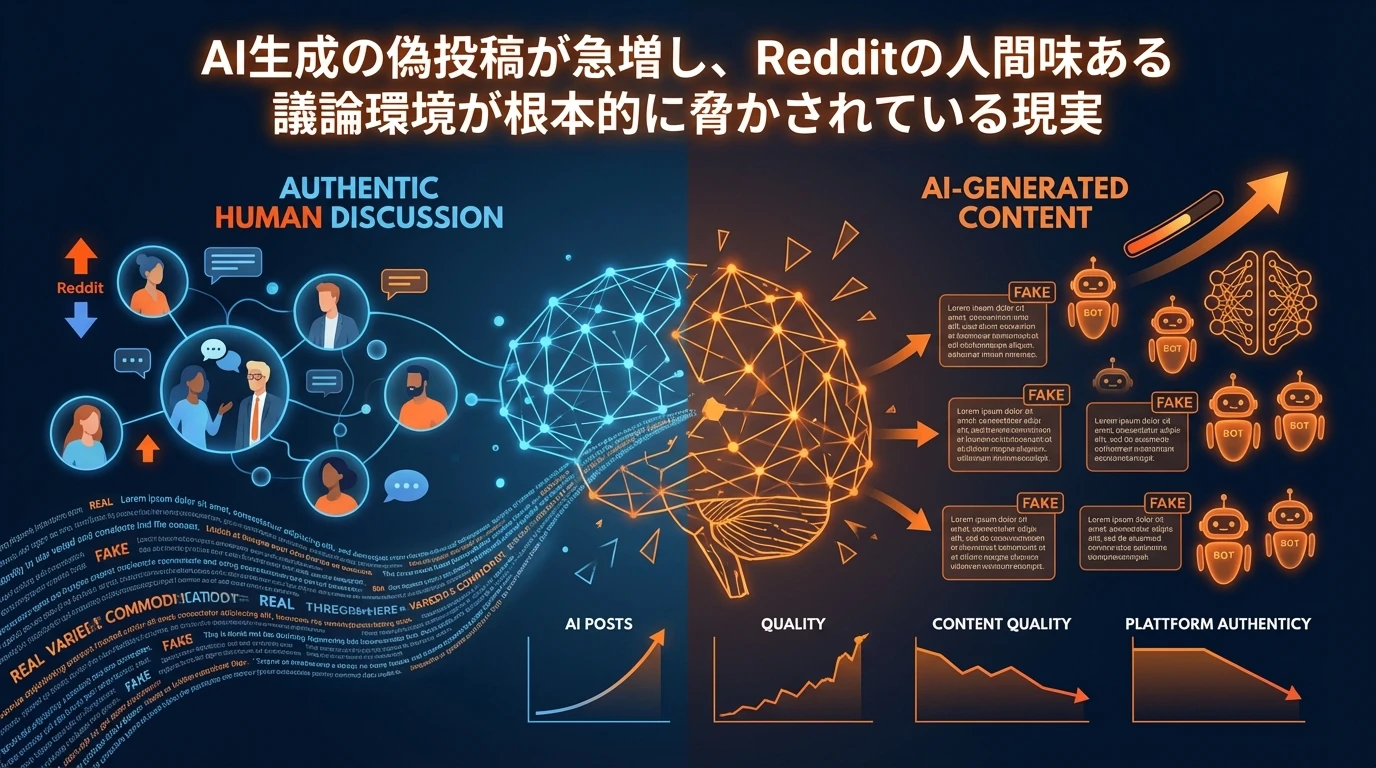

Redditで起きているAIコンテンツ問題の実態

Redditは世界最大級の議論プラットフォームとして、これまで「最も人間味あふれる場所」として親しまれてきました。しかし現在、AI生成コンテンツの急増により、その特徴が根本的に脅かされています。

具体的な問題として、「ある花嫁が結婚式のゲストに似合わない特定の色を要求した」といった、一見もっともらしい投稿が実際にはAI生成の偽投稿として大量に出現しています。これらのコンテンツは、人間関係の悩みや対人関係のアドバイスを求める投稿を装っており、読者の感情に訴えかける内容になっているため、一見すると本物と区別がつきません。

18年間Redditで活動してきた長期ユーザーからは、「過去1年間でRedditの質が著しく低下した」「AIはRedditをゴミ山に変えている」という厳しい声が上がっています。これは単なる感情的な反応ではなく、実際にプラットフォームの根本的な価値が損なわれていることを示しています。

特に深刻なのは、AIコンテンツかどうかを確実に証明する方法がほとんど存在しないという現実です。写真や動画であればある程度の検証が可能ですが、テキストコンテンツについては、一般の人々は主に直感に頼らざるを得ない状況となっています。

モデレーション業務の負荷爆増という現実

AI生成コンテンツの増加は、プラットフォーム運営側にも深刻な影響を与えています。Redditのモデレーターたちは、AI生成コンテンツを精査するために要する追加時間が大幅に増加していると報告しています。

この問題の本質は、「AI生成コンテンツを作るのは驚くほど簡単なのに、それを評価するにははるかに多くの努力が必要」という非対称性にあります。悪意のあるユーザーは数秒でAI生成コンテンツを投稿できますが、モデレーターはその真偽を確認するために数分から数十分の時間を要します。

この現象は「ワークスロップ」という概念で説明できます。AIが作成するコンテンツが大量に生成される一方で、それを確認・検証する側の負荷が急激に増加するという状況です。これは単にRedditだけの問題ではなく、あらゆるソーシャルメディアプラットフォームで共通して発生している課題です。

実際に、2025年のソーシャルメディアモデレーション調査によると、AI生成コンテンツは事実に基づくコンテンツよりも6倍速く拡散することが明らかになっており、モデレーション業務の複雑さと重要性が急激に高まっています。

信頼の崩壊とプラットフォームへの影響

AI生成コンテンツの蔓延は、単なる運営上の問題を超えて、プラットフォーム全体の信頼性に深刻な影響を与えています。ユーザーは投稿内容の真偽を疑うようになり、本来の目的である建設的な議論や情報交換が阻害されています。

特に問題となるのは「AIがAIを食べる」現象です。AI生成コンテンツが大量に投稿されることで、それらを学習データとして使用する新たなAIシステムが、さらに品質の低いコンテンツを生成するという悪循環が発生しています。これにより、プラットフォーム全体のコンテンツ品質が継続的に低下していく可能性があります。

また、「負荷の外部化」という問題も深刻です。AI生成コンテンツを作成する側は最小限のコストで大量のコンテンツを投稿できますが、その検証や対処にかかるコストは、プラットフォーム運営者やモデレーター、そして最終的にはユーザーコミュニティ全体が負担することになります。

これからの時代に生き残るコンテンツの条件

このような状況下で、信頼できるコンテンツとして生き残るためには、いくつかの重要な要素があります。

発信者の明確な身元確認

最も重要なのは、「誰が発信したか」を明確にすることです。匿名性が重視されてきたインターネット文化において、これは大きな転換点となりますが、信頼性を担保するためには避けて通れない道となっています。

具体的には、発信者が本人であることを検証できる仕組みの導入や、投稿者が責任を負うような形での情報発信が求められます。これは完全な実名制を意味するものではありませんが、少なくとも発信者の身元が追跡可能で、責任の所在が明確である必要があります。

GoogleのE-E-A-T概念の重要性

Googleが検索品質評価で重視しているE-E-A-T(Experience, Expertise, Authoritativeness, Trustworthiness)の概念が、AI時代のコンテンツ評価においてより重要になっています。

- Experience(経験):実際の体験に基づいた内容

- Expertise(専門性):特定分野での深い知識

- Authoritativeness(権威性):信頼できる情報源としての地位

- Trustworthiness(信頼性):一貫した品質と透明性

これらの要素を満たすコンテンツは、AI生成コンテンツとは明確に差別化され、長期的に価値を持ち続けることができます。

実名制プラットフォームの台頭

今後は、完全に実名制のSNSや、少なくとも発信者の身元が保証されたプラットフォームでのコミュニケーションが主流になる可能性があります。匿名性を重視してきた従来のインターネット文化からの大きな転換となりますが、信頼性を重視するユーザーにとっては必要な変化と言えるでしょう。

AI時代のコンテンツ認証技術

技術的な解決策として、コンテンツの真正性を証明するための様々な認証技術が開発されています。

コンテンツプロベナンス(来歴追跡)

ITIの報告書によると、C2PA(Coalition for Content Provenance and Authenticity)が開発したContent Credentialsシステムは、デジタルコンテンツの作成から編集まで全ての過程を追跡可能にする技術です。

この技術では、コンテンツ作成時に以下の情報が暗号化されて埋め込まれます:

- 作成者の情報

- 作成日時と場所

- 使用されたツールやソフトウェア

- 編集履歴

- AI使用の有無

ウォーターマーキング技術

GoogleのSynthIDやOpenAIが検討している透明ウォーターマークなど、AI生成コンテンツに見えない印を埋め込む技術も実用化が進んでいます。これらの技術により、AI生成コンテンツを自動的に識別することが可能になります。

ブロックチェーン技術の活用

分散台帳技術を使用してコンテンツの真正性を保証する取り組みも進んでいます。一度記録された情報は改ざんが困難であるため、コンテンツの信頼性を長期的に保証することができます。

プラットフォーム側の対策と課題

各ソーシャルメディアプラットフォームも、AI生成コンテンツ問題に対して様々な対策を講じています。

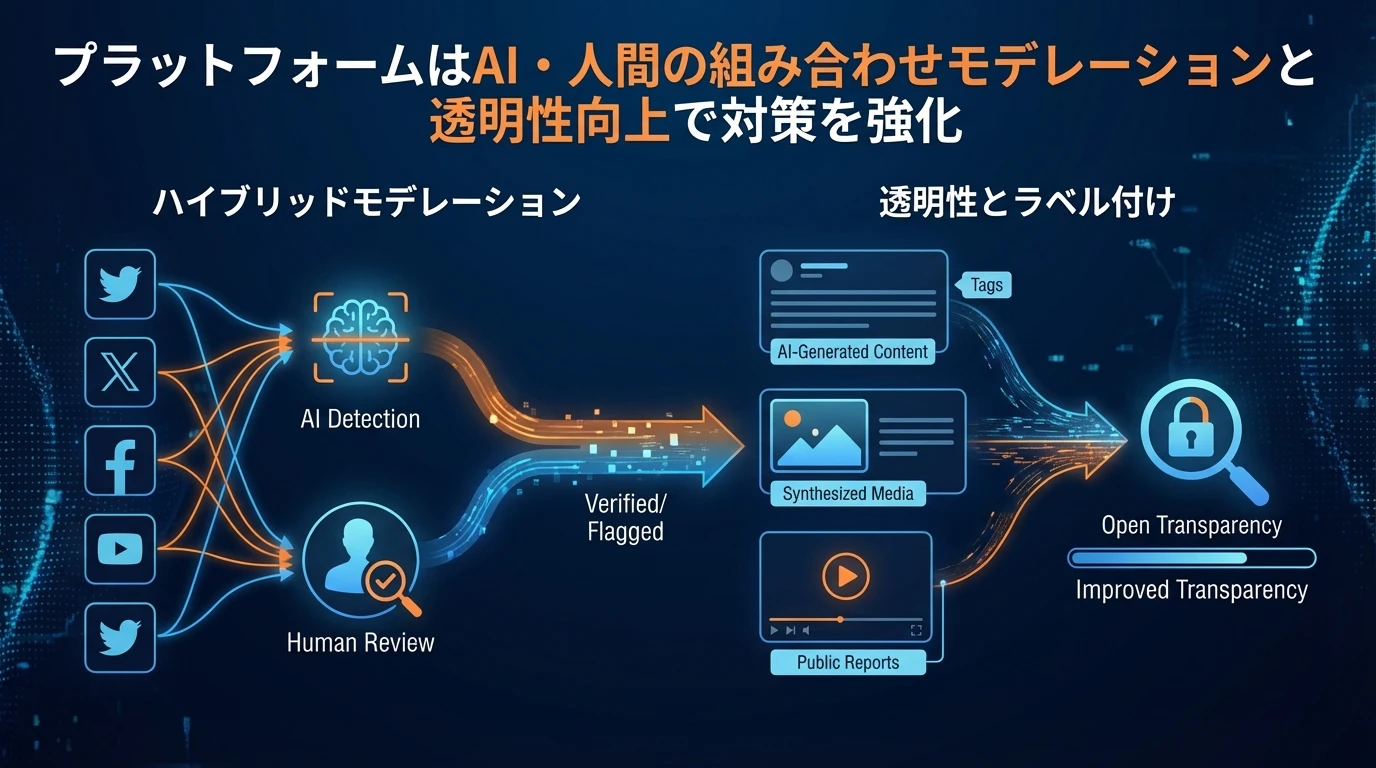

ハイブリッドモデレーションの導入

2025年のAIコンテンツモデレーション市場調査によると、最も効果的なアプローチは、AIによる自動検出と人間による判断を組み合わせたハイブリッドモデレーションです。

| コンテンツタイプ | 対応方法 | 担当 |

|---|---|---|

| 明らかなスパム・不適切コンテンツ | 自動削除 | AI |

| 境界線上のヘイトスピーチ・侮辱 | 手動レビュー | 人間モデレーター |

| 脅迫・自傷コンテンツ | 即座にエスカレーション | 法務・広報チーム |

| 風刺・センシティブな話題 | 文脈的解釈 | 人間モデレーター |

| 批判・苦情 | 有害でない限り許可/レビュー | 人間モデレーター + CRM |

透明性の向上

多くのプラットフォームが、AI生成コンテンツに対する明確なラベリングシステムを導入しています。例えば、Metaは「AI Info」バッジを使用してAI生成メディアを識別し、透明性を促進しています。

検出技術の高度化

自然言語処理(NLP)と機械学習アルゴリズムの進歩により、AI生成テキストの検出精度が向上しています。2024年のTurnitinの報告では、AI支援エッセイの識別において89%の成功率を達成したとされています。

ユーザーとしての対策と心構え

プラットフォーム側の対策だけでなく、私たちユーザー自身も適切な対策を講じる必要があります。

メディアリテラシーの向上

AI生成コンテンツを見分けるためのスキルを身につけることが重要です。以下のような点に注意を払いましょう:

- 情報源の確認:投稿者のプロフィールや過去の投稿履歴をチェック

- 内容の一貫性:論理的な矛盾や不自然な表現がないか確認

- 感情的な反応の抑制:感情に訴えかける内容ほど慎重に検証

- 複数ソースでの確認:重要な情報は複数の信頼できるソースで確認

信頼できるソースの選別

情報収集においては、以下のような特徴を持つソースを優先的に利用することが推奨されます:

- 発信者の身元が明確

- 専門性や実績が確認できる

- 一貫した品質を維持している

- 透明性のあるコンテンツ作成プロセス

コミュニティ参加による検証

TwitterのCommunity Notesのような、ユーザー参加型の事実確認システムを積極的に活用し、疑わしいコンテンツに対しては建設的なフィードバックを提供することも重要です。

まとめ

AI生成コンテンツの蔓延によるRedditの質低下とモデレーション負荷の増大は、現代のデジタル社会が直面する重要な課題の象徴です。この問題は以下の要点に集約されます:

- 非対称性の問題:AI生成コンテンツの作成コストは激減する一方、検証コストは爆増している

- 信頼性の危機:プラットフォーム全体の信頼性が根本的に脅かされている

- 透明性の重要性:発信者の身元確認とAI使用の明確な開示が信頼構築の鍵

- 人間中心のアプローチ:AIは補助ツールとして活用し、最終的な判断は人間が担う

- 多面的な解決策:技術、規制、教育、社会規範の総合的な取り組みが必要

私たちは今、デジタルコミュニケーションの新たな時代の入り口に立っています。AI技術の恩恵を享受しながらも、人間らしさと信頼性を保持するためには、個人、企業、プラットフォーム運営者、そして社会全体が協力して取り組む必要があります。

最終的に重要なのは、技術の進歩に振り回されるのではなく、人間の価値観と判断力を核とした、持続可能で信頼できるデジタル環境を構築することです。そのためには、透明性、責任、そして継続的な学習と適応が不可欠となるでしょう。

参考リンク

本記事の作成にあたり、以下の情報源も参考にしています:

- WIRED: AI Slop Is Ruining Reddit for Everyone

- Sprinklr: Social Media Moderation in 2025

- Vertu: AI Content Moderation Types and Applications in 2025

- ITI: Authenticating AI-Generated Content Policy Paper

- Senior Executive: How to Keep Brand Content Authentic in the Age of AI

よくある質問(FAQ)

Q1 RedditでAI生成コンテンツが問題になっているのはなぜですか?

AI技術の進歩により、誰でも簡単に大量のコンテンツを生成できるようになったため、RedditのようなプラットフォームではAIが生成した偽の投稿が急増しています。これらのコンテンツは、人間関係の悩み相談などを装い、読者の感情に訴えかけるため、本物と区別がつきにくいのが問題です。

Q2 AI生成コンテンツの増加は、Redditのモデレーターにどのような影響を与えていますか?

AI生成コンテンツの増加により、モデレーターはコンテンツの真偽を確認するために多くの時間を費やす必要が生じています。AIがコンテンツを生成するのは容易ですが、モデレーターがその真偽を評価するには多くの労力がかかるという非対称性が、モデレーション業務の大きな負担となっています。

Q3 AI時代のコンテンツで信頼性を保つために重要なことは何ですか?

コンテンツの信頼性を保つためには、発信者の身元を明確にすること、Googleが重視するE-E-A-T(Experience, Expertise, Authoritativeness, Trustworthiness)の概念を満たすこと、そして実名制プラットフォームを利用することが重要です。これにより、AI生成コンテンツとの差別化を図り、長期的に価値のあるコンテンツを提供できます。

Q4 AI生成コンテンツを見分けるために、ユーザーができることはありますか?

ユーザーは、情報源の確認、内容の一貫性のチェック、感情的な反応の抑制、複数ソースでの確認を行うことで、AI生成コンテンツを見分けることができます。また、TwitterのCommunity Notesのようなユーザー参加型の事実確認システムを活用することも有効です。

Q5 企業やブランドは、AI時代にどのようにコンテンツの信頼性を確保すべきですか?

企業やブランドは、AI使用時の明確な開示、コンテンツ作成プロセスの可視化、人間による監修体制の明示など、透明性を重視したコンテンツ戦略を実施すべきです。また、AIを効率化ツールとして活用しつつも、最終的な判断と責任は人間が担うという姿勢が重要です。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。