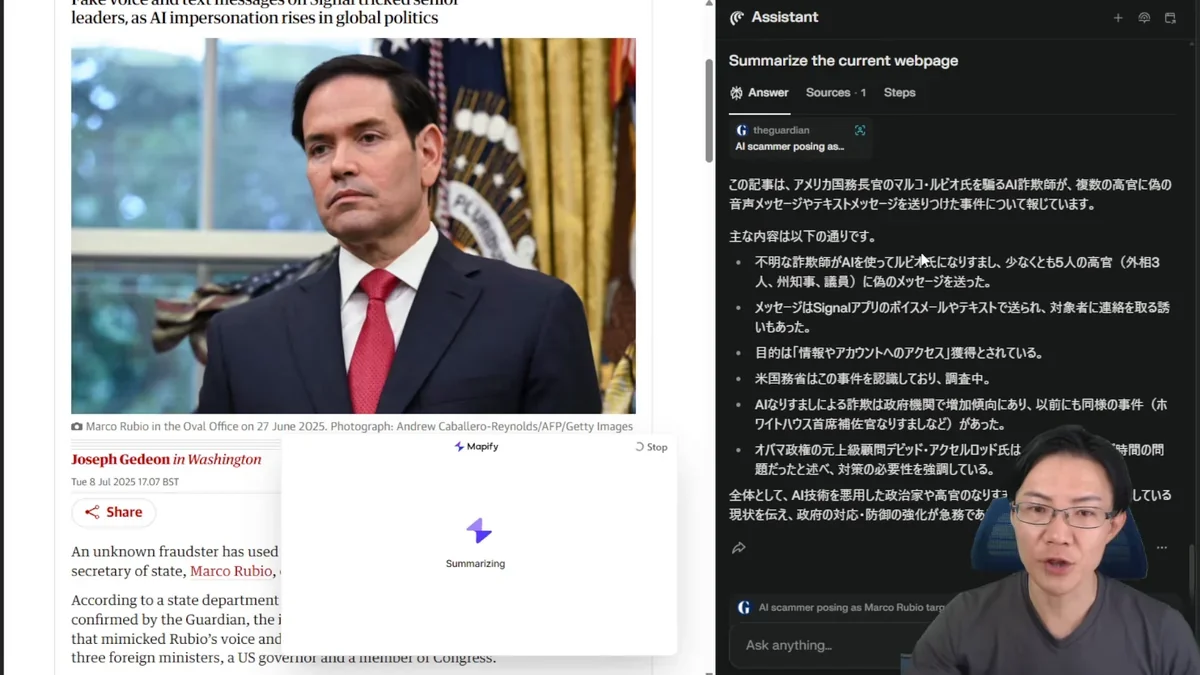

最近、非常に恐ろしい詐欺事件が報告されました。アメリカの国務長官であるマルコ・ルビオ氏の声をAIで完全に模倣し、複数の関係者に偽のメッセージを送信するという事件が発生したのです。

この事件では、詐欺師がルビオ氏になりすまして少なくとも5人の関係者に対して偽メッセージを送っていました。さらに恐ろしいのは、単なる文字メッセージだけでなく、ルビオ氏の声や文体を精巧に模倣した音声メッセージまで送信していたという点です。

詐欺師は暗号化メッセージアプリである「Signal」を利用することで、通信の秘匿性を高め、発覚を遅らせる工夫まで施していました。これは単発の事件ではありません。過去にはホワイトハウスのスージー・ワイルズ氏を装ったケースも報告されており、政府高官を標的としたAI詐欺が組織的に行われている可能性が高いと考えられます。

この記事では、急速に巧妙化するAI音声詐欺の実態と、私たちが身を守るために知っておくべき対策について詳しく解説します。もはや「自分の周りでも普通にあり得る」レベルまで技術が進歩している現実を、しっかりと理解していただければと思います。

目次

なぜAI音声詐欺がこれほど危険なのか?

AI音声詐欺が従来の詐欺と根本的に異なるのは、技術的な精度の高さにあります。現在のディープフェイク音声技術は、わずか数十秒の音声サンプルから、本人と区別がつかないレベルの偽音声を生成できるまでに進化しています。

特に恐ろしいのは、リアルタイム音声クローニングが可能になったことです。これまでは事前に音声を準備する必要がありましたが、現在では電話での会話中にリアルタイムで声を変換することも技術的に可能となっています。

さらに、低品質な電話通話環境でも高精度な偽装音声を生成できるため、「電話の音質が悪いから本人かどうか分からない」という状況を悪用されるリスクが高まっています。

政府関係者が標的になる理由

今回のルビオ国務長官の事件が示すように、詐欺師が政府高官を標的にする理由は明確です:

- 権威性の悪用:政府高官からの連絡は、受け手が疑いを持ちにくい

- 機密性の利用:「機密事項のため詳細は言えない」という理由で詳しい確認を避けられる

- 緊急性の演出:国家的な重要事項として緊急対応を求めることができる

- 高額な詐取可能性:政府関係者との取引は金額が大きくなりがち

実際に、イタリア国防大臣のなりすまし事件や、企業経営者を装った詐欺事例も多数報告されており、権威ある立場の人物を装う手口が世界的に拡大している状況です。

AI詐欺の多様化する手口と被害事例

AI技術を悪用した詐欺は、音声だけにとどまりません。現在確認されている主要な手口を整理すると、以下のようなパターンがあります。

1. 音声なりすまし詐欺

最も一般的で被害が深刻なのが音声を使った詐欺です。具体的な手口として:

- 企業経営者の声を偽装:取引先に「急ぎの送金」を指示

- 家族の声を模倣:事故やトラブルを装って金銭を要求

- 政府関係者になりすまし:公的な手続きを装った詐欺

2025年6月の報告では、金融機関で偽装メールと組み合わせた手口により約3億円の損失が発生した事例や、IT企業で経営幹部を装ったBEC(ビジネスメール詐欺)により約1億2千万円の損失が発生した事例が確認されています。

2. ディープフェイク動画詐欺

音声だけでなく、映像も含めた完全ななりすましも増加しています:

- ビデオ通話での本人確認偽装:オンライン会議で経営者になりすまし

- 有名人なりすましロマンス詐欺:SNSで著名人を装った恋愛詐欺

- 就職活動でのAI面接偽装:採用面接で別人がAIを使って参加

特に香港では、ディープフェイク動画を使ったビデオ詐欺で38億円が詐取されたという衝撃的な事例も報告されています。

個人でできる具体的な対策方法

これらの巧妙化するAI詐欺から身を守るためには、従来の「怪しいメールは開かない」といった対策だけでは不十分です。より具体的で実践的な対策が必要になります。

1. 多段階認証の徹底

最も重要なのは、複数の手段による本人確認を習慣化することです:

- 別の連絡手段での確認:メールで連絡が来たら電話で、電話で連絡が来たら直接会って確認

- 事前に決めた合言葉の使用:家族間で緊急時の合言葉を決めておく

- 過去の共通体験の確認:本人しか知らない具体的な出来事について質問する

2. 送金・重要判断の社内ルール化

企業や組織では、以下のような厳格なルールの導入が効果的です:

- 二重チェック制度の義務化:上司からの送金指示でも、必ず別の手段で本人確認

- 高額取引の対面確認:一定金額以上の取引は必ず対面または複数人での確認

- 緊急案件の冷却期間:「今すぐ」という要求には最低1時間の検討時間を設ける

3. 技術的な対策の活用

個人レベルでも導入できる技術的対策として:

- メール認証技術の確認:SPF/DKIM/DMARCの設定状況をIT部門に確認

- AI検知ツールの活用:ディープフェイク検出アプリの利用

- 生体認証の積極利用:指紋認証や顔認証を可能な限り活用

企業が導入すべき包括的なセキュリティ対策

個人の対策だけでは限界があるため、企業レベルでの組織的な対策が不可欠です。2025年7月時点で効果が確認されている対策を詳しく解説します。

1. 教育・研修プログラムの強化

最も重要なのは、全社員がAI詐欺の手口を正確に理解することです:

- 定期的なAI詐欺研修:最新の手口と対策を3ヶ月ごとに更新

- 実践的なシミュレーション:実際の詐欺メールや音声を使った訓練

- 部署別カスタマイズ研修:経理部門、人事部門など、標的になりやすい部署への特別研修

2. 技術的セキュリティの多層化

単一の対策では突破される可能性があるため、複数の技術を組み合わせた多層防御が必要です:

| 対策技術 | 具体的な実装例 | 効果 |

| サンドボックス検証 | メール添付ファイルを仮想環境で実行テスト | 悪意のあるコードを事前除外 |

| 行動パターン分析 | 普段と異なる送金パターンを自動検知 | 異常な取引を早期発見 |

| 音声認証システム | 声紋分析による本人確認 | 音声なりすましを技術的に検出 |

3. 組織的なガバナンス体制

技術的対策と並行して、組織運営面での対策も重要です:

- インシデント対応チームの設置:AI詐欺専門の対応チームを社内に設置

- 外部専門機関との連携:サイバーセキュリティ企業との定期的な情報共有

- 被害発生時の迅速な対応手順:詐欺が疑われる場合の報告・対応フローの明文化

まとめ:AI詐欺時代を生き抜くための心構え

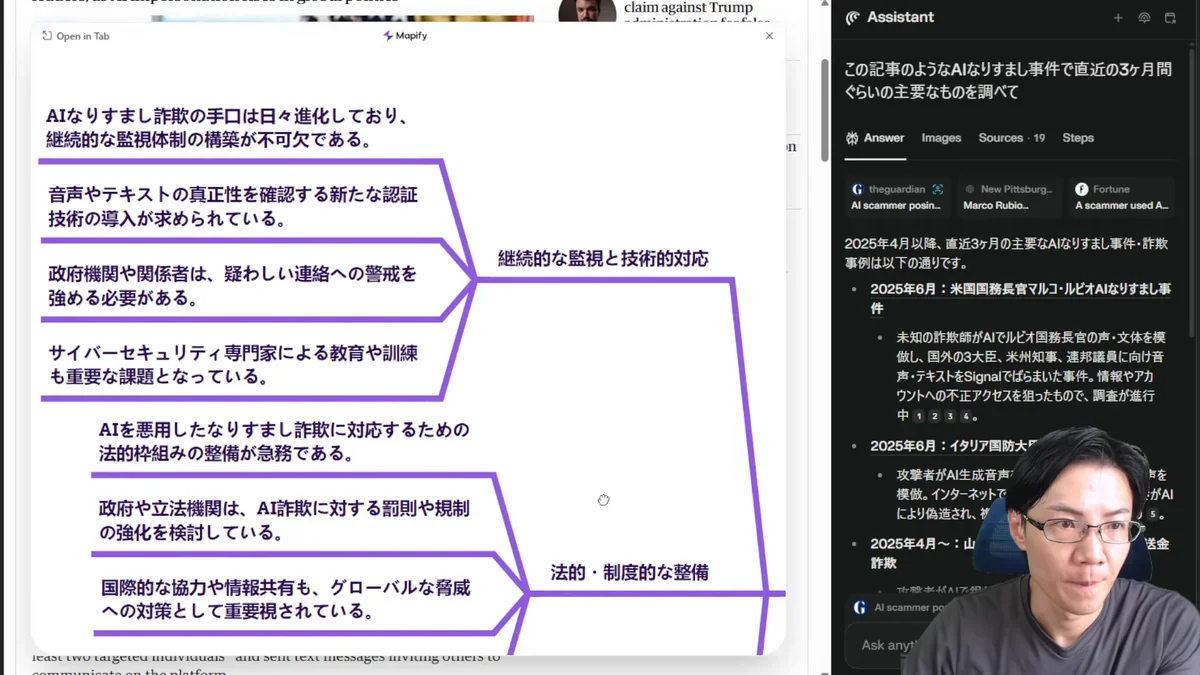

マルコ・ルビオ国務長官の音声を模倣したAI詐欺事件は、私たちが直面している新しい脅威の象徴的な事例です。この事件から学ぶべき重要なポイントを改めて整理します:

- AI音声技術の精度は既に人間の判別能力を超えている:声だけでの本人確認は危険

- 権威ある立場の人物を装う手口が増加:政府関係者や企業幹部からの連絡こそ慎重に確認

- 暗号化アプリも安全ではない:セキュアな通信手段も詐欺に悪用される

- 個人の注意だけでは限界がある:組織的な対策と技術的な防御が不可欠

- 継続的な学習と対策更新が必要:AI技術の進歩に合わせて対策も進化させる

重要なのは、「自分の周りでも普通にあり得る」という危機意識を持つことです。もはやAI詐欺は遠い世界の話ではありません。日常的なコミュニケーションの中で、常に「本当に本人からの連絡なのか?」という疑問を持つ習慣を身につけることが、私たち一人ひとりができる最も基本的で重要な対策なのです。

技術の進歩は止められませんが、適切な知識と対策により、AI詐欺の被害を防ぐことは十分可能です。この記事で紹介した対策を参考に、個人レベル、組織レベルでの防御体制を今すぐ見直していただければと思います。

よくある質問(FAQ)

Q1 AI音声詐欺とはどのような手口ですか?

AI音声詐欺は、AI技術を用いて特定の人物の声を模倣し、その人物になりすまして詐欺を行う手口です。例えば、企業経営者の声を偽装して取引先に送金を指示したり、家族の声を模倣して事故やトラブルを装って金銭を要求したりする事例が報告されています。最近では、アメリカの国務長官の声をAIで模倣し、関係者に偽のメッセージを送る事件も発生しています。

Q2 AI音声詐欺から個人を守るための対策は?

AI音声詐欺から身を守るためには、多段階認証の徹底、つまり複数の手段で本人確認を行うことが重要です。例えば、メールで連絡が来たら電話で、電話で連絡が来たら直接会って確認するなど、複数の確認手段を組み合わせましょう。また、事前に家族間で緊急時の合言葉を決めておく、本人しか知らない過去の共通体験について質問するなども有効です。

Q3 企業がAI詐欺対策として導入すべきことは?

企業レベルでは、全社員がAI詐欺の手口を正確に理解するための教育・研修プログラムの強化が重要です。定期的な研修やシミュレーションを実施しましょう。また、技術的なセキュリティの多層化として、サンドボックス検証や行動パターン分析、音声認証システムなどを導入することも効果的です。組織的なガバナンス体制の構築も不可欠で、インシデント対応チームの設置や外部専門機関との連携を進めましょう。

Q4 AI音声詐欺はなぜ危険なのですか?

AI音声詐欺の危険性は、技術的な精度の高さにあります。現在のディープフェイク音声技術は、わずか数十秒の音声サンプルから本人と区別がつかないレベルの偽音声を生成できます。リアルタイム音声クローニングも可能になり、電話での会話中にリアルタイムで声を変換することも技術的に可能です。そのため、従来の詐欺よりも見破ることが難しく、被害に遭いやすいのが特徴です。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。