AI音声ツール「IndexTTS2」で音声合成が劇的進化|感情表現ができるAI技術とは?

私たちは長年、不完全なAI音声と付き合ってきました。最初は機械的で、カーナビの「左に曲がってください」のような無機質な声。その後、オーディオブックのナレーターとしてなら何とか通用するレベルまで改善されました。

しかし、細かい部分に注目すると、従来の音声合成は肝心な場面で必ず失敗していました。

従来のTTS(音声合成)の限界

- 必要な箇所で適切な間を取れない

- 叫び声、笑い声、ささやき声のリズムが不自然

- 動画の口パク(リップシンク)に音声が合わない

IndexTTS2は、これらの問題を解決し、実際に「演技ができる」音声合成を実現した画期的な技術です。

実際の音声例。非常にリアルですね。

目次

従来技術の2大課題

課題1:タイミング制御の困難さ

従来の自動回帰モデル(Autoregressive Models)は、音声を段階的に生成するため自然な流れを作ることは得意でした。しかし「正確に3.2秒の長さで話してください」と指定しても、予測不可能に伸び縮みしてしまいます。

⚠️ アニメの吹き替えなどでは、この問題は致命的です

課題2:感情表現の歪み

ほとんどのシステムが「誰が話しているか」と「どのように話しているか」を混同してしまいます。穏やかな声に「怒り」を指定すると、話者のアイデンティティ自体が変わってしまうのです。

💡 例えるなら:友達に大声で叫んでもらったら、急に別人の声になってしまうような現象です。

IndexTTS2は、正確な時間制御と感情の分離という2つの課題を同時に解決し、精密な時間制御を実現した初の自動回帰ゼロショット音声合成システムです。

IndexTTS2の仕組み:3つのコアモジュール+感情制御機能

1. Text to Semantic(T2S):テキストを意味に変換

何をするの?

生のテキストを「セマンティックトークン」に変換します。これは意味とリズムの小さな塊だと考えてください。

ここがすごい!

従来のモデルは「満足するまで生成し続ける」方式でしたが、IndexTTS2では「正確にXトークン生成して」と指定できます。これにより、流暢さを維持しながら高精度のタイミング制御が可能になりました。

2. Semantic to Mel(S2M):音声の設計図を作成

何をするの?

セマンティックトークンをメル・スペクトログラム(音の熱マップのようなもの)に変換します。

画期的な工夫

GPT-like モデルの隠れ状態(Hidden States)を混合しています。なぜでしょうか?感情的な発話では言葉がぼやけたり滑ったりする傾向があるためです。この追加コンテキストにより、話者が泣いていても、叫んでいても、震えていても、明瞭性を保つことができます。

3. Vocoder:実際の音声に変換

メル・スペクトログラムを実際の音声に変換する最終ステップです。IndexTTS2では、最も優秀なニューラルボコーダーの一つであるBigVGANv2を使用しています。

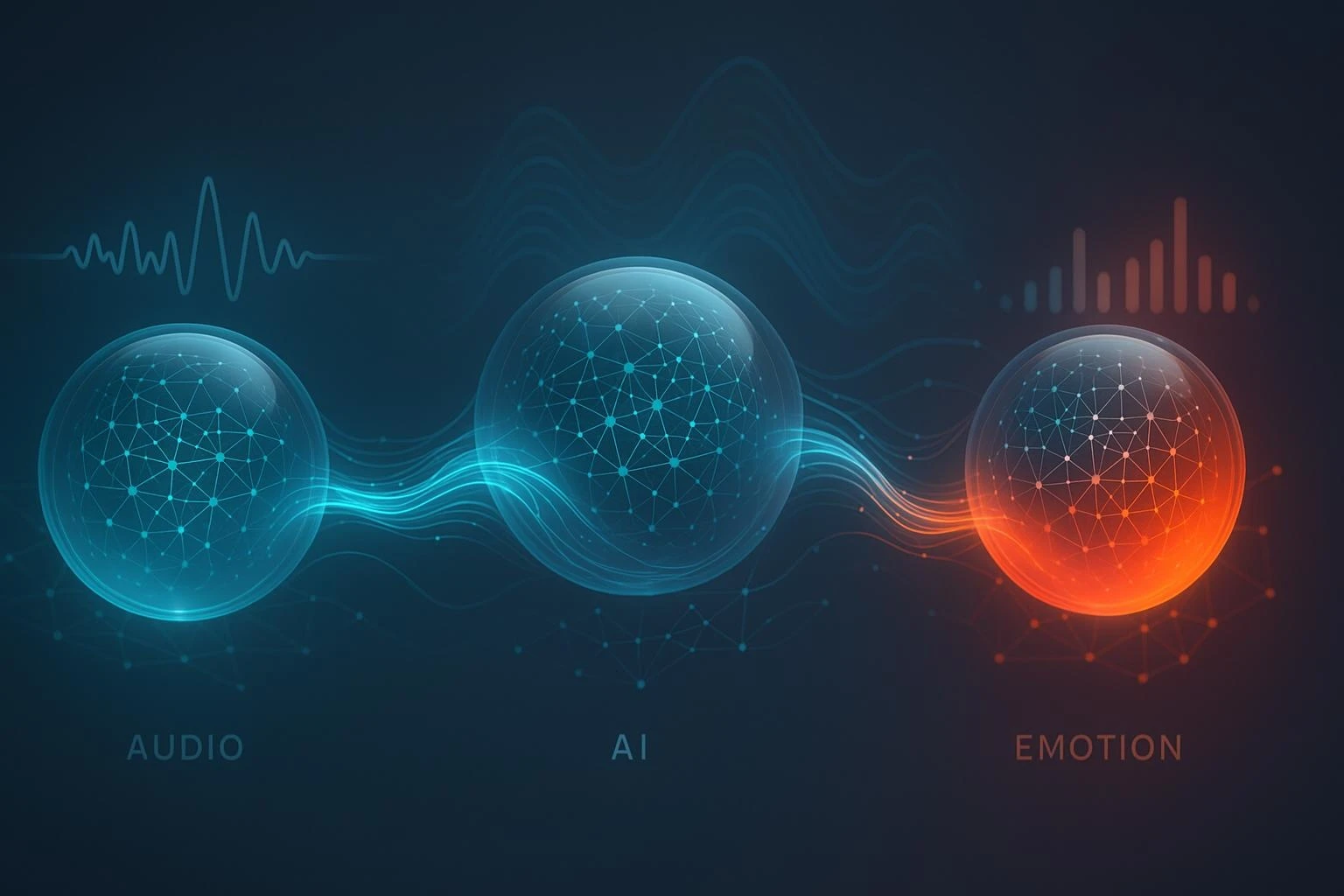

4. Text to Emotion(T2E):テキストで感情を制御

これまでとの違い

従来:「怒った声」の音声クリップをリファレンスとして使用

IndexTTS2:「怒り」「悲しみ」と単純にテキスト入力するだけで感情プロファイルを自動生成

Qwenシリーズのモデルを活用して、プレーンテキストから感情を読み取れるようになりました。

セマンティックトークンとかメル・スペクトログラムとか、専門用語が多くて難しそうですが、簡単に言うとどういう流れなんですか?

料理に例えると分かりやすいですよ!まず材料(テキスト)を下ごしらえ(セマンティックトークン化)し、次にレシピ通りに調理(メル・スペクトログラム作成)、最後に盛り付けて完成(音声化)という3段階です。IndexTTS2のすごい点は、この工程で「正確に3分で話して」と指定できることと、途中で感情という「調味料」を加えられることなんです。

効果的な3段階トレーニング手法

IndexTTS2の優秀さは、モデル設計だけでなく、賢いトレーニング方法にもあります。

ステップ1:基本能力学習

時間指定ありと自由形式の両方の音声データで学習し、柔軟性を身につけます。

ステップ2:感情特化学習

感情データに集中して学習し、感情と話者のアイデンティティを分離することに集中します。ここでは「勾配反転トリック」を使用します。

ステップ3:全体統合とファインチューン

全データセットで軽く微調整を行い、システム全体の安定性と高品質な感情表現の両立を確保します。

⚠️ なぜこの段階的アプローチが重要?

感情データは希少で扱いにくいものです。この3段階手法により、基本能力、感情表現、全体統合を段階的に学習し、システムが話者の音色を失うことなく豊かな感情表現を実現できます。

なぜこんなに複雑な3段階のトレーニングが必要なんですか?最初から全部一緒に学習させちゃダメなんですか?

これは語学習得と似ているんです。まず基本的な文法を覚え(基本能力学習)、次に感情表現を練習し(感情特化学習)、最後に自然な会話で統合する(全体統合)という流れです。感情データは貴重で扱いにくいため、いきなり全部一緒に学習すると、話者の声色を失ったり感情表現が不自然になってしまいます。段階的に学習することで、「この人の声」を保ちながら「怒り」「悲しみ」を表現できるようになるんです。

驚異的な性能結果

IndexTTS2は大規模な英語・中国語データセット、さらにカスタム感情データセットでテストされました。

タイミング精度

ほぼ完璧です。通常条件ではトークン数エラーは0.02%未満、一部スケール変更時には最大0.067%となりますが、これは吹き替え用途で極めて高い精度を実現できるレベルです。

明瞭性

ほとんどのベンチマークで最低の単語エラー率を記録。簡単に言うと、感情的なストレス下でも単語を正確に発音します。

感情表現

CosyVoice2やF5-TTSなどの競合他社と比較して、リスナーがIndexTTS2の感情的な声を一貫して高く評価しました。人間の審査員は、IndexTTS2が音調、リズム、アイデンティティのバランスを取る方法を好みました。

テキストベース指示

プレーンテキストで感情が与えられた場合、CosyVoice2よりも優れた性能を発揮。これは大きな進歩です。感情をコントロールするために、厳選された感情的な録音は不要になりました。

💡 技術検証

各機能を取り除いたテスト(アブレーション研究)により、設計選択の重要性が証明されました。

- GPT隠れ状態を削除 → 明瞭性が低下

- S2Mモジュールを削除 → 音質と話者類似度が大幅に低下

実用的な活用シーンとメリット

映像制作

外国映画を自分の声で吹き替え、完璧に同期させながら、必要な場面で怒りや悲しみを表現できるAIツールが実現できます。

オーディオブック制作

単一の声優をクローンしつつ、章を通して喜びと悲嘆の間を自然に移行できます

バーチャルアシスタント

質問に答えるだけでなく、適切な場面でため息をついたり、躊躇したり、応援したりできるアシスタント。

重要な転換点:「音声生成器」から「声の演技者」への進化

現在の制限事項

⚠️ 感情の種類が限定的

現在、怒り、幸福、恐怖、嫌悪、悲しみ、驚き、中立などの基本的な感情カテゴリーを認識します。現実の生活はこれらのカテゴリーにきれいに収まりません。皮肉、静かな自信、憂鬱といった微細な感情はまだキャプチャできません。

⚠️ 大規模なリソース要件

55,000件の音声データサンプルと、8つの大型GPUでの3週間のトレーニングが必要です。小さな研究室や個人開発者には手が届かない規模です。

55,000時間のデータと8つのGPUって聞くと、とても個人や中小企業には手が届かない技術に思えるのですが、実際にビジネスで活用できるんでしょうか?

確かにゼロから開発するのは大企業レベルの投資が必要ですが、IndexTTS2はオープンソース化されているので、すでに学習済みのモデルを使うことができます。つまり、重いトレーニング作業は不要で、APIやローカル環境で直接利用可能です。例えば、YouTubeクリエイターが動画のナレーション作成に使ったり、中小企業がプレゼンテーション用の音声を作成したりといった活用が現実的です。大規模なリソースは「開発」に必要なもので、「利用」には必要ありません。

まとめ:AI音声の新時代の到来

IndexTTS2は、合成音声をより人間の演技者に近づける重要なマイルストーンです。外科的な精密さでタイミングを解決し、背後にある声を損なうことなく感情をコントロール可能にしました。

完璧ではありませんが、AIが単に言葉を読み上げるのではなく、実際に言葉を伝える未来に一歩近づけてくれます。

初期のTTSが冷たいナレーターだったとすれば、IndexTTS2は台詞、キュー、感情を知る舞台俳優のようです。

この違いは微妙ですが、「我慢する声」と「実際に信じられる声」の違いなのです。

🎯 この技術の発展を追いかけたい方は、関連論文や開発者のGitHubをチェックして、音声合成の最新動向を把握しましょう!

音声合成の未来は、もうここにあります。

この記事の著者

Mehul Gupta

DBS銀行のデータサイエンティスト。生成AIの実務活用や教育に精通し、情報発信も積極的に行う。

Mehul Gupta(メフル・グプタ)は、DBS銀行のデータサイエンティストであり、 著書『LangChain in Your Pocket』の著者としても知られています。 AIや機械学習の知見を発信するプラットフォーム「Data Science In Your Pocket」を主宰し、 Mediumでは350本以上の技術記事を執筆するトップライターとして活躍中です。 過去にはTata 1mgにて医療データのデジタル化にも取り組みました。 趣味はギター演奏とAI教育への貢献です。

この記事は著者の許可を得て公開しています。

元記事:IndexTTS2 : The perfect TTS is here

この記事の監修・コメント

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&著書『ChatGPT最強の仕事術』は4万部突破。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。