「この列車をロケットに変えて」「雪が降っているシーンにして」

こんな自然な言葉を入力するだけで、動画全体を一貫性を保ったまま編集できる――そんな未来がもう現実になっています。

画像編集AIは急速に進化してきましたが、動画編集はこれまで、マスク作成や深度マップの準備など、面倒な作業が必要でした。処理も遅く、フレーム間でちらつきが発生するなど、課題が山積みでした。

Lucy Editは、そうした問題を一気に解決する、世界初のテキストガイド型動画編集専用の基盤モデルです。マスクや注釈、補助的な入力は一切不要。テキストプロンプトを入力するだけで、動画全体を自然かつ一貫性のある形で編集できます。

こんな方におすすめです!

- 📹 YouTubeやSNS向けの動画コンテンツを効率的に制作したいクリエイター

- 🎬 映像制作のプロで、再撮影なしに衣装や小道具を変更したい方

- 💡 最新のAI動画編集技術を試してみたい方

この記事では、Lucy Editの仕組みから実用的な活用方法まで、初心者にもわかりやすく解説していきます。

👉🔗Lucy Edit AI:https://lucyeditai.ai/

目次

Lucy Editとは?|4つの強みを持つ次世代AIモデル

Lucy Editは、従来の動画編集AIとは一線を画す、4つの重要な特徴を同時に実現しています。これまでの手法では、これら全てを同時に達成することは困難でした。

Lucy Editが実現する4つの特徴

| 特徴 | 説明 |

|---|---|

| プロンプトへの忠実性 | ユーザーの自然言語による指示に正確に従った編集を実現 |

| アイデンティティの保持 | 人物の顔や体型、オブジェクトの特徴を編集後も認識可能な状態で維持 |

| 時間的一貫性 | フレーム間のちらつきやブレを防ぎ、滑らかな動画を生成 |

| リアリズム | 挿入・変更されたコンテンツが、シーンの照明、構図、動きと自然に調和 |

✅ ここがポイント!

最適化ベースの手法は細部を保持できますが、時間的な安定性が崩れがちです。一方、条件付き手法は安定性を保てますが、深度マップなどの外部ガイダンスが必要でした。Lucy Editは、これら両方の依存関係を完全に排除しています。

技術解説|Rectified Flowアーキテクチャの仕組み

Lucy Editの心臓部には、Rectified Flow(整流フロー)と呼ばれる拡散フレームワークが採用されています。従来の拡散モデルがステップバイステップでノイズ除去を行うのに対し、Rectified Flowは決定論的な輸送問題として再定義されています。

「Rectified Flow」って書いてありますが、従来の拡散モデルと何が違うんですか?イメージが湧かなくて…

簡単に言うと、データを作る「道のり」が全然違います。従来の拡散モデルは「曲がりくねった山道を進む」ように、少しずつノイズを取り除いていきます。一方、Rectified Flowは「高速道路を一直線に進む」ように、直線的にデータを生成します。直線的な軌跡のおかげで計算の誤差が少なく、より少ないステップで高品質な動画を作れるんです。この効率性が、Lucy Editの高速処理を支えています。

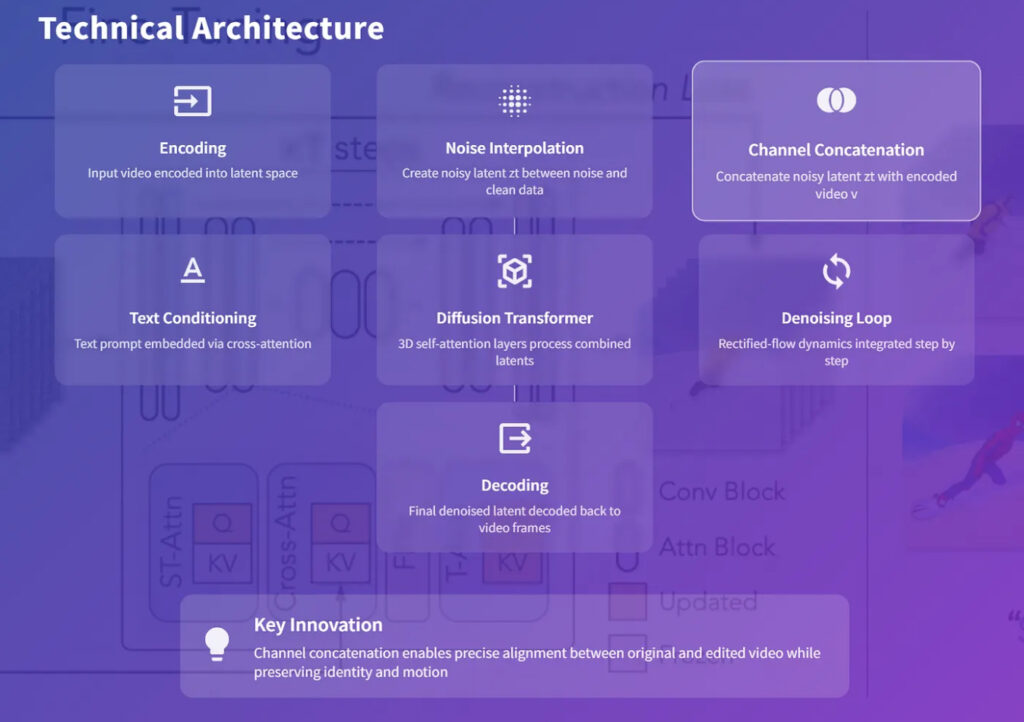

処理の流れ|7つのステップで理解する

Lucy Editがどのように動画を編集するのか、処理の流れを順を追って見ていきましょう。

ステップ1:エンコーディング(符号化)

入力動画を、時空間VAE(変分オートエンコーダー)を使って潜在空間にエンコードします。これにより、動画データが圧縮された潜在テンソル(v)に変換されます。

ステップ2:ノイズの混合

時刻t ∈ [0,1]において、ガウスノイズとクリーンな潜在表現を補間することで、ノイズを含む潜在表現(zt)を作成します。

ステップ3:チャンネル結合(Lucy Editの独自技術)

✨ ここがLucy Editの最大の工夫です!

ノイズを含む潜在表現(zt)と、元の入力動画の潜在表現(v)をチャンネル次元で結合します。この結合されたテンソル(z~t = concat(zt, v))がデノイザーに入力されます。

この変更は驚くほどシンプル(最初の射影層のみが2倍の入力次元を受け取る)ですが、元の動画と編集中の動画の間の正確な位置合わせを可能にし、アイデンティティと動きの保持を実現しています。

ステップ4:条件付け

ユーザーが入力したテキストプロンプトを、事前学習済みの言語エンコーダーで埋め込み、クロスアテンション機構を通じてバックボーンに注入します。

ステップ5:バックボーン処理

3D自己注意層を持つDiffusion Transformer(DiT)が、結合された潜在表現を処理します。この構造により、動画の空間的・時間的な依存関係の両方がモデル化されます。

ステップ6:ノイズ除去ループ

Rectified Flow動力学を段階的に統合していきます:

- 時刻tにおける速度場を予測

- クリーンな多様体に向けて潜在表現を更新

- 収束するまで繰り返し

ステップ7:デコーディング(復号化)

最終的にノイズ除去された潜在表現を、VAEによって動画フレームに戻します。

💡 技術的なメリット

このチャンネル結合による修正は最小限の変更ですが、計算コストを大幅に増加させることなく(二次的な注意機構が主な実行時間を占めるため)、元の動画と編集後の動画の正確な位置合わせを可能にしています。

学習データの秘密|高品質な編集を実現する3つの要素

このようなモデルをトレーニングするには、特別なデータセットが必要です。Lucy Editは、以下のトリプレット(三つ組)データを必要とします:

- 入力動画

- 編集指示(テキスト)

- 編集済み出力動画

これらは時間的・意味的に厳密に整合している必要があります。

「トリプレットデータ」って何ですか?普通の動画データじゃダメなんでしょうか?

トリプレットデータとは「元動画」「編集指示」「編集済み動画」の3つがセットになったデータのことです。例えば「赤いシャツを着た人が歩く動画」「シャツを青に変更」「青いシャツを着た人が歩く動画」という3点セットですね。AIが正確な編集を学ぶには、ビフォーアフターがフレーム単位で厳密に一致している必要があります。このような特殊なデータセットが必要なため、トレーニングは簡単ではありません。

トレーニングデータに必要な4つの条件

| 条件 | 説明 |

|---|---|

| アライメント(整合性) | ソース動画と編集済み動画が、フレーム単位で正確に一致していること |

| 指示と編集の特異性 | 指示文は変更内容を過不足なく正確に記述すること。そうでないと、モデルが誤った相関関係を学習してしまう |

| 多様性 | 衣装の変更、オブジェクトの挿入、スタイル変換、照明の変更など、各カテゴリー内で幅広いバリエーションが必要 |

| リアリズム | 出力は合成的なアーティファクトではなく、実際の映像のように見える必要がある |

Lucy Editのデータセット構成

Lucy Editは、以下の3種類のデータをミックスして学習しています:

- キュレーションされた整合済みトリプレット

高品質で正確に整合された入力-指示-出力のセット - キャプション付き未編集動画

動きや外観の事前知識を正則化するために使用 - 画像-テキストデータセットの拡張

アフィン変換の時間的軌跡を使って短い動画シーケンスに拡張(MovieGenと同様の手法)

このような多様なデータの組み合わせにより、モデルは高忠実度の編集を行いながら、時間的な安定性を維持することを学習します。

性能評価|4つの軸で見るLucy Editの実力

Lucy Editは、従来の数値指標(FIDスコアやCLIPスコア)ではなく、実用性に焦点を当てた質的評価が行われています。評価は以下の4つの軸で行われました:

評価の4つの軸

1. アイデンティティの保持

✅ 衣装、背景、スタイルを変更しても、被写体の一貫性を維持

顔の特徴、体型、動きの軌跡が安定して保たれます。

2. 編集の精度

✅ 髪の色やジャージのテキストなど、局所的な編集を背景や動きに影響を与えずに適用

必要な部分だけを正確に変更し、不要な変化を防ぎます。

3. リアリズム

✅ 編集がシーンの構図、照明、動きと自然に統合

衣服が動きに合わせて変形し、挿入されたオブジェクトが自然な遠近法に従います。

4. プロンプトへの適合性

✅ 補助的な入力なしで、ユーザーの指示に直接従った編集を実現

テキストだけで意図通りの結果が得られます。

💡 なぜこれが重要なのか?

これらの評価は、モデルが実際の現場で使える理由を明確にしています。従来の手法では、編集結果が「貼り付けたような」不自然さや、時間経過とともに不安定になる問題がありました。Lucy Editはこれらの課題を克服しています。

実用例|Lucy Editの3つの活用シーン

Lucy Editの実践的な使い方は、大きく分けて3つのカテゴリーに分類できます。

1. クリエイティブワークフロー

こんな使い方ができます:

- テキストのみを使った反復的な編集を、被写体の連続性を保ちながら実行

- 試行錯誤を繰り返しながら、理想の映像を作り上げる

具体例:

「背景をアトリエに変更」→「主人公の服を黒のジャケットと赤いビキニに変更」→「髪を掻き上げる仕草に変更」といった連続的な編集が可能です。

2. 映像制作・ポストプロダクション

こんな課題を解決:

- 再撮影なしで、小道具、衣装、ロケーションを変更

- 制作コストと時間を大幅に削減

具体例:

俳優の衣装を撮影後に変更したり、背景の看板を差し替えたり、天候を晴れから雨に変更したりすることが、テキスト入力だけで可能になります。

3. パーソナライゼーション

こんなニーズに対応:

- アバター、キャラクター、インフルエンサーのスタイルを動的に変更

- 自然な動きを損なわずに、見た目をカスタマイズ

具体例:

バーチャルアバターの服装や髪型を、視聴者の好みに合わせてリアルタイムで変更できます。

🎯 使いやすさの秘密

テキスト入力のみで操作できるため、技術的な知識がない一般ユーザーでも扱えます。それでいて、プロの制作現場でも通用する高い忠実度を実現しています。

動画編集の経験がないのですが、本当にテキストだけで編集できるんでしょうか?

はい、基本的にはテキストだけで編集できます。マスクや深度マップなどの補助的な入力は不要で、20〜30語程度の具体的なプロンプトで編集が可能です。ただし、「服の色を変える」「背景を変更する」といった明確な編集は得意ですが、「もっとカッコよく」のような抽象的な指示には対応しきれません。また、記事にもあるとおり、連続して何度も編集すると画質が劣化する可能性もあります。まずは単純な編集から始めて、徐々に慣れていくのがおすすめです。

現時点での制限事項|知っておくべき3つの注意点

Lucy Editは画期的なモデルですが、完璧ではありません。以下の制限事項を理解した上で使用することが重要です。

1. 複数回の連続編集によるドリフト

⚠️ 注意点:

同じ動画に対して連続的に複数の編集を行うと、徐々にドリフト(ずれ)やアーティファクト(画像の乱れ)が蓄積する可能性があります。

対策:

大きな変更が必要な場合は、一度に複数の指示を組み合わせたプロンプトを作成することをお勧めします。

2. グローバルなスタイル変換の難しさ

⚠️ 注意点:

実写からアニメ風など、ドメイン全体を大きく変えるようなスタイル変換では、アイデンティティが歪む場合があります。

対策:

スタイル変換は、比較的近いドメイン間(例:明るい色調から暗い色調)で行うと、より良い結果が得られます。

3. 挿入オブジェクトの動作制御

⚠️ 注意点:

挿入された動的なオブジェクト(人物など)は、シーンとの整合性のある動きをしますが、特定の意図的な行動を取らせることはできません。

例:

生成された人物は自然に歩きますが、「手を振る」「走り出す」といった特定のアクションを指示することは現時点では困難です。

なぜLucy Editが重要なのか|動画編集AIの新時代

Lucy Editは、マニュアル作業なしのCG合成を実現したと言えます。テキスト入力だけで、高い忠実度、時間的安定性、リアリズムを備えた編集が可能です。

オープンウェイトモデルの意義

🔓 重要なポイント:

Lucy EditのDevモデルはオープンウェイトで公開されています。これは、研究者がRunwayやPikaのようなクローズドAPIに依存せずに、この能力を活用できることを意味します。

より高性能なProモデルも、プロダクション用途向けに有料APIとして提供されています(fal.aiで1秒あたり$0.15-0.30)。

技術的なブレークスルー

Lucy Editのリリースが重要な理由は、以下の点で従来の常識を覆したからです:

✅ 外部条件付け(マスク、深度マップなど)が不要

✅ 推論時の最適化処理が不要

✅ オープンモデル形式で提供

これは、他の研究者や開発者が今後構築していくための強固な基盤となります。

まとめ|今すぐLucy Editを試してみよう

Lucy Editは、動画編集AIの世界に革命をもたらす技術です。テキスト入力だけで、プロレベルの動画編集が誰でも手軽に行えるようになりました。

この記事のポイント

- 📝 テキストのみで動画編集:マスクや注釈は一切不要

- 🎯 4つの強み:プロンプト忠実性、アイデンティティ保持、時間的一貫性、リアリズム

- 🔧 Rectified Flow技術:高速で安定した編集処理を実現

- 🎬 実用的な活用例:クリエイティブ制作からポストプロダクションまで幅広く対応

- 🔓 オープンモデル:研究者も開発者も自由にアクセス可能

次のステップ|実際に試してみましょう

Lucy Editを最大限活用するために、以下のステップで始めてみてください:

- シンプルな編集から始める

まずは「服の色を変える」「背景を変更する」といった基本的な編集から試してみましょう。 - プロンプトを工夫する

具体的で明確な指示を与えるほど、より良い結果が得られます。 ❌ 「かっこよくして」

✅ 「黒革のジャケットに変更し、背景を都会の夜景にする」 - パラメータを調整する

様々な設定を試しながら、自分の用途に最適な組み合わせを見つけていきましょう。 - コミュニティに参加する

他のユーザーの事例を参考にしたり、自分の作品を共有したりすることで、さらなる発見があるはずです。

🚀 最後に

AI動画編集の世界は、Lucy Editの登場によって新しいステージに入りました。この技術をマスターすれば、あなたのクリエイティビティをこれまで以上に自由に表現できるようになります。ぜひ、実際に手を動かして、その可能性を体感してください!

この記事の著者

Mehul Gupta

DBS銀行のデータサイエンティスト。生成AIの実務活用や教育に精通し、情報発信も積極的に行う。

Mehul Gupta(メフル・グプタ)は、DBS銀行のデータサイエンティストであり、 著書『LangChain in Your Pocket』の著者としても知られています。 AIや機械学習の知見を発信するプラットフォーム「Data Science In Your Pocket」を主宰し、 Mediumでは350本以上の技術記事を執筆するトップライターとして活躍中です。 過去にはTata 1mgにて医療データのデジタル化にも取り組みました。 趣味はギター演奏とAI教育への貢献です。

この記事は著者の許可を得て公開しています。

元記事:https://medium.com/data-science-in-your-pocket/lucy-edit-ai-model-for-video-editing-642f442685de

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&著書『ChatGPT最強の仕事術』は4万部突破。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。