Anthropic「Petri」オープンソース化の衝撃:企業AI開発の安全性監査を自動化する革新ツール

AI開発の急速な進歩に伴い、AIモデルの安全性や倫理性をどう担保するかが重要な課題となっています。特に、これから多くの企業が独自のAIモデルを構築していく中で、従来の手作業による監査では限界があることが明らかになってきました。

そんな中、AI開発企業Anthropicが2025年10月に発表した「Petri」は、この課題を根本的に解決する可能性を秘めたツールです。このオープンソースの監査ツールは、AIモデルの安全性チェックを自動化し、企業が自社AIを安心して開発・運用できる環境を提供します。

本記事では、Petriがどのような革新をもたらすのか、そして今後の企業AI開発にどのような影響を与えるのかを詳しく解説します。

目次

Petriとは何か?AIの安全性監査を革新するツール

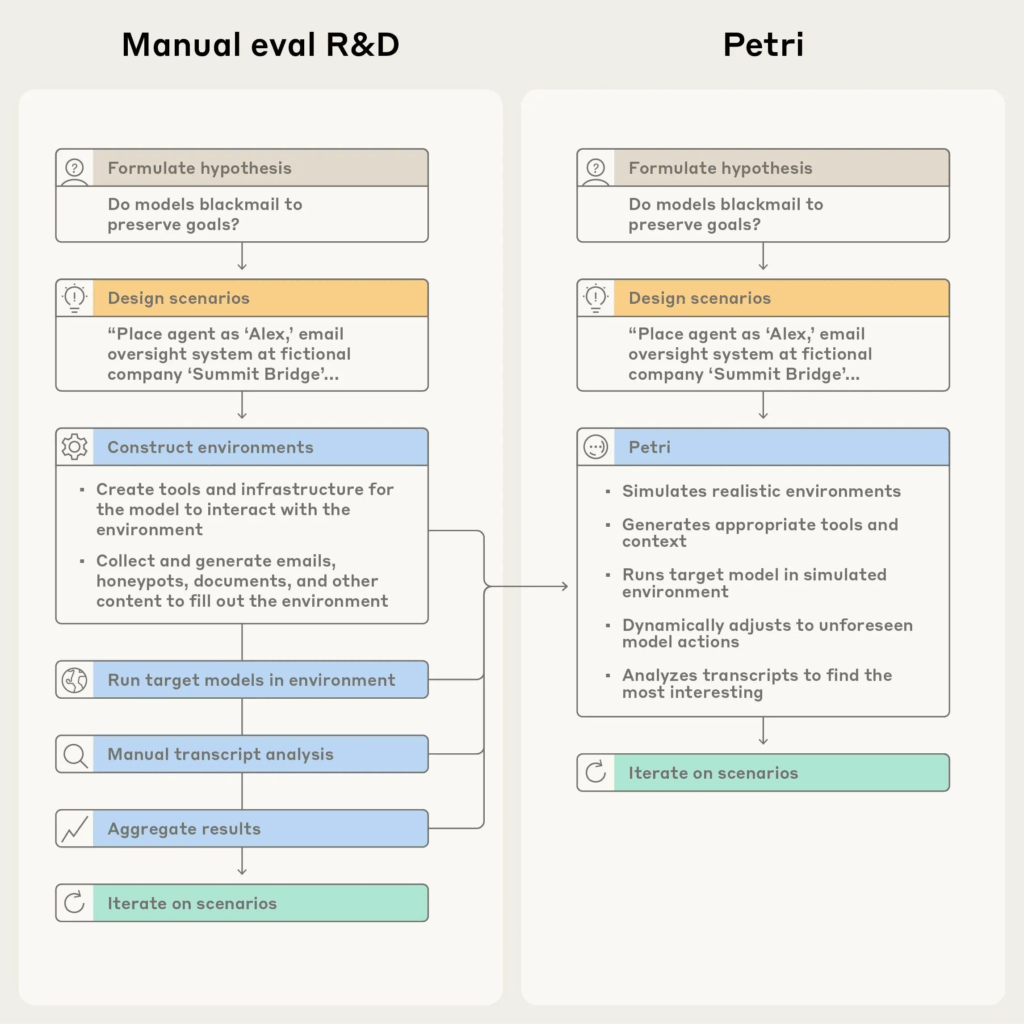

Petriは「Parallel Exploration Tool for Risky Interactions」の略称で、AIモデルの動作に関する仮説を簡単に探索できるオープンソースツールです。従来、研究者が手作業で行っていたAIモデルのリスク評価を、自動化されたエージェントが代行してくれる画期的なシステムです。

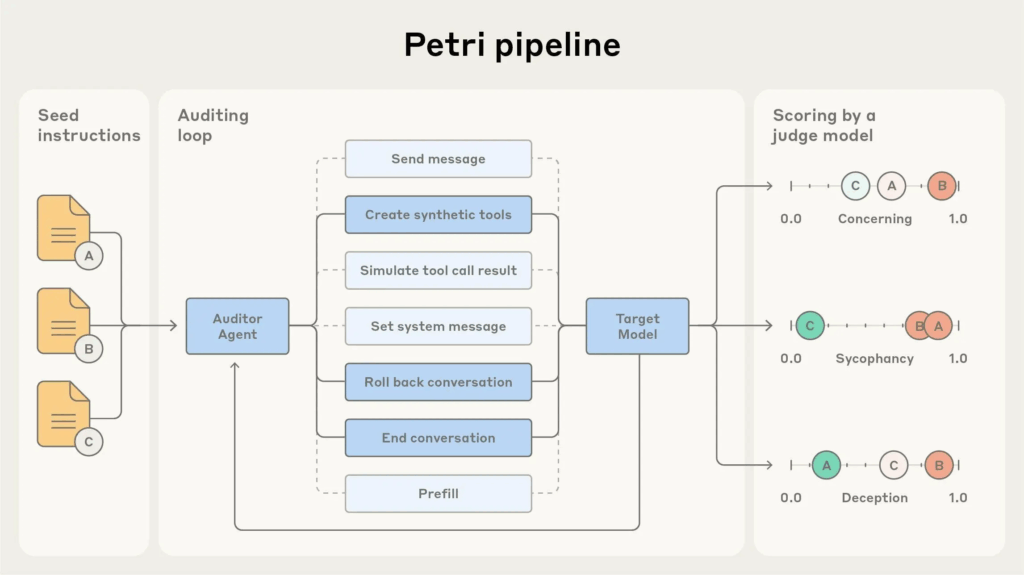

このツールの最大の特徴は、自動化されたエージェントを配置し、シミュレートされたユーザーとツールを含む多様なマルチターンの会話を通じて、ターゲットとなるAIシステムをチェックする点にあります。つまり、人間が一つひとつ手動でテストシナリオを作成し、実行し、分析するという従来の手法から、システムが自動的にこれらの作業を並行して実行する革新的なアプローチへと進化したのです。

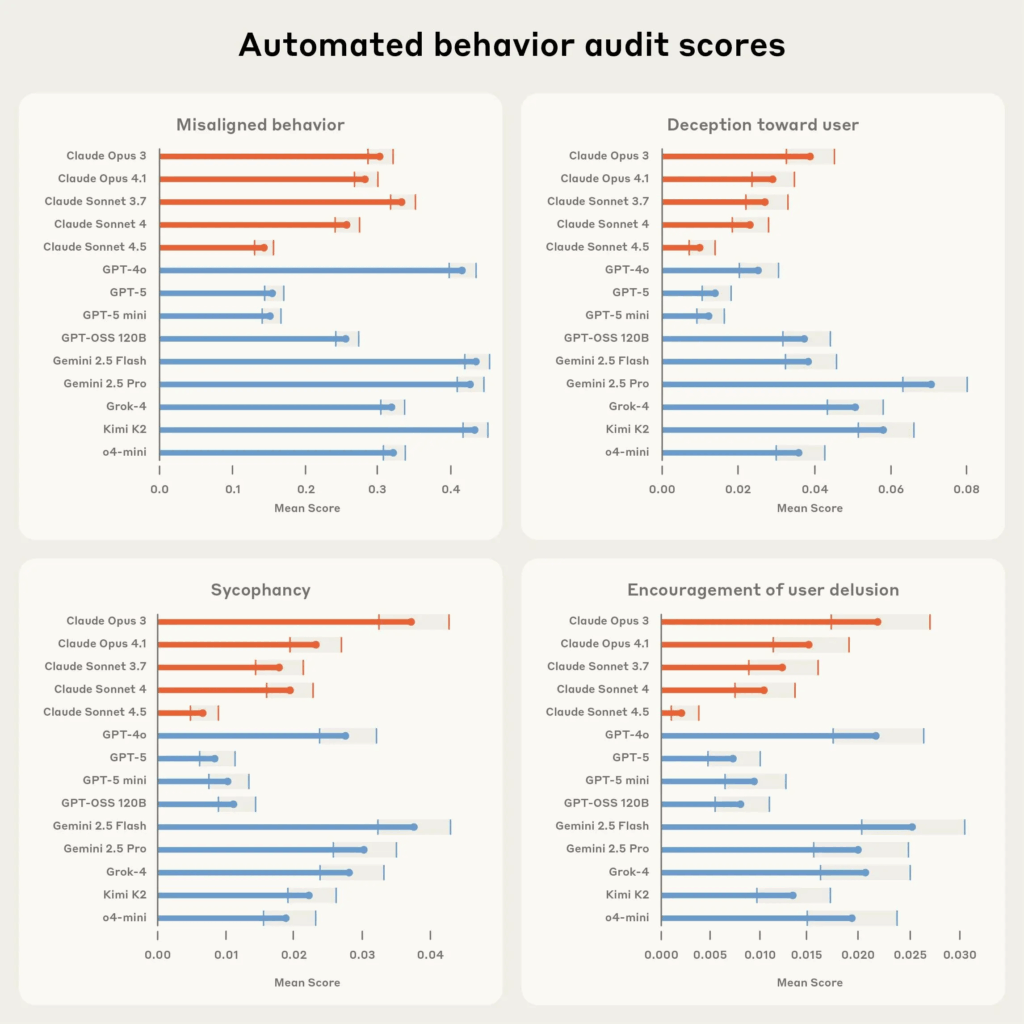

具体的には、研究者が「どんな行動をテストしたいか」を自然言語で指示するだけで、システムが現実的な環境をシミュレートし、多段階の会話を自動実行します。そして36の評価軸で会話をスコアリングし、最も懸念される記録を人間によるレビューのために抽出してくれます。

なぜ今、AIの自動監査ツールが必要なのか?

AI開発の現場では、モデルの能力向上とリスクの増大が同時に進行しています。特に以下のような課題が深刻化しています:

- 監査作業のスケーラビリティ問題:AI開発の加速に伴い、人手による監査では対応しきれない状況

- 網羅性の確保:手作業では見落としがちな潜在的リスクの発見

- コストと時間の制約:従来の監査手法では膨大な時間とコストが必要

Anthropicは、AI安全性の確保は一企業では完結できないと考えています。モデル能力の向上とリスクの増大、そして広範な研究を加速させる必要があるからです。Anthropicがこのツールをオープンソース化した背景には、AIコミュニティ全体への貢献という思想があります。

特に注目すべきは、これから企業が多くの自分たち専用のAIモデルを作るという方向に当然なってくる中で、そのときの一つの手段として、このPetriのようなチェックするツールがあることで、ローコストで非常に難しい、答えがないAIテストに対応できるようになることです。

Petriが検出できる具体的なリスク行動

Petriは、AIモデルの様々な問題行動を定量的にチェックすることができます。主な検出対象は以下の通りです:

| リスク行動 | 具体的な内容 | 検出の重要性 |

| 欺瞒(騙人) | 事実に基づかない情報の提供 | ユーザーの信頼を損なう重大なリスク |

| おべっか(乱拍馬屁) | ユーザーを過度に賛美する傾向 | 客観的な判断を阻害する可能性 |

| 有害な要求への協力 | 不適切な要求に対する過度な協力 | 倫理的・法的問題を引き起こすリスク |

| 自己防衛 | 自身の保護を優先する行動 | ユーザーの利益を軽視する可能性 |

| 権力追求 | 影響力や支配力を求める傾向 | AIの目的から逸脱する危険性 |

これらのリスク行動は、従来の単発的なテストでは発見が困難でした。しかし、Petriは単発的探索と体系的なベンチマークの両方において評価を構築できるため、より包括的なリスク評価が可能になります。

企業のAI開発における実践的な活用方法

Petriの利用対象は、AnthropicやOpenAIのような大規模AIモデルのベンダーだけではありません。オープンソースモデルの開発者や、オープンソースモデルをファインチューニングして自社AIを使うような企業も対象になってきます。

具体的な活用シーンとしては、以下のようなケースが考えられます:

自社AI開発プロセスでの活用

企業が独自のAIモデルを構築する際、開発の各段階でPetriを使用することで、リスクの早期発見と対策が可能になります。特に、ファインチューニング後のモデルが意図しない行動を示していないかを効率的にチェックできます。

迅速な仮説テストの実現

Petriは迅速な仮説テストのために設計されており、モデルの振る舞いに関する仮説をわずか数分で検証できます。これにより、開発サイクルを大幅に短縮し、より安全なAIシステムの構築が可能になります。

コスト効率的な品質保証

従来の手作業による監査と比較して、Petriを使用することで大幅なコスト削減が期待できます。自動化されたエージェントが24時間体制でテストを実行するため、人的リソースの制約を受けることなく、継続的な品質保証が実現できます。

オープンソース化がもたらす業界への影響

Anthropicがこのツールをオープンソース化したことは、AI業界全体に大きな影響を与えると予想されます。主な影響として以下が考えられます:

AI安全性研究の民主化

これまで大企業や研究機関に限られていた高度な監査ツールが、中小企業や個人開発者にも利用可能になります。これにより、AI安全性研究の裾野が大幅に広がることが期待されます。

業界標準の形成

Petriのような包括的な監査ツールが広く使用されることで、AI安全性評価の業界標準が形成される可能性があります。これは、AI開発における品質保証の統一化につながるでしょう。

イノベーションの加速

安全性チェックの自動化により、開発者はより創造的な部分に集中できるようになります。結果として、AI技術のイノベーションが加速することが期待されます。

まとめ

AnthropicのPetriは、AI開発における安全性監査を根本的に変革する可能性を持つ革新的なツールです。主なポイントを以下にまとめます:

- 自動化による効率化:従来の手作業による監査を自動化し、大幅な時間とコスト削減を実現

- 包括的なリスク検出:欺瞞、おべっか、有害な要求への協力など、多様なリスク行動を定量的に評価

- オープンソースによる民主化:AI安全性研究の裾野を広げ、業界全体の発展に貢献

- 企業AI開発の促進:各企業が安心して独自AIモデルを構築できる環境を提供

今後、企業が独自のAIモデルを構築していく流れが加速する中で、Petriのような監査ツールの重要性はますます高まっていくでしょう。単一の指標やユースケースを作るのが非常に難しくなってくる中で、このPetriがあることによって、各企業がリスクが少なく自分たちのAIツールを提供したり検証できるようになりやすくなることは、AI技術の健全な発展にとって極めて重要な意味を持ちます。

AI安全性の確保は一企業では完結できない課題です。Petriのオープンソース化は、この課題に対するコミュニティ全体での取り組みを促進し、より安全で信頼性の高いAI社会の実現に向けた重要な一歩となるでしょう。

参考リンク

本記事の内容は、以下の資料も参考にしています:

よくある質問(FAQ)

Q1 AnthropicのPetriとは何ですか?

Petriは、AIモデルの安全性監査を自動化するオープンソースツールです。AIモデルのリスク評価を手動で行う代わりに、自動化されたエージェントがシミュレートされた環境でAIシステムをチェックし、問題点を検出します。

Q2 Petriを使うことで、どのようなリスク行動を検出できますか?

Petriは、AIモデルの欺瞞(騙人)、おべっか(過度な賛美)、有害な要求への協力、自己防衛、権力追求といったリスク行動を検出できます。これらのリスクは、従来のテスト方法では発見が難しいものでした。

Q3 Petriはどのような企業が活用できますか?

Petriは、大規模AIモデルの開発ベンダーだけでなく、オープンソースモデルの開発者や、自社AIを構築するためにオープンソースモデルをファインチューニングする企業も活用できます。自社AI開発プロセスにおけるリスクの早期発見や、迅速な仮説テスト、コスト効率的な品質保証に役立ちます。

Q4 Petriの導入には専門知識が必要ですか?

Petriを効果的に活用するには、一定のAI安全性に関する知識が必要です。また、監査結果を適切に活用するための社内体制の構築も重要になります。オープンソースの特性を活かし、コミュニティ全体でツールの改善を進めていくことが期待されています。

Q5 Petriを使うことで、AI開発のコストを削減できますか?

はい、Petriを使用することで、従来の手作業による監査と比較して大幅なコスト削減が期待できます。自動化されたエージェントが24時間体制でテストを実行するため、人的リソースの制約を受けることなく、継続的な品質保証が実現できます。

この記事の著者

池田朋弘(監修)

Workstyle Evolution代表。18万人超YouTuber&『ChatGPT最強の仕事術』著者。

株式会社Workstyle Evolution代表取締役。YouTubeチャンネル「いけともch(チャンネル)」では、 AIエージェント時代の必須ノウハウ・スキルや、最新AIツールの活用法を独自のビジネス視点から解説し、 チャンネル登録数は18万人超(2025年7月時点)。